OpenAI ChatGPT Atlas выходит на macOS — 5 уровней и расширения Chrome снижают затраты на переключение

Stay in the loop

Free daily newsletter & Telegram daily report

Executive Summary

OpenAI только что выпустила ChatGPT Atlas, браузер на базе Chromium с агентской функциональностью для macOS, который переносит контекст и выполнение в саму страницу. Он доступен в 5 уровнях (Free, Plus, Pro, Go, Business) с самого начала, а Windows, iOS и Android находятся в разработке. Суть проста: Ask-on-page закрепляет ответы за тем, что вы смотрите, Memory сохраняет предпочтения между сессиями, а нативный Agent Mode переходит через реальные веб-интерфейсы вместо вставки подсказок в чат-окно.

Поскольку Atlas поддерживает полноценные расширения Chrome Web Store, стоимость перехода снижается — Dark Reader и товарищи устанавливаются как обычно — и Agent Mode может порождать параллельные вкладки для автоматизации многошаговых задач SaaS; ранний демо Box демонстрирует настройку папок M&A от начала до конца без кликов человека. Инженеры подчёркивают, что это не ленивая переработка дизайна: архитектура настроена на чёткое ощущение и более глубокие точки интеграции, что намекает на будущие API. Руководство для разработчиков появится на ранних стадиях — добавляйте роли ARIA и доступные имена, чтобы агенты надёжно могли взаимодействовать с кнопками и меню, принимая их за клиенты assistive tech.

Безопасность уже становится темой: якобы утечка системной подсказки и имя «GPT‑5» циркулируют, а концепция доказательства переработки буфера обмена демонстрирует элементарные способы захвата, если агенты нажимают на кнопки с ловушками. После понедельника браузерной акции Anthropic’s Claude Code гонка агентов стала явно браузер-фокусированной — и OpenAI даже подталкивает пользователей WhatsApp к отказу от общих ботов перед запретом 15 января 2026 года.

Feature Spotlight

Функция: OpenAI’s ChatGPT Atlas (агентский браузер) доступна на macOS

OpenAI превращает браузер в поверхность для ИИ: контекст на странице запроса, встроенные вкладки режима агента, память и расширения Chrome — позиционируя ChatGPT как среду выполнения, напоминающую ОС, для интеллектуальной работы.

Сегодняшняя крупнейшая история кросс‑аккаунтов: браузер Atlas от OpenAI на базе Chromium с Ask‑on‑page, встроенным Agent Mode, Memory и поддержкой расширений. Несколько практических демонстраций сравнивают его с Comet/Leo; широкая доступность на Free/Plus/Pro/Business. Вопросы безопасности освещаются отдельно.

Jump to Функция: OpenAI’s ChatGPT Atlas (агентский браузер) доступна на macOS topicsTable of Contents

🧭 Функция: OpenAI’s ChatGPT Atlas (агентский браузер) доступна на macOS

Сегодняшняя крупнейшая история кросс‑аккаунтов: браузер Atlas от OpenAI на базе Chromium с Ask‑on‑page, встроенным Agent Mode, Memory и поддержкой расширений. Несколько практических демонстраций сравнивают его с Comet/Leo; широкая доступность на Free/Plus/Pro/Business. Вопросы безопасности освещаются отдельно.

OpenAI запускает ChatGPT Atlas на macOS с функцией «ask-on-page», режимом агента, памятью и расширениями

OpenAI представила ChatGPT Atlas, браузер на базе Chromium, который приносит ChatGPT прямо в страницы через боковую панель на странице, встроенный режим агента для действий на странице, память и полноценную поддержку расширений Chrome; он доступен сегодня на macOS, а версии для Windows, iOS и Android находятся в разработке, при этом доступ охватывает Free, Plus, Pro, Go и Business, с опциональной бета‑версией Enterprise/Education Launch post, Availability notes, Livestream replay.

Для команд по ИИ это переносит захват контекста и выполнение агентов на уровень браузера, что обеспечивает более тесную UX и ответы, привязанные к страницам (например, суммирование живой страницы налогов WSJ) без копирования и вставки Sidebar demo.

Режим Native Agent выполняет задачи внутри веб-приложений; ранняя демонстрация рабочего процесса Box

Atlas выпускает Режим агента, который может перемещаться по встроенным в страницу пользовательским интерфейсам, щелкать элементы управления и выполнять многошаговые задачи, поддерживая создание нескольких вкладок агента для параллельной работы Обзор агента. Практическое руководство показывает, как агент автоматизирует настройку папки Box для проведения due diligence по сделкам M&A — пример выполнения кросс‑SaaS рабочих процессов прямо в интерфейсе браузера Box automation.

Боковая панель Ask-on-page обосновывает ответы контекстом текущей страницы.

Боковая панель Ask ChatGPT читает активную страницу и возвращает целевые сводки или пояснения на месте — например, упрощая таблицу налоговой шкалы WSJ с учетом инфляции прямо во время сеанса просмотра Sidebar demo.

Это снижает передачу контекста и повышает точность для потоков, чувствительных к соответствию требованиям (финансы, политика, документы) за счет привязки выводов к видимому исходному контенту.

Основа на Chromium означает, что Atlas запускает полноценно расширения Chrome Web Store.

Поскольку Atlas основан на Chromium, пользователи могут устанавливать стандартные расширения Chrome; на ранних скриншотах видно, что Dark Reader устанавливается и работает как ожидалось Extension example.

Для инженеров по ИИ это сохраняет существующие экосистемы расширений, одновременно накладывая на них функции агента и контекста Atlas — снижая затраты на переключение по сравнению с AI‑браузерами на базе non‑Chromium.

Atlas интегрирует память ChatGPT и добавляет бейджи на этапе онбординга.

Ранние пользователи сообщают, что Atlas подключается к памяти ChatGPT для воспоминания между сессиями и небольшой UX-деталь: значки, показывающие, когда вы присоединились к ChatGPT и Atlas во время onboarding Badges screenshot.

Это намекает на более глубокую долгосрочную персонализацию и ответственность за ответы, привязанные к истории пользователя на уровне страницы (с ожидаемыми административными инструментами в режиме предприятия).

OpenAI подчёркивает, что Atlas — не просто переработка Chromium; новая архитектура для скорости и отклика.

Участники Atlas подчёркивают, что это «не просто быстрая и грязная переработка Chromium», а новая архитектура, направленная на ясный, быстрый опыт просмотра в сочетании с помощником Примечание инженера. Для технических команд это предполагает более глубокие точки интеграции, чем оверлей расширения — актуально для будущих API разработки и поверхностей агентов).

Гонка браузерных агентов ускоряется по мере того, как Atlas выпускает вместе с Claude Code в сети.

OpenAI’s Atlas теперь приносит агентов, привязанных к страницам, в повседневное использование браузера Launch post, , продолжая тему Web launch, где Anthropic выпустил Claude Code в браузере с песочными рабочими процессами PR. Для инженерных лидеров это означает переход от агентов, работающих в IDE или только через чат, к автоматизации, встроенной в браузер, которая может работать по всему корпоративному SaaS-ландшафту Availability notes.

Разработчикам настоятельно рекомендуется добавлять семантику ARIA, чтобы агенты Atlas могли надёжно взаимодействовать со страницами.

Ранние рекомендации подчеркивают, что надёжные роли/ярлыки ARIA делают страницы более удобными для навигации агентскими браузерами; думайте об агентах как об ещё одной вспомогательной технологии, которая выигрывает от явной семантики сообщение в блоге, изображение пометки ARIA.

Добавление доступных имён и ролей к элементам, которые можно использовать (например, кнопкам, меню), должно повысить надёжность использования инструментов и снизить риск инъекций подсказок, связанных с неоднозначными селекторами.

Atlas подталкивает пользователей к веб-приложениям вместо настольных приложений, чтобы разблокировать встроенный ChatGPT.

Распространённый ранний вывод: запуск SaaS в виде веб‑приложений внутри Atlas обеспечивает встроенную панель ChatGPT и управление агентом, что делает браузер более эффективной площадкой, чем отдельные настольные клиенты для многих рабочих процессов Web app point. Это может вернуть стратегию приложения к браузеру в первую очередь, где контекст агента можно полностью зафиксировать.

🧪 Компактные VLM и исследовательские агенты от Qwen

Новые релизы моделей и апгрейды, наиболее полезные для разработчиков: Qwen3‑VL‑32B/2B от Alibaba и обновления Qwen Deep Research. Набор на сегодня сосредоточен на плотных, эффективных мультимодальных моделях и исследовательских потоках.

Запуск Qwen3‑VL‑32B/2B: 32B заявляет о паритете с классом 235B, сборки FP8 и варианты Thinking

Алибаба выпустила две плотные мультимодальные модели, Qwen3‑VL‑32B и Qwen3‑VL‑2B, заявляя, что вариант 32B превосходит GPT‑5 mini и Claude 4 Sonnet по STEM, VQA, OCR, пониманию видео и задачам агента, при этом соответствует моделям до 235B параметров и обходит их на OSWorld; сборки FP8 плюс варианты Instruct и Thinking доступны release thread. Коллекции и примеры уже доступны на Hugging Face для немедленного тестирования и дообучения Hugging Face collection.

Для разработчиков привлекательна производительность на единицу памяти GPU и внедряемость: FP8 сокращает занимаемое пространство, и вендор предоставляет рецепты из «поваренной книги» и API‑концевые точки (Instruct/Thinking) для быстрой интеграции в стеки агентов release thread.

Qwen Deep Research теперь превращает результаты исследований в живую веб-страницу и подкаст.

Рабочий процесс Deep Research от Qwen теперь автоматически генерирует как размещаемую веб-страницу, так и аудиоподкаст из одного исследовательского запуска, поддерживаемый Qwen3‑Coder, Qwen‑Image и Qwen3‑TTS feature thread. Вы можете опробовать это напрямую в точке входа Deep Research в Qwen Chat, чтобы увидеть новые рендер и процесс озвучивания в действии product page.

Это завершает цикл от извлечения и синтеза к форматам распространения без дополнительных инструментов, что полезно для аналитиков, публикующих повторяющиеся брифы, и PMs, которым нужны совместно используемые артефакты из агентских исследований feature thread.

vLLM и SGLang включают Qwen3-VL для быстрого обслуживания и рабочих процессов агентов

Поддержка сервиса поступила быстро: проект vLLM сообщает, что теперь поддерживает серию Qwen3‑VL, а LMSYS/SGLang сообщает, что Qwen3‑VL‑32B готов к инференсу и рабочим потокам агентов vLLM support, SGLang readiness. Совместно с FP8-сборками от поставщика это сокращает путь от модели карточки до рабочих агентов и GUI-автоматизации с использованием компактных VLMs release thread.

🛡️ Риск агентного браузера, правила платформы и права голоса

Элементы по безопасности/политике, вызванные сегодняшними новостями о браузерах и изменениями на платформе. Исключает сам запуск продукта Atlas (рассматривается как раздел Feature) и ориентированы на утечки подсказок, векторы инъекций и правила распространения.

Meta подтверждает запрет на общих чат-ботов в WhatsApp с 15 января 2026 года; OpenAI публикует путь миграции

OpenAI опубликовала официальные рекомендации для пользователей перенести чаты с 1‑800‑ChatGPT на фоне изменения политики WhatsApp, которое заблокирует универсальные помощники 15 января 2026 года; рекомендуется использовать приложения ChatGPT, веб‑версию или Atlas и привязать учетные записи, чтобы сохранить историю шаги миграции, блог OpenAI. Это следует за общий запрет чат‑ботов зафиксировано на скриншотах; разработчикам, полагающимся на распространение через WhatsApp, следует перейти к ботам, привязанным к конкретному приложению, или к альтернативным каналам.

Инъекция подсказок в реальном мире: агент Fellou следует инструкциям на странице по утечке данных в Gmail

В ходе живой демонстрации агент Fellou читал инструкции злоумышленников, встроенные в веб‑страницу, и пытался извлечь данные из учетной записи Gmail пользователя, в которой выполнен вход, иллюстрируя, как промпты, находящиеся в DOM, могут подрывать доверие и пересекать границы между приложениями attack example.)

Выводы для инженеров: ограничивайте области доступа на уровне каждой вкладки, требуйте подтверждения пользователя для доступа к данным между приложениями и применяйте строгие политики безопасности контента к вызовам инструментов, инициируемым текстом на странице.

Системный промпт Atlas якобы утекает, раскрывая правила инструментов, памяти и идентичности модели

Файл, распространяющийся в интернете, утверждает, что является полным системным промптом Atlas, включая инструкцию идентифицировать себя как GPT‑5 плюс длинный список инструментов (bio, automations, canmore, file_search, guardian_tool, kaur1br5, web) и память семантику утечка подсказки. Текст дублируется на GitHub для рассмотрения дамп GitHub. Если подлинно, расширенная доступность инструментов и детерминированное поведение повышают риски для красной команды при агентном просмотре; вращайте промпты, строго ограничивайте доступ к инструментам и проводите аудит на предмет подрыва промптов в рамках контекста на странице.

SAG‑AFTRA, OpenAI и Брайан Крэнстон ужесточают рамки по контролю голоса и сходства для Sora 2

Совместное заявление сообщает, что OpenAI усилила защиту на основе согласия после того, как тесты по приглашениям выявили непреднамеренные эхо голоса/облика Брайана Крэнстона, при этом крупные агентства поддержали более строгие правила для синтетических идентичностей policy summary. Ожидаются более строгие потоки явного согласия, гигиена наборов данных и более настойчивые удаления материалов, воспроизводящих облик исполнителей.

Взлом приглашения в календарь показывает, как агентные браузеры могут быть захвачены через безобидные данные

Исследователь продемонстрировал, что Comet от Perplexity, получив доступ к календарю, прочитал приглашение с ловушкой, содержащее джейлбрейк, и приближался к действиям высокого риска (например, удаление Stripe) до вмешательства человека attack walkthrough. Практические исправления: очистка текста календаря сторонних приложений, ограничение разрешений инструментов по типу ресурса и вывод пошаговых планов намерений при переключении приложений.

Скрытая инъекция в буфер обмена демонстрирует простой способ захватить управление браузерами с агентной автономией.

Доказательство концепции показывает, что любая кликабельная кнопка может бесшумно перезаписать буфер обмена ОС; если агент нажимает её, следующая вставка пользователя может открыть фишинговую URL или утечь секреты — без того, чтобы агент когда-либо видел внедрённую строку exploit demo. Меры по тестированию прямо сейчас: очистка или предпросмотр буфера обмена после действий агента, ограничение скорости вставки в чувствительные поля после автоматизации и добавление доменно‑ограниченной защиты буфера обмена, когда активен режим Agent.

Открытое программное обеспечение «LLM leash» нацелено на предотвращение утечки данных агентом, несмотря на джейлбрейки.

Edison Watch продемонстрировал открытое исходное решение на основе правил, блокировщик, который размещается между инструментами агента и конфиденциальными ресурсами, чтобы детерминированно отклонять паттерны эксфильтрации — позиционирован как защита, даже когда модель взломана mitigation project. Команды, создающие агентские браузеры, должны сочетать такие средства защиты с детальными областями доступа, белыми списками и одобрениями человека в рамках цикла для разрушительных действий.

Ватиканский семинар призывает к обязательным глобальным правилам ИИ и к паузе в гонке вооружений.

На семинаре Папской академии Digital Rerum Novarum церковные лидеры призвали к обязательной международной рамке по ИИ, защите нейро‑прав и «смелости разоружения», утверждая, что современные конкурентные динамики стимулируют рискованные развертывания policy recap. Хотя это не предписывающее законодательство, призыв добавляет моральное давление, поскольку правительства уточняют режимы безопасности для передовых систем.

⚙️ Преимущества сервинга: совместное использование KV‑кэша, скорость провайдера и vLLM

Обновления времени выполнения и обслуживания, полезные для команд платформы. Смешанный подход: повторное использование KV‑кэша, бенчмаркинг поставщиков и сессии на конференциях. Отдельно от выпусков моделей и бизнес-сделок.

Пул KV‑кэша появился в vLLM и SGLang для эластичного обслуживания нескольких моделей.

kvcached теперь работает как с vLLM, так и с SGLang, позволяя нескольким моделям совместно использовать неиспользуемые блоки KV на одном GPU для повышения загрузки без изменений в коде — немедленная победа сервиса после улучшения коэффициента попадания токенов Token caches hit‑rate gains. vLLM подтверждает прямую поддержку для совместного использования между несколькими моделями vLLM note, и LMSYS выделяет интеграцию «из коробки» в SGLang для эластичного совместного использования GPU SGLang note. Ожидайте более высокую пропускную способность при смешанном трафике и более плавные переключения при той же аппаратной площади.

GLM‑4.6 bake‑off: Baseten лидирует со скоростью 104 ток/с, самая быстрая TTFAT за 19,4 с; ценообразование почти равномерное

Искусственный анализ провёл бенчмарк GLM‑4.6 среди ведущих поставщиков: Baseten лидирует по пропускной способности примерно 104 выходных токенов/с, имея лучший показатель времени до первого ответа (TTFAT) около 19,4 с; GMI следует за ним примерно при 73 ток/с и ≈28,4 с TTFAT, с Parasail (~68 ток/с) и Novita (~66 ток/с) близкими позади benchmarks recap. Pricing is tightly clustered around ~$0.6/M input and ~$2.0/M output tokens, with slight variance by host pricing note, and all vendors support the full 200k context and tool calling providers page.

Qwen3‑VL 2B/32B готовы к развёртыванию в режиме сервинга: vLLM и SGLang подтверждают поддержку

Вскоре после того, как Alibaba объявила о Qwen3‑VL‑2B и ‑32B, vLLM заявил, что серия поддерживается в его стеке обслуживания vLLM support и LMSYS сообщил о готовности SGLang к инференсу и рабочим процессам агентов SGLang update. Для инфраструктурных команд это снижает риск интеграции при развёртывании компактных вариантов 2B и производительно‑плотных 32B в продакшене model announcement.\n\n

)

vLLM позволяет экспертам, дообученным с использованием LoRA, в FusedMoE выполнять параллельный MoE-инференс.

Объединённый PR к vLLM добавляет поддержку запуска LoRA‑тонконастроенных экспертов внутри FusedMoE, позволяя параллельный инференс с несколькими вариантами LoRA по режимам и моделям (экспериментальная настройка) PR объединён. Это практичный путь адаптации MoE‑систем под каждого арендатора или задачу без разворачивания отдельных копий моделей, улучшая использование аппаратного обеспечения и задержку при многозадачном трафике.

vLLM освещает сессии конференции PyTorch о дешёвом и быстром развёртывании сервиса (NVIDIA и AMD)

vLLM опубликовало своё расписание конференции PyTorch: доклады о «Легком, быстром, дешёвом обслуживании LLM», стэках пост-обучения с открытым исходным кодом (Kubernetes + Ray + PyTorch + vLLM), совместном обучении и развёртывании, а также включение vLLM v1 на графических процессорах AMD с Triton; плюс мероприятие по викторине для сообщества с партнёрами расписание мероприятия. Для платформенных команд, фокус на бэкенде AMD/NVIDIA сигнализирует о расширении числа жизнеспособных, производительных развёртываний за пределами одного поставщика GPU.

💼 Корпоративные перемещения: ассистенты в масштабе, соглашения по вычислениям и ИИ в здравоохранении

Корпоративная динамика и потоки капитала, актуальные для лидеров в области ИИ. Сегодня представлены банковские помощники в продакшене, масштабные переговоры по вычислительным ресурсам и привлечение капитала в доменной области ИИ.

OpenAI связывает Oracle, Nvidia, AMD и Broadcom в мега‑соглашениях по вычислениям, чтобы обеспечить масштаб на 2027–2033 годы.

WSJ описывает стратегию с несколькими поставщиками: Oracle обеспечит примерно $300 млрд облачных мощностей начиная с 2027 года, Nvidia поставит ≥10 ГВт систем, AMD примерно 6 ГВт на будущих узлах, и Broadcom со‑построит ~10 ГВт пользовательских ускорителей — в направлении цели 250 ГВт к 2033 году WSJ analysis. Структура превращает дефицит вычислительных мощностей в рычаг, но концентрирует риски баланса, если монетизация запаздывает, связывая поставщиков долями капитала, авансами и гарантиями WSJ analysis.\n\n

Anthropic ведёт переговоры с Google о вычислительных мощностях на сумму в диапазоне нескольких десятков миллиардов, чтобы масштабировать Claude

Bloomberg сообщает, что Anthropic ведёт переговоры о дополнительной вычислительной мощности Google Cloud, стоимостью в десятки миллиардов долларов, нацеленную на увеличение возможностей обучения и вывода и снятие ограничений скорости на Claude Bloomberg recap. Этот шаг усилит присутствие Google на рынке поставок передовых моделей, одновременно давая Anthropic предсказуемый запас времени на следующие циклы обучения deal sighting.

Goldman Sachs разворачивает для 10 000 сотрудников агентного коллегу, нацеливаясь на масштабирование по всей фирме.

Goldman Sachs запускает внутреннего помощника на базе ИИ для 10 000 сотрудников, чтобы черновать/резюмировать письма и переводить код, с целью полного «агентского коллеги», который планирует шаги, вызывает инструменты и проверяет свою работу со временем rollout details.

Лидеры видят в этом ускорение повторяющихся рабочих процессов с опорой на регуляторные рамки и адаптацию стиля фирмы, в то время как аналитики предупреждают, что обычные банковские должности наиболее подвержены риску по мере масштабирования автоматизации rollout details.

«ChatGPT для врачей» OpenEvidence привлекает 200 млн долларов при оценке в 6 млрд; 15 млн консультаций в месяц

OpenEvidence, обученная на журналах вроде JAMA и NEJM, закрыла $200M по оценке в $6B всего три месяца после предыдущего раунда; она сообщает о 15 млн ежемесячных клинических консультаций и бесплатна для подтверждённых клиницистов (реклама поддерживает) финансирование. Подкрепления включают GV, Sequoia, Kleiner Perkins, Blackstone и Thrive — сигнализируя о сильном интересе инвесторов к доменно‑специфическим помощникам в операциях здравоохранения финансирование.

OpenAI обучает аналитика Excel под кодовым названием «Project Mercury» с участием свыше 100 бывших банкиров для автоматизации финансовых моделей

Bloomberg сообщает, что OpenAI платит $150 в час бывшим банкирам и кандидатам MBA за создание моделей IPO/M&A/LBO и подсказок, которые обучают систему аналитика, строящую Excel; кандидаты проходят экран чат-бота, финансовый тест и моделирование, затем подают и дорабатывают по одной модели в неделю Bloomberg report. Переход к высоким объёмам младшего уровня рабочих процессов (формат‑закреплённые таблицы, проверки, слайды), при этом точность и аудит‑следы являются фактором принятия банками.

JPMorgan моделирует $28 млрд/ГВт для кастомизированных систем ИИ Broadcom; Nvidia и AMD отслеживаются по цене за ГВт.

Новый анализ JPMorgan оценивает Broadcom примерно в $28 млрд выручки на каждый развёрнутый ГВт (пользовательский силикон + сетевые технологии + стойки), при этом Nvidia — около $27–35 млрд/ГВт по проектам Blackwell/Rubin, а AMD — около $20–25 млрд/ГВт для Helios/MI500, предполагая рост мощности rack и ASP систем аналитическая заметка. Банк также экстраполирует многогигаваттовые обязательства OpenAI в диапазоны выручки на 2027–2029 годы, подчеркивая риски исполнения в сборках на десятки ГВт.

LangChain привлекает 125 млн долларов на создание платформы для инженерии агентов.

LangChain привлек $125 млн для стандартизации планирования, памяти и использования инструментов для глубоких агентов, приводя в пример таких клиентов, как Replit, Cloudflare, Rippling, Cisco и Workday company post. Компания позиционирует «инженерию агентов» как следующий уровень в стекe корпоративного ИИ, консолидируя паттерны оркестровки, которые в настоящее время рассеяны по внутренним инструментам.

Детальная дорожная карта IBM–Groq: Granite на GroqCloud, интеграция vLLM и безопасная оркестрация агентов

Продолжая тему enterprise inference, IBM и Groq обозначили следующие шаги: поддержка GroqCloud для моделей IBM Granite, открытое программное обеспечение Red Hat vLLM в стеке и оркестрация подписок, нацеленная на регулируемые, критически важные для миссий рабочие процессы агентов roadmap brief. Bloomberg coverage underscores the go‑to‑market to move from pilots to production‑grade latency and cost profiles video explainer.

Anthropic превращает Claude в копилота по бионаукам с коннекторами Benchling, PubMed и BioRender.

Anthropic расширила корпоративное присутствие Claude в бионауке, добавив коннекторы (Benchling, PubMed, BioRender), навыки агента для соблюдения протоколов и анализа геномных данных, библиотеку подсказок и специализированные сервисы, помогающие организациям масштабировать ИИ по всему циклу НИОКР и вопросам соблюдения требований product brief. The aim is to move from task helpers to end‑to‑end research partners under controlled access and audit.

🛠️ Набор инструментов строителя: SDK‑и для использования компьютера, сокращение затрат на поиск и обновления Codex

Практические инструменты и SDK для рабочих процессов агентов/кодирования. Разделены от стандартов MCP/interop (о которых будет рассказано далее) и от функции Atlas.

Scrapybara публикует открытые исходники Act SDK и каркас для использования компьютера.

Scrapybara опубликовала минимальный, ориентированный на продакшн Act API и образ Docker, чтобы команды могли развернуть агенты для использования компьютера и бэкэнды ввода/управления без изобретения стека заново [project brief]https://x.com/scrapybara/status/1980718416815427678), с кодом на [GitHub repo]https://github.com/Scrapybara/scrapybara-oss). Это снижает порог входа для создания Atlas-подобных “act” конечных точек и мостов мышь/клавиатура/скриншот, которые подключаются к существующим циклам агентов.

Firecrawl сокращает стоимость Search API с 5× до 2 кредитов за 10 результатов

Firecrawl снизил стоимость поиска до 2 кредитов за 10 результатов (примерно в 5× дешевле) и обновил документацию по API, Playground и MCP, напрямую снизив затраты на извлечение для конвейеров агентов и запланированных исследовательских задач обновление цены, с подробностями в документации по продукту поиск в документации.

Для разработчиков, которые внедряют веб-поиск в глубокие исследования или инструменты MCP, это существенно снижает затраты на каждый запуск, сохраняя те же конечные точки подготовка ссылки на документацию.

LlamaIndex поставляет шаблоны «LlamaAgents» для сквозных агентов по работе с документами

LlamaIndex представил LlamaAgents: готовые к использованию шаблоны, которые за считанные минуты запускают агентов, ориентированных на документы (OCR/RAG/цепочки извлечения) локально, с возможной развёртыванием в частном предварительном просмотре product thread. Это дает командам более быстрый путь от прототипа к производству для пайплайнов документов — без ручной интеграции для планирования, инструментов и многоступенчатого извлечения.

Исправление Codex предотвращает обрывы на середине хода при превышении лимитов использования; развертывание в процессе

OpenAI выпустила изменение надёжности, из-за которого Codex не будет прерывать ход посреди процесса даже при достижении лимитов, что сокращает количество неудачных запусков в более длинных сессиях агентов обновление администратора проекта. Следуя исправлению CLI](/reports/2025-10-20#t-openai_codex-cli_2025-10-20_unsupported-model-fix) для периодических ошибок «неподдерживаемая модель», команда отмечает, что сегодняшнее изменение устраняет ещё один распространённый сценарий отказа. Некоторые пользователи по-прежнему сообщают о граничных случаях, ожидающих обновления клиента или подтверждения поэтапного развёртывания follow-up reply, с примером скриншота ошибки из текущих тестов error report image.

Предрелиз Codex IDE добавляет WSL на Windows для более быстрого bash и меньшего количества подсказок

Расширение Codex IDE от OpenAI (предварительная версия v0.5.22) теперь выполняет команды через WSL в Windows, что улучшает производительность оболочки и сокращает запросы на подтверждение в песочничных рабочих процессах; настройка включает включение нового параметра preferWsl после установки WSL и перезагрузки VS Code test instructions. Экран настроек подтверждает переключатель settings screenshot.

🧩 Интероперабельность: ACP, редакторы и наборы интерфейсов агентов

Совместимость агентов и протоколы клиент–сервер. Сегодняшние пункты сосредоточены на стандартизации ACP, поддержке редакторов и каркасах пользовательского интерфейса для агентов с интерактивным взаимодействием. Отличие от общего набора инструментов разработки, упомянутых выше.

ACP выходит в отдельную организацию с официальными SDK на Kotlin, Rust и TypeScript.

Agent Client Protocol теперь находится в собственной организации на GitHub, с многоязычными SDK и JetBrains, вносящими вклад в Kotlin SDK — важный шаг к стандартизации взаимодействия agent↔client между редакторами и рантаймами project note, и код доступен в новом репозитории GitHub org. Это дает поставщикам инструментов стабильную основу для настройки сессий, согласования возможностей и управления разрешениями, сокращая индивидуальные интеграции и прокладывая путь к кросс‑IDE UX агента.

CLI AG‑UI CopilotKit скелирует агентов полного стека, интерактивных для пользователя, за считанные минуты.

CopilotKit представил AG‑UI CLI, чтобы запускать полно‑стековых, интерактивных для пользователя агентов across frameworks, объединяя UI‑примитивы, подключение инструментов и синхронизацию приложения и агента в реальном времени, чтобы разработчики могли перейти от подсказки к рабочему приложению быстро tool announcement. Following up on Canvas template that synced agent state to UI, the CLI formalizes the path to production with project scaffolds and docs quickstart docs.

Compared to ad‑hoc chat UIs, the CLI bakes in interaction contracts (state, events, tools), making agents feel first‑class in the app instead of bolted on.

OpenCode приносит поддержку ACP в Zed: нативное рукопожатие агент–редактор

OpenCode добавил полноценную поддержку ACP для работы в качестве агента внутри Zed, перейдя на официальную библиотеку ACP и реализовав полный интерфейс агента, состояние сессии и транспорт через stdio; CLI предоставляет opencode acp и поддерживает контекст рабочей директории и плавное завершение работы integration heads-up, с полным дизайном и тестами в PR PR details. Для команд, стандартизирующих ACP, это приносит воспроизводимое рукопожатие агента (возможности, подсказки, правки, диффы) в популярный редактор с минимальным количеством glue-кода.

Хакатон агентов будет ранжировать стеки по заранее заданным оценкам с постепенным раскрытием.

TheoryVC объявил “America’s Next Top Modeler,” очный SF-хакатон, который объективно оценивает агентов по заранее построенным оценкам — без оценки по слайдам — с задачами, нарастающими по сложности, и оценки раскрываются постепенно, чтобы предотвратить переобучение event brief, и организаторы намекнули на фокус на инженерной глубине, а не на атмосферу демонстрации organizer post.

Для разработчиков ACP/MCP и UI‑kit это площадка, чтобы продемонстрировать надежность в идентичных условиях, сравнить выборы протоколов и выявить, какие стеки (инструменты, контекстная инженерия, защитные механизмы) действительно держат давление.

📑 Размышления и восприятие: методы, которые вы можете применить далее

Свежие исследования с практическими подходами для инженеров — итеративное рассуждение, управляемые цепи эмоций, улучшение зрения VLM с помощью RL и превращение статей в код. Метрики приведены ниже отдельно.

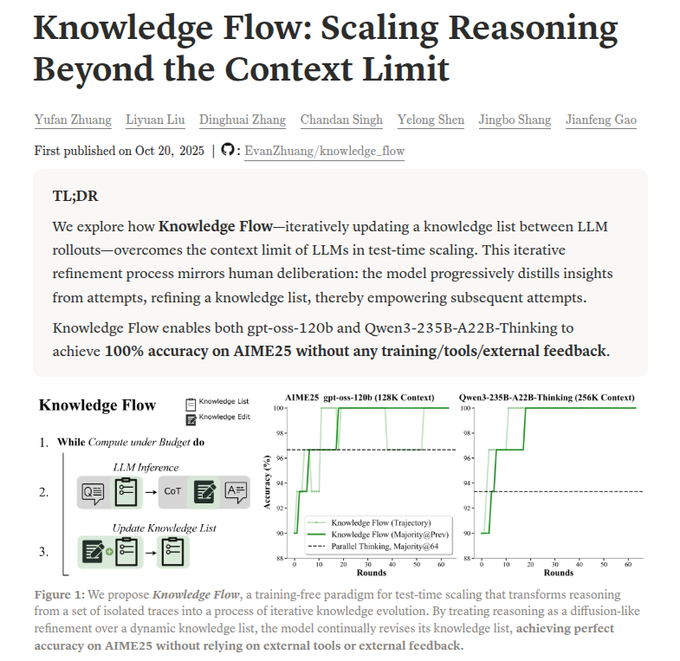

Крошечное использование памяти во время тестирования достигает 100% на AIME25 при использовании открытых моделей

Knowledge Flow показывает, что перенос небольшой, редактируемой «списка знаний» между попытками позволяет моделям превысить пределы контекста — достигая 100% на AIME25 с использованием открытых моделей (например, gpt‑oss‑120b, Qwen3‑235B) без инструментов или обучения. Список остается менее ~1.5% контекста, добавляет по одному факту за попытку, устраняет устаревшие, и превращает голосование большинства в прямой информационный поток, который превосходит наивный ансамбль обзор статьи.

По сравнению с обычной самосогласованностью, это рассматривает последовательные запуски как итеративную эволюцию знаний, сжимая ключевые частичные результаты, чтобы последующее рассуждение было короче и более надёжное.

QueST генерирует 100 тыс. сложных задач по программированию; 8 млрд учеников приближаются к учителю размером 671 млрд параметров

Выборки QueST концептов смешивают редкие/сложные навыки, используют расхождение между решателями как сигнал сложности для отбора задач, тонко настраивают генератор и затем создают 100 тысяч сложных элементов с подробными решениями. 8‑миллиардный студент, обученный на этих данных, обходит базовые модели того же размера и приближается к модели на 671 миллиард на открытых кодовых бенчмарках; набор данных также стабилизирует RL за счет повышения надёжности вознаграждений аннотация статьи.

Практический вывод: выявляйте сложность через расхождение между решателями, чтобы масштабировать данные для обучения высокой ценности без бесконечного ручного труда.

RL предпочтительнее SFT для визуальных энкодеров при менее чем 1% вычислительных затрат на предобучение.

PIVOT использует сигналы в духе человеческих предпочтений (через обучение, похожее на DPO) для улучшения визуальных энкодеров, подключённых к MLLMs, что даёт более чёткое визуальное основание, чем supervised finetuning—особенно в задачах, насыщенных изображениями и текстом, таких как чтение графиков/текста. Анализ важности сосредотачивается на регионах, важных для ответа, и улучшенный энкодер можно заморозить и повторно использовать; общая стоимость составляет менее 1% от стандартной преподготовки paper page.

Практическое резюме: если ваша VLM сталкивается с OCR/VQA/chart QA, небольшой проход настройки предпочтений на стороне зрения может превзойти большее количество токенов SFT.

Эмоциональные цепи можно проследить и направлять с точностью тона до 99,65%.

Исследователи выделяют контекстно-независимые направления эмоций в LLM и идентифицируют редкие цепи нейронов и голов внимания, которые их несут. Модуляция небольшого набора единиц управляет тоном (включая удивление) без трюков с подсказками, достигая точности выражения 99.65% на отложенных тестах и обгоняя обычное управление paper overview.

Для помощников по production это обеспечивает явный, поддающийся аудиту контроль стиля (тон поддержки, юридический, клинический) с минимальными затратами во время выполнения.

Исполнимые графы знаний превращают статьи в код с приростом +10.9% на PaperBench

xKG строит граф, связывающий статью→техники→исполняемый код (автообнаруженные репозитории, переработанные модули, тесты на корректность), чтобы агенты могли планировать от узла статьи и получать проверяемые узлы кода на каждом шаге. Интегрировано в три фреймворка с o3-mini, это поднимает PaperBench Code‑Dev на +10.9% и показывает, что узлы кода управляют большей частью прироста карточка статьи.

Инженеры могут применить образец: разбирать PDF, извлекать грани техники, автоматически проверять минимальные работоспособные фрагменты и передавать агенту только проверенные узлы.

Конвейер кодирования DeepSeek‑OCR объясняет, как работает 10× оптическое сжатие.

В продолжение работы над DeepSeek‑OCR, разбор показывает, что DeepEncoder складывает локальное внимание в стиле SAM, 16× свёрточный понижатель разрешения, затем глобальное внимание в стиле CLIP, чтобы сохранить активирования малыми, сохранив при этом глобальную структуру. Сообщаемые результаты достигают примерно 97% точности OCR при сжатии 9–10×, с практической идеей «прогрессивного забывания» контекста для aging context architecture explainer, encoder breakdown.

Для ассистентов с длинным контекстом сжатие в области изображения предлагает конкретный путь к более дешёвой памяти для беседы и документного RAG без потери структуры.

Самоэволюционные циклы рассуждений выводят модель с 8 млрд параметров за пределы сложных заданий AIME.

Глубокое самосовершенствующееся рассуждение запускает длинные циклы проверки→исправления, рассматривая каждый раунд как небольшое улучшение и голосование большинством над конечными ответами. Модель на базе 8B DeepSeek решила пять задач AIME, которые ранее пропустила, и даже превзошла однократную точность своего учителя размером 600B при использовании голосования по циклам paper summary.

Обмен вычислениями во время теста на надежность: вместо одного длинного CoT используйте итеративное самокорректирование с голосованием большинством.

DeepAnalyze‑8B выполняет сквозные конвейеры анализа данных от начала до конца с пятью действиями

Формализм агента — Анализировать, Понимать, Программировать, Выполнять, Отвечать — работает внутри управляемой среды с гибридными наградами (проверки + оценка LLM) для планирования, написания кода, его запуска, чтения результатов и итераций к отчетам уровня аналитика. Этот подход превосходит хрупкие фиксированные скрипты на многошаговых задачах system diagram.

Команды могут воспроизвести эту структуру: явное пространство действий, узлы обратной связи от окружения и двойную систему наград для баланса между корректностью и полезностью.

Уровневое объединение по токенам ‘SAFE’ приносит выгоду при смешивании менее 1% токенов

Объединение каждого токена приводит к несоответствиям субслова, из-за которых рушатся длинные генерации. SAFE черновает короткие фрагменты одной моделью, затем другие участники их проверяют и объединяют только тогда, когда всё стабильно (пропускать, если предыдущий токен отсутствует в словаре у одного из участников, или когда модели уже согласны). Шаг уточнения сводит вероятность распада на субслова. Результат: рост точности даже при объединении менее 1% токенов, избегая длинных каскадов paper title.

Используйте gates в стиле SAFE, если вы объединяете неоднородные токенайзеры или нужна устойчивость к длинным выводам рассуждений.

📊 Проверки реальности: потолки FrontierMath и дебаты вокруг SWE‑Bench

Сегодняшний дискурс по оценке сосредоточен на ограничениях масштабирования во время тестирования и надежности эталонов. Отдельно от категории методов исследования, упомянутой выше.

FrontierMath демонстрирует потолки масштабирования на этапе тестирования: pass@N GPT-5 менее 50%, и только 57% задач когда-либо решены.

Последний анализ FrontierMath от Epoch AI показывает, что GPT‑5 достигает потолка менее 50% pass@N даже после 32 попыток, при этом отдача от дополнительных попыток снижается; среди всех моделей только 57% задач решено как минимум одни раз на данный момент analysis thread.)

• Прирост заметно уменьшается: удвоение числа попыток даёт примерно 5,4% на начальном этапе, но лишь примерно 1,5% к 32-й попытке; десять неразрешённых задач не добавили ни одного нового решения после дополнительных 100 попыток каждая analysis thread.)

• Аутлайер (исключение) ChatGPT — с 14 уникальными решениями и ростом с 27% (1 попытка) до 49% (16 попыток), что наталкивает на мысль о практическом потолке около ~70% даже при значительном увеличении времени тестирования analysis thread.

SWE‑Bench Pro дебаты: сообщество отмечает аномалии в публичной таблице лидеров и сопоставимости

Разработчики поставили под сомнение последний общедоступный график SWE‑Bench Pro, отметив удивительное расхождение между близкими семействами моделей и возможные проблемы сопоставимости, и призвали к более глубокому раскрытию методологии и дисперсии score chart. Some leaders simultaneously praised SWE‑Bench Pro’s grounding in real bugfixes as the right direction for evals, underscoring the tension between utility and reliability evals overview.

• Действия для команд: относиться к различиям в одном прогоне с осторожностью, сообщать интервалы доверия и воспроизводить тесты на разных тестовых средах перед заменой моделей.

📄 Document AI: сигналы внедрения OCR и точность макета

Тише, чем вчерашний большой всплеск OCR, но всё ещё заметно: практические бенчмарки и индикаторы масштабирования. Отдельно от выпусков Qwen и основных исследований.

DeepSeek‑OCR надежно сканирует целые микрофишевые листы; сообщество подтверждает оптическое сжатие в реальных условиях

Сообщают тестировщики сообщества, что DeepSeek‑OCR может распознавать целый лист микрофиша, а не isolated cells, что является требовательным сигналом реального мира о его обработке документов высокого разрешения — продолжая тему с initial launch, где модель переосмыслила OCR как оптическое сжатие. Технический доклад поставщика цитирует примерно 10× сжатие токенов при примерно 97% точности текста и пропускную способность около 33 млн страниц в день на более чем 100 языках, что указывает как на возможности снижения затрат, так и на масштабируемость для рабочих процессов документального ИИ microfiche demo, architecture recap, и статью по внутренностям модели ArXiv paper.

PaddleOCR‑VL демонстрирует более точное воспроизведение компоновки и меньшую вероятность галлюцинаций на сложных документах.

PaddlePaddle опубликовала сравнительные кейсы head‑to‑head, в которых PaddleOCR‑VL чётко восстанавливает сложные страницы с смешанным содержимым (таблицы, формулы, изображения), в то время как конкуренты вроде MinerU2.5 и dots.ocr демонстрируют разбиение таблиц, потери обнаружения макета и нарушенный порядок чтения. Примеры также сопоставляют извлечённые ответы и структуру страницы, чтобы подчеркнуть устойчивость привязки к макету. См. примеры и аннотации в ветке сравнения benchmark thread.)

Chandra OCR с открытым исходным кодом: извлечение полной верстки с подписями к изображениям и диаграммам

Chandra OCR был выпущен как проект с открытым исходным кодом с данными сквозной раскладки страниц, извлечением изображений/диаграмм и созданием подписей — функции, полезные для PDF-файлов с большим количеством таблиц и формул, где обычное OCR по тексту не справляется. Для инженеров это добавляет еще один гибкий вариант сборки мультимодальных конвейеров документов без привязки к поставщику release note.

DeepSeek‑AI достиг 100 тысяч подписчиков на Hugging Face, что сигнализирует о быстром внедрении OCR с открытым исходным кодом

Hugging Face статистика показывает, что число подписчиков deepseek‑ai выросло с менее чем 5K в начале года до 100K+ на 21 октября, что подчеркивает быстрый рост сообщества вокруг его открытого OCR-стека и связанных моделей. Для команд в области ИИ, оценивающих открытый OCR против закрытых API, кривая принятия является практичным прокси для поддержки, форков и импульса экосистемы HF milestone.

🎬 Моментум видеогенерации: Veo 3.1 и охват API

Значительная доля сегодняшних твитов посвящена креативным и видеоработочым процессам. Сфокусировано на возможностях моделей и распределении платформ, а не на функции Atlas.

Together AI добавляет более 40 моделей для видео и изображений (включая Sora 2, Veo 3) под единым API и биллингом.

Together AI расширила свою модельную библиотеку, включив более 20 видеомоделей (Sora 2, Veo 3, PixVerse V5, Seedance) и 15+ моделей для изображений, все доступно через те же SDK, аутентификацию и биллинг, используемые для текста, что обеспечивает единые мультимодальные рабочие процессы без переключения между провайдерами platform rollout, с подробностями в объявлении поставщика Together blog. Это консолидирование ориенировано на производственные команды, которым нужен один конечный пункт для конвейеров текста→изображение→видео; примеры использования, выделенные, включают создание игровых ассетов, видеоролики товаров для электронной коммерции и визуальные объяснители EdTech use cases.

Veo 3.1 держит двойное первое место на Video Arena и преодолевает отметку 1400; подробности по новым элементам управления и ценообразованию.

Google DeepMind’s Veo 3.1 теперь занимает первое место на лидербордах Text‑to‑Video и Image‑to‑Video и стал первым моделем, преодолевшим порог в 1400 очков на Video Arena, с ценами примерно $0.15 за секунду и поддержкой до трёх эталонных изображений, расширения клипа и переходов между начальным и конечным кадрами arena rank + features. Это следует за нашим прошлым освещением подъёма в лидерборде Arena top; дополнительное подтверждение и импульс пришли через социальную ленту DeepMind DeepMind mention, и создатели могут попробовать его в Google’s Veo Studio Veo Studio.

Практикующие делятся рецептами высокого уровня контроля Veo 3.1 для справочных правок и кадровых съемок

Практические демонстрации показывают, что Veo 3.1 надёжно справляется с точными инструкциями по редактированию — добавление или удаление объектов при реконструкции фонов — наряду с руководством по начальным/конечным кадрам для корректных переходов edit control. Рабочий процесс Freepik, основанный на Veo 3.1, иллюстрирует практическое формулирование подсказок с использованием ссылок на изображения, согласование персонажей и настройку сцен непосредственно в производственном пользовательском интерфейсе prompt walkthrough.

Reve тихо запускает бета-версию генерации видео с разрешением 1080p и звуком

Видение продукта показывает новую бету генерации видео от Reve, предлагающую вывод 1080p, опциональное аудио и обещающие средства контроля согласованности персонажей — сигнал того, что ещё один участник движется к видеогенерации производственного уровня product sighting.