Qwen3‑VL 4B/8B запуск FP8-сборок — подход к производительности в 72B

Stay in the loop

Free daily newsletter & Telegram daily report

Executive Summary

Alibaba просто сократила свой флагманский стиль VLM до размеров, пригодных для ноутбуков: Qwen3‑VL поступает в вариантах “Instruct” и “Thinking” на 4B и 8B с FP8 сборками и минимальным потреблением VRAM. Почему это важно: команда утверждает, что эти компактные модели превосходят Gemini 2.5 Flash Lite и GPT‑5 Nano по задачам STEM, VQA, OCR, видео и агентским задачам, и часто достигают качества близкого к Qwen2.5‑VL‑72B — принося близко к флагманскому видению на повседневное оборудование без счета за дата‑центр.

Развертывание подчеркивает эргономику для разработчиков. Поддержка на Day‑0 в MLX‑VLM и LM Studio означает, что пользователи на Apple silicon могут запускать плотные и MoE локально на NPU/GPU/CPU, в то время как vLLM добавляет путь развёртывания производственного уровня с мощными выводами в JSON‑структуре и высокой пропускной способностью, по словам первых пользователей. Варианты 8B уже соперничают на LMArena в режимах Text и Vision, что является своевременным публичным читательским обзором после сильных визуальных позиций Qwen на прошлой неделе. Учебники поставляются с рецептами на уровне задач для OCR, grounding, multi‑image/video и агентских циклов, а ноутбуки TRL демонстрируют тонкую настройку SFT/GRPO на 4B-модели в бесплатном Colab — плюс Hugging Face Spaces и лёгкое в браузере приложение для быстрого прототипирования моделей. Вклад Kaggle завершает быструю оценку.

Если нужен более широкий ориентир, Ollama Cloud теперь предлагает Qwen3‑VL‑235B бесплатно, что упрощает сравнение объёмов памяти и возможностей перед стандартированием уровня.

Feature Spotlight

Особенность: Qwen3‑VL становится компактным (4B/8B) с почти флагманским VLM

Qwen3‑VL 4B/8B предоставляет почти флагманские мультимодальные возможности за долю VRAM, с FP8, cookbooks и поддержкой экосистемы на старте — продвигая серьёзные VLM на ноутбуки/телефоны и позволяя агентское зрение на краевых вычислениях.

Сегодня доминирует кросс‑аккаунт‑запуск: Qwen3‑VL 4B/8B от Alibaba (Instruct/Thinking) выходит с низким потреблением VRAM, FP8, cookbooks, поддержкой MLX/LM Studio и появлением в таблице лидеров — в основном охват выпуска моделей + поддержка разработчиков.

Jump to Особенность: Qwen3‑VL становится компактным (4B/8B) с почти флагманским VLM topicsTable of Contents

🧩 Особенность: Qwen3‑VL становится компактным (4B/8B) с почти флагманским VLM

Сегодня доминирует кросс‑аккаунт‑запуск: Qwen3‑VL 4B/8B от Alibaba (Instruct/Thinking) выходит с низким потреблением VRAM, FP8, cookbooks, поддержкой MLX/LM Studio и появлением в таблице лидеров — в основном охват выпуска моделей + поддержка разработчиков.

Запуск Qwen3‑VL 4B/8B: компактные модели, готовые к FP8, конкурируют с более крупными VLM.

Alibaba выпустила Qwen3‑VL в версиях 4B и 8B с вариантами «Instruct» и «Thinking», которые работают с меньшим объёмом VRAM при сохранении полного функционала, с сборками FP8 для эффективного развёртывания. Команда утверждает, что компактные модели обгоняют Gemini 2.5 Flash Lite и GPT‑5 Nano во всём спектре задач STEM, VQA, OCR, видео и агентов, и часто приближаются к производительности Qwen2.5‑VL‑72B release thread.

Коллекции Hugging Face и ModelScope, документация API и руководства по использованию доступны для немедленного применения Hugging Face collection, ModelScope collection, Thinking API docs, Instruct API docs, Cookbooks. Kaggle models.)

vLLM добавляет Qwen3‑VL, сигнализируя о пути обслуживания производственного класса.

vLLM выделил Qwen3‑VL как одну из самых популярных мультимодальных моделей, благодаря чему компактные VLMs можно легко разворачивать в существующих стеках вывода Python vLLM note. Ранние пользователи также отмечают мощные JSON‑структурированные выводы и высокую пропускную способность, полезные для конвейеров мультимодального API‑стиля json claim.

Гайдбуки, TRL-ноутбуки и Spaces сокращают время до достижения ценности для Qwen3‑VL

Книги разработчика охватывают OCR, сопоставление объектов, мультимодальные изображения/видео и рабочие процессы агентов, при этом README на GitHub прямо указывает на шаблоны задач cookbook note, GitHub readme. Общественные ноутбуки показывают day‑0 fine‑tuning (SFT/GRPO) на 4B-модели в бесплатном Colab, плюс Space от Hugging Face для сравнения с moondream3 с обнаружением объектов hf fine‑tune, Colab notebook, HF Space demo. Лёгкое приложение Hugging Face для модели 4B Instruct предлагает быстрый способ протестировать компактный VLM в браузере hf app.

}

Путь Day‑0 для Apple Silicon: MLX‑VLM и LM Studio локально запускают Qwen3‑VL

Qwen3‑VL (Dense & MoE) теперь поддерживается в MLX‑VLM, при этом разработчики отмечают опциональные устройства (MLX‑CUDA, CPU) и готовность к работе на устройстве; сообщества сообщают, что LM Studio + MLX работает на Apple Silicon также релиз MLX, использование на Mac. Alibaba усилила позиционирование «день нулевой поддержки на NPU, GPU, CPU», сигнализируя о практичном локальном цикле разработки для пользователей Mac поддержка NPU.

Qwen3‑VL‑235B бесплатно доступен на Ollama Cloud и дополняет компактное семейство моделей.

Ollama сделал доступным бесплатно в своем облаке 235B Qwen3‑VL с готовыми примерами для копирования (OCR по меню, математика с контекстом изображения), и говорит, что меньшие модели и полные оффлайн‑запуски на устройстве будут доступны скоро облачный запуск, Ollama blog. Это обеспечивает аналог крупной модели для новых компактных выпусков Alibaba 4B/8B для команд, тестирующих способность против компромиссов по размеру.

Qwen3‑VL‑8B присоединяется к битвам Text & Vision от LMArena.

Варианты 8B Thinking и Instruct теперь доступны в режимах Text и Vision LMArena для прямого сравнения подсказок и голосования сообщества arena entry, arena listing. Это следует после того, как Qwen3‑VL завоевал прочную позицию на визуальных треках, предлагая более лёгкий вариант для сравнения лицом к лицу Arena standing.

🆕 Поиск моделей: веб‑стек GPT‑5 становится доступным через API

Свежий выпуск модели, сфокусированный на веб-поиске в рабочих процессах разработки; исключён компактный запуск Qwen3‑VL, который рассматривается как функция.

OpenAI выпускает gpt‑5‑search‑api: веб‑поиск в Chat Completions на 60% дешевле с фильтрацией по доменам

OpenAI добавила выделенную модель веб‑поиска (gpt‑5‑search‑api) в Chat Completions, стоимостью $10 за 1,000 вызовов — примерно на 60% ниже, чем раньше — и она поддерживает фильтрацию по доменам, как инструмент Responses pricing update. The updated docs outline three modes—non‑reasoning lookups, agentic search with reasoning, and deep research—with copy‑paste snippets for JS, Python, Bash and C# OpenAI docs.

Engineers are already seeing both the undated and dated variants (“gpt‑5‑search‑api‑2025‑10‑14”) in the platform model selector, confirming availability beyond docs model list screenshot. Third‑party trackers also flagged the new IDs surfacing across the ecosystem, reinforcing the rollout signal model finder alert.

- Endpoint parity means domain allowlists/blocks now work the same in Chat Completions as in Responses, simplifying agent plumbing for grounded search.

- The 60% price drop encourages broader use of agentic and deep‑research traces; teams should still watch token budgets and throttle strategies in long sessions.

🛠️ Агентное кодирование: Codex, субагенты и делегирование от начала до конца

Сегодняшняя активность практиков чрезвычайна велика: обучение Codex CLI, предпросмотры в режиме планирования, субагенты Claude Code, долгосрочная сборка Cursor и интеграции Factory 1.8.

OpenAI запускает серию видеороликов по Codex и руководство по CLI для GPT‑5‑Codex

Разработчики OpenAI запустили серию видеоматериалов из нескольких частей, чтобы помочь командам начать работать продуктивно с Codex CLI и GPT‑5‑Codex, включая образцы установки и использования (npm i -g @openai/codex) series intro, с зеркальной публикацией, повторяющей рабочий процесс CLI install recap. Для более широкого контекста того, как Codex применяется в реальных продуктах и событиях, см. закулисное руководство OpenAI по использованию Codex для запуска демо DevDay и инструментов DevDay blog, и центральный хаб документации для углубленных руководств и примеров Codex hub.

Подагенты Claude Code становятся лучшей практикой для глубокой работы с репозиторием.

Практикующие сообщают о большом приросте качества и скорости, достигаемом за счет оркестрации Claude Code под‑агентов — мапперов репозиториев, анализаторов, читателей API, писателей — параллельно, затем объединяя их результаты, что превосходит однолинейных агентов в задачах сопоставления кода и авторинга демо подагента. Широкий паттерн «Deep Agents» подчеркивает структурированное планирование, оркестратор + специализированные подподагенты, агентный поиск, гибридную память и верификацию для выполнения задач длительностью несколько часов проект‑архитектура.

Вывод: разделяйте обязанности, держите контекст каждого агента чистым и собирайте результаты — особенно для генерации документации, миграций и каркасов новых функций.

Фабрика 1.8: делегировать задачи Linear, запустить безголовый «droid exec», и закрывать инциденты через Sentry×Linear

Выпуск Factory 1.8 подключает Droids к большей части стека разработки: назначайте задачи Linear для полного цикла от начала до конца

поток выпуска, упоминать @Factory в Slack‑потоках, чтобы запустить безголовую сессию и отслеживать прогресс передача через Slack, запускать неинтерактивные пакетные задачи с помощью droid exec для больших рефакторингов/тестов безголовый режим, и обрабатывать инциденты через Sentry с исправлениями, возвращаемыми в Linear поток инцидентов. Примечания к выпуску описывают элементы автономии и форматы вывода для использования в CI/CD примечания к выпуску. Окно разрешений в терминале в режиме «в нужный момент» усиливает безопасность редактирования и чтения файлов интерфейс разрешений.

Итог: Factory эволюционирует от чат‑агента к делегируемому помощнику разработчика, встроенному в процессы планирования, кодирования и дежурств.

Codex CLI v0.45 сокращает количество токенов примерно на 10% при сохранении того же качества; новые видеоролики по использованию демонстрируют рабочие процессы.

Инженеры OpenAI заявили, что Codex CLI v0.45 сделал взаимодействия примерно на 10% более экономичными по токенам при том же качестве результата efficiency note. Затем старший IC также поделился личным обзором повседневного использования workflow video, а обзор DevDay описывает более широкие применения Codex, охватывающие демонстрации на сцене и разработку приложений DevDay blog. Команды, выпускающие Codex, могут ожидать меньшую стоимость за цикл и более понятные схемы для многопод tab, multi‑task рабочих процессов.

Cursor-агент работает круглосуточно, чтобы выпустить работающее приложение для управления проектами.

Разработчик запустил агент Cursor в непрерывном цикле с Sonnet 4.5 (CLI), минимальным начальнным контекстом и автономным отслеживанием прогресса до стадии «завершено», что привело к функциональному приложению управления проектами (PM) и удивительно удобной структуре кода overnight run, с заметками о минимальной начальной области и том, что улучшилось при небольшом дополнительном контексте run notes. Экран демонстрирует получившийся пользовательский интерфейс и структуру репозитория app snapshot.

Почему это имеет значение: полная реализуемость end‑to‑end для проектов с нуля выходит за рамки демонстрации и переходит к практике; следующий рубеж — усиление тестированием, безопасностью и производственной CI/CD.

Vercel поставляет шаблон агента Slack и библиотеку Bolt для создания агентов внутри Slack.

Vercel продемонстрировала v0, работающий прямо в Slack на Dreamforce, и выпустила библиотеку Slack Bolt вместе со стартовым шаблоном, позволяющим командам запрашивать данные, строить дашборды и отправлять действия агентов, не выходя из чата stage demo, с шаблоном для быстрого создания Slack-агентов agent starter.

Это снижает необходимость в «клеевом коде», чтобы привести агентов LLM туда, где работа уже происходит — в каналы, ветки и личные сообщения, с путём к продакшн-развертываниям на Vercel.

• Ресурсы: библиотека Slack Bolt, и шаблон агента.

Инструмент code_execution от Anthropic интегрируется в AI SDK с типизированным вводом/выводом для bash и редактирования текста.

Новый инструмент Anthropic code_execution_20250825 с выполнением bash-команд и редактированием текста интегрируется в AI SDK, с полностью типизированными входами/выходами для упрощения создания пользовательского интерфейса и более безопасных циклов агентов feature brief. Сопутствующий пример показывает типизированную схему, предназначенную для упрощения фронтендов и ведения журналов typed I/O.

Вывод: создатели агентов могут предоставить Claude более надёжные и поддающиеся аудиту поверхности действий для операций с репозиторием, скриптов и патчей — без специальных адаптеров.

Предпросмотр Codex «Plan Mode» демонстрирует итеративное планирование и переключение модели планировщика

PR режима планирования демонстрирует режим только для чтения, итеративное планирование (Shift+Tab), настраиваемую модель планировщика (/plan-model) и чек-листы обновлений плана — намекает на полноценный этап планирования перед правками в коде детали PR.). Хотя этот PR позже был закрыт без слияния, мейнтейнеры сигнализируют, что План‑режим всё ещё приближается сообщение о статусе PR.). Это разворачивается на фоне того, что команды углубляются в цикл планирования «пперед кодированием», продолжая работу над режимом планирования, внедрением в Cursor, что сокращает ходьбу взад и вперёд и запускает фоновые задачи.

[изображение:https://pbs.twimg.com/media/G3QS36DWoAADcv2.jpg|PR режима планирования]

Ожидания: выделенный планировщик улучшает задачи долгосрочной перспективы (рефакторинг, миграции) и позволяет организациям стандартизировать качество плана независимо от модели кодирования.

Braintrust добавляет удалённые оценки, чтобы можно было проводить бенчмарк локальных агентов без перемещения рабочих нагрузок.

Braintrust показал, как подключать локально запущенных агентов к удалённым оценкам, чтобы команды могли итеративно работать над задачами, наборами данных и оценщиками без повторного развёртывания инфраструктуры how‑to guide. Это полезно, когда вам нужны воспроизводимые оценки (goldens, регрессионные тесты), при этом тяжёлые данные и инструменты остаются на вашем компьютере или в VPC.

Vercel AI SDK добавляет интеграцию инструмента памяти Anthropic для управления состоянием агента

Vercel отметил, что выпускает поддержку инструмента памяти Anthropic в AI SDK, что упрощает сохранение, просмотр и версионирование памяти агентов во внутреннем интерфейсе продукта memory support. Для кодирующих агентов это снижает перегрузку промптов и даёт пользователям точки восстановления, когда длительные сессии сбиваются или прерываются.

🚀 Скорость обслуживания: GB200 токенов в секунду и адаптивная спекуляция

Истории о производительности во время выполнения концентрируются на пропускной способности Blackwell и разборе спецификаций; в основном это системные настройки, а не анонсы кремниевых чипов.

SGLang достигает примерно 26 тыс. входных / 13 тыс. выходных токенов в секунду на каждом GPU GB200 NVL72

LMSYS сообщает, что SGLang устойчиво обрабатывает примерно 26K входных и примерно 13K выходных токенов на GPU в секунду на NVIDIA GB200 NVL72, при этом достигнуты ускорения генерации до 4× по сравнению с Hopper в запусках InferenceMAX, и SGLang установлен по умолчанию как движок DeepSeek на обоих платформах NVIDIA и AMD. Далее по tokens per MW lead, история эффективности GB200 теперь сопровождается конкретными показателями пропускной способности на уровне одного GPU. benchmarks overview LMSYS blog post

Эти результаты отражают совместные системные оптимизации (предзаполнение/распределение декодирования, параллелизм экспертов, внимание FP8, NVFP4 GEMMs) и более пропускные межсоединения Blackwell. Применение в качестве движка по умолчанию в бенчмарке SemiAnalysis InferenceMAX подчеркивает зрелость времени выполнения за пределами одной аппаратной стеки. collaboration note

ATLAS-спекулятор Together AI обеспечивает до 4× быстрее инференс и примерно 500 TPS на DeepSeek‑V3.1.

Together AI представил ATLAS, адаптивную систему спекулятивного декодирования, которая учится на основе реального трафика для ускорения инференса; они демонстрируют пропускную способность до 4× выше базовой и примерно 500 TPS на DeepSeek‑V3.1, почти в 2 раза быстрее их предыдущего Turbo-спекулятора. обзор результатов пост в блоге ATLAS

Поскольку ATLAS адаптируется к коэффициентам принятия нагрузки и профилям задержки во время выполнения, он избегает хрупкости статических спекуляторов и продолжает улучшаться под производственными миксами — это актуально для команд, работающих с длинным контекстом и многоходовыми задачами агентов, где бюджеты токенов доминируют над стоимостью и задержкой.

Разъяснено время выполнения DGX Spark: скорости чтения и генерации, и как оно сравнивается с 5090/M4 Pro

Саймон Виллисон обновил свои заметки DGX Spark, чтобы разделить скорость чтения токенов (prefill) и скорость генерации токенов, выделив ранние узкие места экосистемы на ARM64 CUDA и в контейнерах для рабочих процессов инференса. blog update hands‑on notes

Независимые графики, распространяющиеся сегодня, показывают, что токены в секунду у выхода Spark близки к Mac Mini M4 Pro от Apple и ниже настольных GPU RTX 5090/5080; при цене около $4,000 он нацелен на локальное обслуживание небольших моделей, а не на топовые настольные карты. Такое представление помогает командам выбирать оборудование на основе фактической пропускной способности декодирования, а не смешанных чисел prefill+decode. benchmarks chart

🧱 Настольные компьютеры и стойки: DGX Spark и AMD Helios

Конкретные обновления аппаратного обеспечения охватывают настольные блоки Blackwell и rack-scale-системы MI450; за исключением производительности во время выполнения, которая относится к скорости обслуживания.

DGX Spark выходит на столы: коробка Blackwell на 1‑PFLOP примерно $4k, ранние покупатели отмечают пробелы в ARM64

NVIDIA’s DGX Spark теперь в руках клиентов — Дженсен Хуанг даже лично доставил одну единицу — пользователи отмечают примерно 1 PFLOP в компактном форм-факторе и ожидаемую ценовую рамку около $4,000, продолжая освещение раннее время выполнения, которое сфокусировано на демонстрациях возможностей. Грег Брокман из OpenAI подчеркнул скачок размера к вычислениям, в то время как обзор сообщества детализирует 128 ГБ ОЗУ, ~3,7 ТБ NVMe и стек ARM64, который сегодня работает лучше всего через официальные контейнеры NVIDIA по мере созревания экосистемы CUDA на ARM; hand delivery и blog post. Сравнительная диаграмма размещает Spark ближе к Mac Mini M4 Pro от Apple на меньших моделях, но ниже по классам плат RTX 5090 по чистому запасу мощности, представляя Spark как настольную станцию разработчика, а не обучающую установку comparison chart.

Для инженеров вывод ясен: мощное локальное прототипирование, но планируйте контейнеризованные наборы инструментов и следите за быстрой эволюцией поддержки библиотек ARM64 по мере того, как экосистема догоняет update note.)

Oracle развернет 50 000 GPU AMD MI450 в OCI начиная с третьего квартала 2026 года.

Oracle Cloud Infrastructure запланирует внедрение 50 000 ускорителей AMD Instinct MI450 начиная с Q3’26, с дальнейшим расширением в 2027+, предоставляя предприятиям значительный вариант публичного облака не от NVIDIA для обучения и вывода. Развертывание использует rack‑дизайн AMD Helios — MI450 + следующее поколение EPYC + Pensando сетевые решения — предлагая готовые к подсоединению стойки, нацеленные на масштабирование и обслуживаемость план развертывания.

Для команд по платформе ИИ это укрепляет стратегию с несколькими поставщиками: след OCI MI450 может улучшить диверсификацию поставок и влияние на ценообразование, в то же время проверяя зрелость ROCm‑основанных инструментов на уровне стойки; оценка должна включать память‑ограниченные рабочие нагрузки, которым выгодны емкость и пропускная способность HBM4 MI450.

Стойки AMD Helios: 72 MI450s, примерно 1.4 экзафлопса FP8 и 31 ТБ HBM4 на каждый шкаф

Новая rack‑scale платформа AMD Helios упаковывает 72 GPU Instinct MI450 в обслуживаемый шкаф с быстросъёмным жидкостным охлаждением, что обеспечивает примерно 1.4 exaFLOPS FP8 и около 31 TB HBM4 на шкаф. Каждый MI450 сочетает 432 GB HBM4 с пропускной способностью около 19.6 TB/s, с UALink для масштабирования внутри узла и UEC Ethernet для масштабирования между шкафами; конструкция следует соглашениям Open Rack Wide, чтобы упростить развертывание и сервисное обслуживание на месте platform details.

Для лидеров, оценивающих не-NVIDIA емкость, акцент Helios на объёме памяти на GPU, открытые сети и обслуживание на уровне стойки — заметный подход; он позиционирует стек AMD как достойную альтернативу для крупных тренировочных задач и инференса с высоким контекстом.

🏗️ ИИ-фабрики и математика спроса

Макроинфраструктурные сигналы сегодня связаны с инвестиционной и эксплуатационной экономикой; мало чистых заявок на капитальные вложения (CapEx), но есть значимые обязательства по масштабу и кривые спроса на токены.

Дорожная карта вычислений OpenAI теперь составляет около ~26 ГВт, распределённых между Nvidia, Broadcom и AMD.

Раскрытые OpenAI договоренности оценивают примерно 26 ГВт эквивалентной мощности дата-центров: программа индивидуальных ускорителей Broadcom на 10 ГВт, LOI по системам Nvidia на 10 ГВт (с ожидаемой примерно $100 млрд инвестицией Nvidia по мере развёртывания), и 6 ГВт мощности AMD в сочетании с ваcрантом на покупку до 160 млн акций AMD по цене $0,01, привязанный к развёртываниям compute summary, в продолжение к соглашение на 10 ГВт.

План предусматривает поставку первых стеллажей во второй половине 2026 года и многолетнее наращивание мощностей до 2029 года, что предполагает стратегию полного стека (кремний, иерархия памяти, компилятор/рантайм) для повышения perf/W и снижения стоимости за токен в масштабе.

Скрытые «токены мышления» доводят использование до примерно 1,3 квадриллиона в месяц, даже при снижении цены за единицу.

Использование взрывно растёт, в то время как цена за токен снижается: WSJ подчеркивает, что скрытые цепочки рассуждений моделей («thinking tokens») увеличивают количество токенов на ответ, что ведёт к расходам в условиях более дешёвых ставок WSJ analysis. ecosystem view показывает, что ежемесячное использование поднялось примерно до 1,300T токенов (~1,3 квадриллиона) к октябрю ’25, по сравнению с ~9,7T в мае, как глубокое инференс и самопроверки закрепляются ecosystem map.

Для лидеров в области ИИ экономика расходится на быстрое vs глубокое инференс. Планирование ёмкости теперь зависит от коэффициентов принятия для спекулятивной декодировки, циклов использования инструментов и явных “бюджетов на мысли”, а не только от прайс-листов.

Google собирается построить в Индии AI-центр стоимостью 15 млрд долларов США с дата-центром масштабом в гигаватты и подводной посадочной станцией

Google инвестирует 15 миллиардов долларов с 2026 по 2030 год в создание первого AI‑хаба в Индии (Висакхапатнам), включая центр обработки данных мощностью в гигаватты, построенный вместе с AdaniConneX и Airtel, и новую подводную кабельную посадку, связанную с глобальной сетью Google announcement recap.

Это увеличит мощность многогигаваттного класса в Южной Азии и сократит задержки для быстрорастущих AI‑нагрузок Индии. Пакет (DC, подводный кабель и «полный стек ИИ») сигнализирует о вертикально интегрированном подходе, который может изолировать критически важные AI‑сервисы от региональных перебоев в энергоснабжении и сетях.

Oracle планирует развернуть 50 000 AMD MI450 на OCI начиная с третьего квартала 2026 года, с расширением в 2027 году и далее.

Oracle Cloud Infrastructure добавит 50 000 GPU AMD Instinct MI450 начиная с Q3‑2026 года, с дальнейшим расширением, запланированным на 2027 год и далее deployment note. Этот шаг укрепляет дорожку публичного облака не Nvidia для обучения и инференса в больших масштабах и предоставляет предприятиям диверсификацию поставщиков в условиях дефицита цепочки поставок.

Ожидается, что клиенты будут учитывать зрелость ROCm, кластерные сетевые топологии и портативность моделей наряду с ценой/производительностью при оценке конвейеров с несколькими поставщиками.

AMD представляет стойку Helios: 72 MI450s, 31 ТБ HBM4 и примерно 1,4 экзафлопса FP8 на каждую стойку.

Стенд Helios от AMD нацелен на упрощение обслуживаемости на масштабе AI‑фабрики: 72 GPU MI450 на каждый шкаф, ~31 ТБ HBM4 и ~1,4 экзаFLOPS FP8, с UALink для обмена памятью между GPU внутри узла, UEC Ethernet для масштабирования и быстросъёмное жидкостное охлаждение обзор платформы.)

Дизайн Helios, ориентированный на память, нацелен на пропускную способность в задачах обучения, ограниченных памятью, и на инференс с большим контекстом, при этом он опирается на открытые сетевые технологии, что служит полезным контрбалансом к проприетарным стекам межсоединений.

Brookfield выделит до 5 млрд долларов Bloom Energy на финансирование дата-центров на топливных элементах для искусственного интеллекта.

Инфраструктурный финансист Brookfield Asset Management предоставит до $5 млрд Bloom Energy на финансирование дата‑центров на базе топливных элементов для ИИ, расширяя варианты локального производства энергии помимо сетевых подключений и традиционных соглашений о покупке электроэнергии (PPA) обновление финансирования.

ИИ поднимает ВВП за счёт инвестиций прежде, чем за счёт производительности, сообщает WSJ.

WSJ сообщает, что вклад ИИ проявляется в первую очередь в капитальных расходах, а не в широких улучшениях производительности: примерно две трети роста ВВП США в начале 2025 года пришлись на инвестиции в ПО и вычислительные ресурсы, тогда как зафиксированные эффекты производительности работников остаются смешанными; около 10% компаний сообщают об использовании ИИ WSJ summary.

Для планировщиков в области ИИ это означает, что ближняя перспектива спроса продолжит следовать циклам капитальных вложений (чипы, стойки, энергия, данные), даже если дивиденды от производительности будут приходить медленнее и неравномернее по секторам.

🛡️ Механизмы обеспечения благополучия, возрастные ограничения и сигналы приватности

Действия в области политики и безопасности доминируют в дискурсе: совет по благополучию OpenAI и позиция по контенту для взрослых; однокликовый контроль конфиденциальности в Калифорнии. Исключаются запуски моделей.

OpenAI смягчит ограничения по ответам на вопросы психического здоровья и разрешит эротический контент для проверенных взрослых в декабре.

Сэм Альтман заявил, что консервативная позиция ChatGPT по темам ментального здоровья будет смягчена по мере созревания новых защитных мер, и что эротика будет разрешена для проверенных взрослых с начала декабря по мере широкого внедрения возрастных ограничений Altman thread. Сдвиг подчеркивает выбор пользователей («обращаться с взрослыми пользователями как с взрослыми») и опциональные, более выразительные личности, при этом сохраняются кризисные защиты для пользователей, находящихся в зоне риска.

OpenAI создает Экспертный совет по благополучию и ИИ, чтобы информировать о мерах защиты молодежи и дизайне продуктов.

OpenAI представила восьмичленный Экспертный совет, охватывающий психологию, психиатрию и HCI, чтобы направлять ChatGPT и Sora в здоровых взаимодействиях между различными возрастными группами, на базе ранее выполненной работы, такой как родительский контроль и уведомления подростков о тревоге OpenAI announcement,) и изложив сферу и состав подробно OpenAI blog post.). Совет призван постоянно консультировать по функциям, влияющим на эмоции, мотивацию и психическое здоровье.

Калифорния AB566 требует однократного сигнала браузера «не продавать/не распространять» и системы удаления на уровне штата.

Калифорния одобрила закон AB566, требующий от браузеров встроенного средства управления конфиденциальностью, которое транслирует одноклик‑сигнал «не продавать/не делиться», а также поток запросов на удаление данных брокерами по всему штату law details.)

- Срок сигнала в браузере: обязателен к январю 2027 года; система удаления начнет работу в январе 2026 года с последующими 45‑дневными проверками брокеров law details.)

- Практическое влияние: межсайтовая таргетированная реклама и ленты брокеров будут сталкиваться с более широкими отказами по умолчанию, что сузит данные, доступные для обучения и таргетирования рекламных систем на базе ИИ.

Калифорния подписала первое в США законодательство о чат-ботах, требующее защитных мер; позволяет подавать иски за причинённый вред.

Гавин Ньюсом подписал SB 243, который называют первым в США законом, регулирующим чат-ботов на базе ИИ, обязав защиту пользователей в уязвимых группах и позволяя предъявлять иски в случаях причинения вреда из-за сбоев освещение в СМИ,, продолжая тему SB243, который требовал, чтобы боты раскрывали не человеческий статус и следовали протоколам борьбы с самоповреждением. Подпись переносит мандат из утверждения в исполнимый закон, повышая риски соблюдения требований для ИИ-ассистентов, развёрнутых в масштабе.

🎬 Видео/3D инструменты: Sora 2 против Veo 3.1, устранение мерцания и изображение→3D

Сегодня большой творческий поток обсуждений (перемещения в видеоарене, инструмент устранения мерцания, рабочие процессы ComfyUI, изображение → 3D). Отдельно от функции Qwen VLM.

Sora 2 Pro сравнялся с Veo 3 за первое место на Video Arena; Sora 2 (с аудио) занимает третье место.

Организаторы LMArena добавили Sora 2 и Sora 2 Pro от OpenAI в их рейтинг Text‑to‑Video, отметив, что Sora 2 Pro стал первым, кто сравнял вариации Veo 3 за вершину рейтинга, в то время как Sora 2 занимает 3‑е место и получает похвалу за синхронную генерацию аудио обновление таблицы лидеров.)

Это первый широкий, прямой сигнал того, что аудио+видео конвейер Sora конкурентоспособен с Veo 3 по общей качеству, и поднимает планку для интегрированного звука в T2V‑рабочих процессах (см. приглашение для прямого ввода подсказок и голосования в Discord) приглашение в Discord.)

Gemini UI выводит на поверхность баннеры Veo 3.1 и «быструю» модель, указывая на приближающийся выпуск.

Скриншоты показывают баннеры с надписью «New! Video generation just got better with Veo 3.1» в Gemini с точкой входа Try Now, и карточку Model Finder, в которой перечислены veo‑3.1 и veo‑3.1‑fast preview endpoints; один пользователь отмечает, что доступ, по всей видимости, ограничен сейчас США баннер Gemini, карточка поиска модели, скриншот интерфейса. Это следует за вчерашними заметками о сторонних конечных точках без подтверждения Google Veo 3.1 hint.

Если выпуск пройдет как указано, ожидайте более длинных продолжительностей и лучшей согласованности движения, чтобы сузить разрывы по сравнению с Sora 2 в много‑кадровой связности (и предоставить пользователям Gemini Studio нативный путь для видео+аудио).

Higgsfield запускает Enhancer для устранения мерцания; добавляет Sora 2 MAX/Pro MAX и промо‑режим свободного бега

Хиггсфилд представил Enhancer, универсальный дефликер, который очищает AI‑генерированное и устаревшее видеоматериалы, наряду с Sora 2 MAX (высшая точность) и Sora 2 Pro MAX (мульти‑сцена при максимальном качестве), плюс предпросмотр Upscale 1080p — доступный с «Безлимитным» использованием до конца недели release thread. Затем создатели уже продвигают тизер‑потоки на платформе и подчеркивают безлимитное окно для планов Ultimate/Creator creator promo.

Runway представляет приложения для повседневной видеоработы: удаление, повторная съемка, добавление диалога, увеличение до 4K, переработка стиля

Runway выпустил набор из пяти AI‑видео приложений — Remove from Video, Reshoot Product, Add Dialogue (с тоном), Upscale Video (одним щелчком до 4K), и Change Image Style (включая повторное освещение/перестройку текстуры) — доступно в вебе, с планами добавлять больше еженедельно и открытым призывом к идеям apps overview, feature list. Для производственных команд это объединяет общие задачи по очистке и перепозиционированию прямо в браузере, что может снизить количество возвратов между NLE или специализированными плагинами.

Изображение → 3D за ~2–5 минут: Hitem3D сводит моделирование к примерно $0.30–$1.40 за объект с герметичными мешами.

Hitem3D, построенный на геометрии Sparc3D и скорости ULTRA3D, превращает одну или несколько эталонных фотографий в студийно‑готовые, водонепроницаемые сетки (детализация до 1536³) примерно за 2–3 минуты на просмотр, при этом типичные задачи завершаются в ~2–5 минут и стоят примерно $0.30–$1.40 за модель разбор функций, ArXiv paper. Следующая ветка поясняет путь расширения обзора, выравнивания, триангуляции и текстурирования, и выделяет вариант с лицами/волосами для активов, ориентированных на персонажей how-to thread, official note.

Краткое трёхминутное руководство от ComfyUI по WAN 2.2 Animate и новой схеме замены персонажей

Для создателей, работающих над конвейерами анимации в узлах, ComfyUI опубликовал лаконичное руководство WAN 2.2 Animate, чтобы быстро запустить движение персонажа, а также отдельный обзор по замене персонажа внутри той же графа tutorial, character replacement. Команда запрашивает отзывы по эргономике рабочего процесса, чтобы уточнить значения по умолчанию и примеры feedback request.

📊 Таблицы лидеров и головоломки (не видео)

Короткий апдейт по оценке на сегодня: положение на арене кодирования/атмосферы и дельты NYT Connections. Исключаются элементы лидерборда Qwen (раскрыты в фиче) и видео-арена (в Медиа).

DeepSeek-V3.2-Exp ведет новую Vibe Coding Arena

DeepSeek‑V3.2‑Exp now tops the BigCodeArena “vibe coding” board, отражая исполнение в первую очередь и выбор голосами пользователей; продолжая тему execution evals, которая ввела метод арены run‑and‑judge, сегодняшняя сводка демонстрирует явный порядок расстановки, основанный на реальном использовании. См. предварительный просмотр доски в leaderboard image.

- Top 3 today: DeepSeek‑V3.2‑Exp (≈1107), DeepSeek‑V3.1‑Terminus (≈1080.9), and qwen3‑235b‑a22b‑instruct‑2507 (≈1069.8), все основаны на чистых поединках голосования пользователей и результатах выполнения leaderboard image.

Обновление NYT Connections: GPT‑5 Pro 83.9; DeepSeek V3.2 Exp 59.4

Свежий снимок NYT Connections (последние 100 головоломок) ставит GPT‑5 Pro на 83.9, с DeepSeek V3.2 Exp на 59.4; Claude Sonnet 4.5 Thinking 16K поднимается до 48.2, в то время как его режим без рассуждений достигает 46.1; GLM‑4.6 занимает 24.2. Обновление также отмечает, что GPT‑5 Pro опережает более ранний маркер o3‑pro (87.3) в этом разрезе итоги по баллам,) и подтверждает, что охват относится к наиболее свежим 100 головоломкам заметка метода,), с эталоном и скриптами, доступными в репозитории мэйнтейнера репозиторий GitHub.)

[изображение:https://pbs.twimg.com/media/G3Pi5L8WkAAkktg.jpg|Оценки Connections]

💼 Корпоративные шаги: финансирование, помощники и приложения для электронной коммерции

Известные сигналы GTM охватывают крупный раунд Series B, интеграции Salesforce+OpenAI/Slack, приложение Walmart ChatGPT и комментарии по увольнениям на основе ИИ.

Salesforce интегрирует Agentforce 360 в ChatGPT; заявлены экономии на поддержке в размере 100 млн долларов.

Salesforce расширила своё партнёрство с OpenAI, чтобы приложения Agentforce 360 могли работать внутри ChatGPT, наряду с более глубокими связями с Slack и Codex, представленными на Dreamforce обзор партнерства, графика интеграции, и сообщение Salesforce обновление компании. Внутренне Salesforce заявляет, что агенты поддержки на базе ИИ экономят около 100 млн долларов в год, а Reddit сообщает о 84% более быстрой обработке (46% дефлекции, 8.9→1.4 мин) сводка по экономии. Все детали партнёрства приведены в релизе Salesforce пресс-релиз Salesforce, в продолжение Slack apps, который выпустил ChatGPT для Slack.

[изображение:https://pbs.twimg.com/media/G3Pd5MJWIAAc_Rb.jpg|Слайд Agentforce]

Для предприятий это удлиняет петлю между данными CRM, рабочими процессами Slack и распространением ChatGPT — снижая сопротивление к развертыванию агентских процессов там, где пользователи уже работают.

Goldman Sachs сигнализирует о сокращении рабочих мест по мере ускорения внедрения ИИ в рамках «OneGS 3.0»

Голдман сообщил сотрудникам, что будет сдерживать рост численности персонала и делать ограниченные сокращения в этом году в рамках ускорения эффективности на базе ИИ («OneGS 3.0»), даже несмотря на то, что общая численность персонала останется выше уровней 2024 года ai plan memo, bloomberg snapshot.

Для руководителей по ИИ и HR это наглядный пример операционной переработки крупного банка вокруг автоматизации в найме, соблюдении норм, кредитовании и потоках взаимоотношений с поставщиками — изменение структуры рабочей силы при повышаемой масштабируемости.

Walmart запускает приложение для покупок внутри ChatGPT

Walmart запустила приложение ChatGPT, которое позволяет пользователям просматривать и покупать товары ассортиментов Walmart и Sam’s Club напрямую через ChatGPT, что сигнализирует о переходе мэйнстрим-ритейла к агентной коммерции walmart details, Bloomberg report, deal roundup.

Для лидеров в области торговли это тест конверсии в разговорных каналах и заготовка шаблона для поиска по каталогу, формирования наборов и процессов оформления заказа, встроенных в помощники общего назначения.

Reducto привлекает 75 млн долларов в раунде Series B, обработано более 1 млрд страниц

Документ‑ИИ стартап Reducto закрыл раунд Series B на 75 млн долларов под руководством a16z, доведя общий объём финансирования до 108 млн долларов, и сообщает, что теперь обработал более 1 млрд страниц (~6× с момента Series A) с планами увеличить фокус на исследования модели и инструменты производственного уровня funding note.

Для лидеров в области ИИ это означает нарастающий спрос предприятий на высокоточные конвейеры OCR+VLM в регулируемых рабочих процессах (графики, таблицы, многостраничные документы) и наличия хорошо финансируемого конкурента в стеке автоматизации документов.

Slack превращает Slackbot в полноценного ИИ‑ассистента с приватной обработкой в AWS

Slack тестирует переработанного Slackbot, который планирует встречи, суммирует ветки обсуждений, ищет файлы на естественном языке и координирует календари (Google/Outlook), при этом ИИ работает в частной среде AWS, а более широкий запуск запланирован на конец 2025 года product brief.

Это позиционирует встроенного помощника Slack как корпоративный вариант наряду с ботами сторонних разработчиков — что важно для CIO, оценивающих требования к хранению данных, конфиденциальности и управление изменениями для помощников по работе с знаниями.

Vercel выпускает шаблон Slack Agent и библиотеку Bolt для создания агентов внутри Slack.

Vercel выпустила шаблон Slack Agent Template и библиотеку Bolt для быстрого создания, тестирования и развёртывания Slack‑агентов, дополняя растущую волну агентных корпоративных рабочих процессов, демонстрируемых на Dreamforce template link, slack demo.

Для платформенных команд это снижает затраты на интеграцию при внедрении RAG, одобрений и действий с кодом непосредственно в Slack, с каркасом, удобным для CI/CD.)

🧪 Мышление, обучение с подкреплением и методы с длинной временной перспективой

Интенсивный день исследований: руководство по диффузии, устойчивость цепочек, динамические окна контекста, агенты, управляемые памятью, контроль над излишним размышлением, сжатие KV и экспертная оценка ИИ.

MUSE обучается на рабочем месте, чтобы установить новый TAC SOTA

Цикл, основанный на опыте — планирование, выполнение, рефлексия, сохранение — пишет иерархические воспоминания (стратегические заметки, SOP по подзадачам, подсказки инструментов) и повторно использует их в задачах и моделях, продвигая TAC до 51.78% с Gemini‑2.5 Flash обзор статьи.

- Отдельный агент рефлексии блокирует ложный успех, предлагает повторные попытки и формирует новые SOP; воспоминания на естественном языке передаются другим LLM без повторного обучения обзор статьи.

RL находит те головы, которые имеют значение для рассуждений.

Крошечный порог на каждый head внимания сочетает в себе короткое скользящее окно и полную историю; RL поднимает пороги для голов, которые улучшают корректность. Головки с высоким порогом сохраняют полный KV, в то время как другие подрезаются, сохраняя целостность цепи и экономя ~20–50% KV при точности, близкой к полной потере (или лучше) в задачах по математике/кодированию страница заголовка статьи.

- В сложном наборе по математике сжатая политика даже превосходит базовую полную кэш-линию за счет фокусирования памяти там, где она важнее всего страница заголовка статьи.)

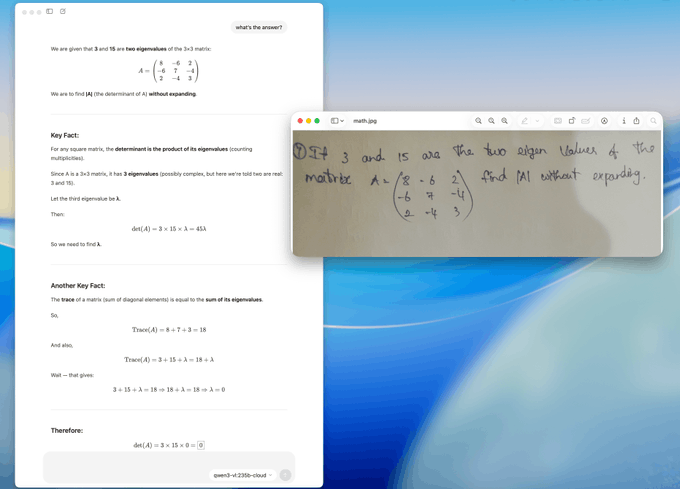

Глубокие поисковые агенты с скользящим контекстом достигают примерно 33,5%.

Скользящее окно, которое сохраняет мысли помощника, опускает устаревшие дампы инструментов и сохраняет последние выводы инструментов, позволяет агентам рассуждать примерно 100 раундов в пределах 32k, достигая примерно 33,5% на более сложном многостраничном бенчмарке — без внешних суммаризаторов paper abstract.

- Обучение повторяет представление во время выполнения (вызовы инструментов заменены заполнителями), за которым следует обучение с подкреплением, которое вознаграждает только правильные окончательные ответы, стабилизируя длительные многошаговые сессии paper abstract.

Руководство по диффузии TAG сокращает количество шагов и вероятность галлюцинаций.

Tangential Amplifying Guidance (TAG) удваивает тангенциальную компоненту каждого обновления диффузии, чтобы удерживать образцы вблизи областей высокой вероятности, уменьшая семантический дрейф; в тестах примерно 30 шагов TAG превосходят 100‑шаговое руководство без классификатора по качеству без дополнительных вызовов модели paper thread.

- Methodologically, TAG keeps the radial (noise) part fixed while modestly boosting the tangential (content) component, improving likelihood and text‑image alignment on standard samplers paper recap.

R‑Horizon: RL улучшает длинную цепочку рассуждений

Новые данные показывают, что обучение с подкреплением на составленных цепях повышает точность цепи и приносит примерно +7.5 на AIME24, решая проблемы раннего останова и форматированных разрывов, которые разрушали длинные последовательности обновление статьи. Это на основе R‑Horizon, который ввел цепную обработку «ширина‑и‑глубина» для стресс‑тестирования долгосрочного рассуждения.

- Анализ пробелов показывает, что реальные баллы цепи ниже ожиданий по независимым испытаниям по мере роста длины цепи; проверяемые вознаграждения и GRPO снижают накопление ошибок краткое содержание статьи.)

Размышления формируют сдерживание излишних размышлений

Group Relative Segment Penalization (GRSP) supervises at the step level: it detects step boundaries (keywords or confidence dips) and penalizes choppy, short segments that correlate with wrong answers, yielding shorter outputs with stable accuracy on math and RL setups paper details.

- Более крупные базы по-прежнему получают пользу, лучше сжимают шаги и стабилизируют обучение по сравнению с наказаниями на уровне токенов paper details.

MPO совместно оптимизирует слова и визуальные элементы для MLLMs

Обработку подсказок как парных текст+сигналов (изображение/видео/молекула) и обновление обоих после однозаметной обратной связи улучшают ответы MLLM, снижая бюджеты на пробы примерно на 70% по сравнению с оптимизаторами, работающими только с текстом; сильные родители запускаются теплее, чтобы эффективно исследовать paper summary.

- Визуальные сигналы создаются, редактируются или смешиваются, чтобы сфокусировать внимание на нужных деталях, с победами в задачах с изображениями, видео и молекулами paper summary.

ИИ‑метаобзор приближается к точности принятия решения человеком об одобрении или отклонении

Ансамбль персонажей рецензентов (эмпирик, теоретик, педагогический) плюс метарецензент достигает примерно 81.8% точности принятия/отклонения на 1 963 подаче, близко к примерно 83.9% человеческому среднему; ИИ отлично справляется с фактологическими/литературными проверками, но отстаёт по новизне/теории paper summary.

- Ответы/возражения могут чрезмерно влиять на агентов, поэтому люди остаются в курсе; ансамбли снижают предвзятость персонажей по сравнению с единичными рецензентами paper summary.