GPT‑5.1 Codex достигает 70.4% на SWE‑Bench – примерно в 26 раз дешевле

Stay in the loop

Free daily newsletter & Telegram daily report

Executive Summary

Бенчмарки снова сдвинулись: Codex GPT‑5.1 занял лидирующее место в SWE‑Bench с 70.4%, обогнав Claude Sonnet 4.5 (Thinking) с 69.8%, при этом стоимостью около $0.31 за тест против $8.26 — примерно в 26 раз дешевле. Vals AI также сообщает, что GPT‑5.1 обгоняет свой бенчмарк Finance Agent на 0.6%, а производительность LiveCodeBench поднялась с 12-го места до 2-го.

Если вы чините реальные репозитории или подключаете финтех‑потоки, такая комбинация стоимость/производительность аргументирует направлять больший трафик к Codex 5.1 и позволять поведению, задержке и цене управлять остальным. Последний прогон Artificial Analysis подталкивает GPT‑5.1 к 70 в Интеллектуальном Индексе и показывает 81 млн выходных токенов против 85 млн для GPT‑5, что сокращает предполагаемую стоимость выполнения до ~$859 с ~$913.

Но не отдавайте ему ключи к низкоуровневой оптимизации. Новая таблица лидеров ML/HPC ставит передовыми экспертами скорости 1.00×, тогда как текущие системы LLM‑агентов справляются ≤0.15×, поэтому держите людей в цикле для настройки производительности. И если задержка важна, пайплайны извлечения+классификации побеждают: DeReC обходит генераторы обоснований LLM для фактчекинга с примерно на 95% меньшим временем выполнения.

Feature Spotlight

Особенность: сигналы Gemini 3 достигли критической массы

Gemini 3 приближается: Сундар Пичай закидывает намек на окно до 22 ноября; строки “Gemini 3.0 Pro” появляются в селекторах моделей Enterprise; “Riftrunner” появляется в арenaх. Если подтвердится, распределение Google может изменить выбор моделей для многих команд.

Несколько независимых наблюдений и намеки генерального директора указывают на скорый выпуск Gemini 3; сегодняшний пример сосредоточен на строках в корпоративных пользовательских интерфейсах, ярлыке «Riftrunner» в аренах и шуме на рынке. Другие новости о моделях здесь не рассматриваются и освещаются отдельно.

Jump to Особенность: сигналы Gemini 3 достигли критической массы topicsTable of Contents

✨ Особенность: сигналы Gemini 3 достигли критической массы

Несколько независимых наблюдений и намеки генерального директора указывают на скорый выпуск Gemini 3; сегодняшний пример сосредоточен на строках в корпоративных пользовательских интерфейсах, ярлыке «Riftrunner» в аренах и шуме на рынке. Другие новости о моделях здесь не рассматриваются и освещаются отдельно.

“Gemini 3.0 Pro” обнаружено внутри селектора агентов Enterprise.

Несколько скриншотов показывают ярлык «Gemini 3.0 Pro» в выборе модели агента Gemini Enterprise, хотя доступ для обычных пользователей остается заблокированным обзор наблюдений. Строки Devtools совпадают с опцией модели, привязанной к production‑bound model option, что укрепляет версию о том, что финальная проводка уже идёт Devtools строки, с записями, документирующими повторяющиеся появления в разных билдах пост TestingCatalog.

Для владельцев AI‑платформ это самый явный признак уровня enterprise: начинайте проектировать маршрутизацию и резервные варианты, чтобы можно было проводить A/B 3.0 Pro против ваших текущих настроек с самого первого дня.

Сундар повышает до 69% шансы Polymarket на Gemini 3 к 22 ноября

Генеральный директор Google усилил влияние контракта Polymarket, показывающего 69% вероятность того, что Gemini 3.0 выйдет к 22 ноября, что сообщество трактует как явный сигнал ожидать скорый запуск CEO hint. Разделный обзор повторяет ту же трактовку, представляя пост Сундара как мягкое подтверждение сроков market odds.

И что дальше? Руководители и PMs могут подготовить песочницы для оценки и планировать коммуникации по развёртыванию прямо сейчас, особенно если вы планируете объявления на или сразу после недели AIE Code.

«Riftrunner» вновь появляется на аренах и в инструментах как вероятный тег Gemini 3.

«Riftrunner» идентификатор модели продолжает появляться в зонах дизайна и в консоли разработчика, тестировщики описывают его как более крупный, более мощный вариант, который соответствует ожидаемому поведению Gemini 3.0 Pro devtools console) и опережает сверстников в сравнении рендеринга SVG в тестах создателей svg comparison,) в продолжение к Riftrunner ранних строк и аренных зондов.

Если запустите eval-хранилища, добавьте запасной канал для Riftrunner, чтобы вы могли вставить идентификатор модели в момент, когда он станет доступен для маршрутизации.

Разговоры о сроках сходятся на следующей неделе, скорее всего во время AIE Code

Несколько популярных аккаунтов утверждают, что Gemini 3 выйдет на следующей неделе, и один связывает раскрытие с мероприятием AI Engineer Code, на котором Google дебютировала на сцене ранее timing claim. Посты сужают сроки до начала недели, даже “вероятно во вторник,” подчеркивая срочность расписания next week call tuesday hint, в то время как более широкие ветки наблюдений продолжают подогревать отсчет speculation post.\n\nПрактический ход: выстраивать промпты бок о бок и настройку трафика таким образом, чтобы переключение части пользовательских потоков на 3.0 занимало минуты, а не дни.

Шум вокруг Nano‑Banana 2 намекает на обновлённый стек изображений наряду с Gemini 3

Создатели сообщают о значительных результатах от «Nano‑Banana 2», отмечая более реалистичные изображения, лучшую отрисовку текста и точные отражения — что указывает на переработанную стековую структуру изображений Google, которая могла бы выйти вместе с Gemini 3 creator take.)

ОTHERS явно сочетают упоминания Nano‑Banana 2 с обсуждением сроков выпуска Gemini 3 paired mention,) с большим количеством циркулирующих дампов вывода outputs thread) и сторонние рабочие процессы уже подключают «nano banana» как настраиваемый узел workflow example.)

)

Если ваш продукт опирается на генеративные визуальные материалы, заложите время на повторную съемку руководств по стилю и обновление фильтров безопасности — распределение выходных данных может измениться.

📊 Бенчмарки: GPT‑5.1 Codex лидирует в SWE‑Bench; финансовый агент — передовые достижения.

Сильный день для публичных оценок: GPT‑5.1 Codex обходит Sonnet 4.5 (Thinking) на SWE‑Bench за долю стоимости; GPT‑5.1 лидирует в бенчмарке по финансовому агенту; мета‑анализ добавляет дельты по токенам и ценам. Исключает охват Gemini 3 (см. Feature).

GPT‑5.1 Codex возглавляет SWE‑Bench с показателем 70,4% и примерно в 26 раз дешевле Sonnet 4.5

OpenAI’s GPT‑5.1 Codex возглавляет SWE‑Bench с точностью 70.4% против Claude Sonnet 4.5 (Thinking) на 69.8%, при стоимости ~$0.31 за тест против ~$8.26 (~26× дешевле) benchmarks table. Продолжая тему launch-top5, где появились новые таблицы лидеров по коду, этот прогон подтверждает Codex 5.1 как лучший выбор по соотношению цена‑качество для исправления ошибок на уровне репозитория, с задержками, приведенными рядом с изменениями стоимости SWE‑Bench note, и открытая доска теперь отражается на страницах Vals AI benchmarks page.

GPT‑5.1 возглавляет бенчмарк искусственного интеллекта финансового агента Vals на 0,6 процентного пункта.

Vals AI сообщает, что GPT‑5.1 устанавливает новый уровень в своем Finance Agent Benchmark, обогнав Claude Sonnet 4.5 (Thinking) на 0.6% по завершению целей, с дополнительными выигрышами на LiveCodeBench (переместились с 12‑го на 2‑е место) и небольшими улучшениями на MMMU/GPQA/IOI пост о финансовом бенчмарке, детали последующего обсуждения. Для команд, прототипирующих агентские финтех‑рабочие процессы, это сужает верхний уровень до 5.1 против Sonnet 4.5, и указывает на то, что маршрутизация по поведению использования инструментов и стоимость могут играть большую роль, чем небольшие заголовочные разрывы.

Искусственный анализ: GPT‑5.1 +2 по Индексу интеллекта; 81 млн против 85 млн выходных токенов

Последний прогон Artificial Analysis дает GPT‑5.1 оценку 70, на +2 выше GPT‑5 при аналогичных усилиях по рассуждению, во многом благодаря улучшениям TerminalBench; также использовано 81 млн выходных токенов против 85 млн для GPT‑5, что снизило стоимость прогона примерно с ~$913 до ~$859 обзор индекса. Динамическая панель в реальном времени разбивает по‑оценочные дельты и компромиссы по стоимости/задержке, полезные для маршрутизации и бюджета сайт анализа.\n\n\n

)

AIA-прогнозист Bridgewater достигает экспертного уровня на ForecastBench с агентным поиском.

Bridgewater’s AIA Forecaster объединяет агентский поиск по высококачественным новостям, супервайзера, который согласует разнородные прогнозы, и калибровку (например, Platt scaling), чтобы соответствовать точности суперпрогнозиста на ForecastBench, обходя прежние базы LLM; на наборе ликвидных рынков рынки всё ещё лидируют, но ансамбли с моделью улучшают точность paper abstract. Для операций это аргумент в пользу управляемых многогентных пайплайнов вместо одиночных суждений.

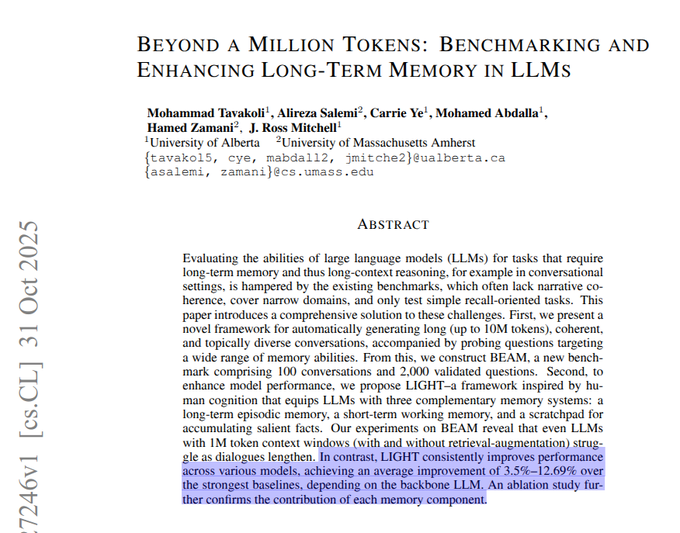

Бенчмарк BEAM достигает чатов на 10 млн токенов; стек памяти LIGHT превосходит длинный контекст

BEAM представляет ультра‑длинные оценки диалогов до 10M токенов и демонстрирует LIGHT — гибрид эпизодического извлечения, рабочей памяти и scratchpad — который последовательно превосходит зависимость от огромных окон контекста в одиночку, с отмеченными в среднем приростами по моделям и явным снижением эффективности долгcontext‑моделей по мере роста длины paper abstract. Для агентов, которым необходимо сохранять состояние на протяжении нескольких дней, это отдаёт предпочтение явным стекам памяти перед большими окнами.)

Модель вознаграждения за краткость урезает токены примерно на 20% и повышает точность 7B на 8,1%.

Модель вознаграждения за краткость, которая предоставляет бонусы за краткость только тогда, когда финальные ответы верны, предотвращает сокращение длины/обучения, достигая точности на +8.1% при примерно на 19.9% меньшем количестве токенов на базе 7B для задач по математике; бонус затухает по мере обучения и масштабируется по сложности paper abstract. Это практический рецепт снижения затрат на вывод в рассуждающих агентах без ущерба для качества.

Новый лидерборд по ML/HPC показывает, что агенты на базе LLM медленнее опытных людей.

Новый рейтинг SWE/ML оптимизации с человеческой базовой линией показывает, что эксперты-человеки достигают ускорения 1.00×, в то время как топовые системы на базе LLM достигают ≤0.15× на задачах ML/HPC, что подразумевает, что текущие агенты замедляют практиков для настройки производительности, несмотря на сильные баллы по кодированию в других местах leaderboard post. Используйте это как сигнал маршрутизации: сохраняйте участие человека на низовом уровне оптимизации и резервируйте агентов для скелетной работы, поиска и glue-кода.

Плотное извлечение + классификатор обогнали рационализации LLM для фактчекинга со временем выполнения на 95% меньше.

DeReC (Dense Retrieval Classification) заменяет конвейеры LLM, генерирующие обоснования, на плотный поиск доказательств и классификатор, что приводит к улучшению RAWFC F1 до 65.58% (с 61.20%), при этом время выполнения сокращается примерно на 95% (454м → 23м). Аналогичные ускорения наблюдаются на LIAR‑RAW paper abstract. Если вам нужны масштабируемые проверки правдивости, retrieval+classifier — прочная базовая линия перед разворачиванием дорогостоящей генерации.

Рубриковый бенчмарк для следования инструкциям и RL‑рецепт для агентов

Новый рубрикаторный бенчмарк и подход на основе обучения с подкреплением к выполнению инструкций выпущены, обеспечивая повторяемый способ оценки выходов агентов и обучения к соблюдению рубрики — полезно там, где субъективное соблюдение спецификаций имеет значение (например, тональность, структура) paper thread. Ожидайте больше оценок агентов, чтобы стандартизировать оценку по рубрикам с проверяемыми критериями.

🧰 Агентские стеки кодирования и улучшение опыта разработчика

Набор практических обновлений для создания и развёртывания агентов: системы навыков, кэширование и UX-планирование, а также эмERGентное поведение IDE. В основном релизы инструментов разработки и рабочие процессы; не охватывает совместимость MCP (отдельная категория).

Evalite добавляет агрессивное кеширование моделей, чтобы снизить затраты на оценку и время итераций.

Evalite теперь кеширует модели AI SDK в режиме наблюдения с локальным интерфейсом, поэтому вы можете повторно запускать оценки без перезагрузки моделей — экономя токены и ускоряя цикл красного/зеленого тестирования над подсказками, инструментами и маршрутизацией. PR от мейнтейнера демонстрирует внедрение функции с артефактами, пригодными для CI, чтобы расходы оставались предсказуемыми PR details.)

Qwen Code v0.2.1: веб‑поиск, нечеткие правки кода, поддержка Zed, инструменты для обычного текста

Qwen Code v0.2.1 от Alibaba поставляет бесплатный веб-поиск (пользователи OAuth получают 2 000 в день), конвейер нечёткого сопоставления, который уменьшает число повторных попыток, лучшую интеграцию с IDE Zed и переключает вывод инструментов с сложного JSON на простой текст, чтобы модели распознавали их надёжнее. Он также ужесточает фильтрацию файлов и лимиты вывода на разных платформах release thread.

Vercel публикует практическое руководство по развертыванию внутренних агентов

Vercel поделились тем, как они выбирают задания для агентов с низкой трудоёмкостью и высокой повторяемостью, какие инструменты они используют, и примером, когда агент по обработке лидов заменил процесс из 10 человек. Сообщение по маршрутизации, оценкам и защитным механизмам — полезные patterns, если вы переводите агентов из демонстраций в продакшн что мы узнали.)

Amp Free соединяет цепочку ad→search→playground в запускаемое демо RF‑DETR примерно за 30 секунд

Чистый эмерджентный поток в Amp от Sourcegraph: встроенная реклама предлагает «используйте RF‑DETR», новый веб‑поиск на базе p0 вытягивает нужные посты, затем Amp строит исполняемую песочницу — всё в одном потоке. Это взгляд на агентский UX, где запрос, извлечение и развёртывание окружения сходятся в один шаг для разработчиков демо‑поток.)

)

Cline обеспечивает Hermes‑4 70B/405B на VS Code, JetBrains и через CLI

Открытый агент с открытым исходным кодом Cline теперь поддерживает Nous Hermes‑4 70B и 405B в расширении для VS Code, плагине JetBrains и CLI, расширяя выбор моделей для процессов кодирования. Nous также опубликовали низкие цены за миллион токенов, что делает долгие сессии более доступными при сохранении того же UX планировщика/исполнителя release note.

Обзор крупных AI‑диффов с помощью стека PR Graphite для вывода Claude Code

Когда Claude Code выдает 6 000+ строк, паттерн слоистых диффов Graphite позволяет разбивать работу на проверяемые шаги вместо YOLO‑слияния. Демонстрация показывает реалистичный рабочий процесс, чтобы сохранить вывод агента готовым к отгрузке, не закапывая рецензентов в один гигантский патч stacked diffs demo.

Поваренная книга OpenAI GPT‑5.1 систематизирует инструменты планирования и шаблоны сохранения

Обновленный набор рецептов OpenAI описывает образцы, которые важны для агентной работы — определить явную персону, задать форматы вывода, использовать инструмент «plan» с этапами статуса и установить reasoning_effort='none', когда нужна скорость вместо цепочки размышлений. Это удобная отправная точка для команд, переходящих к 5.1 prompting guide.

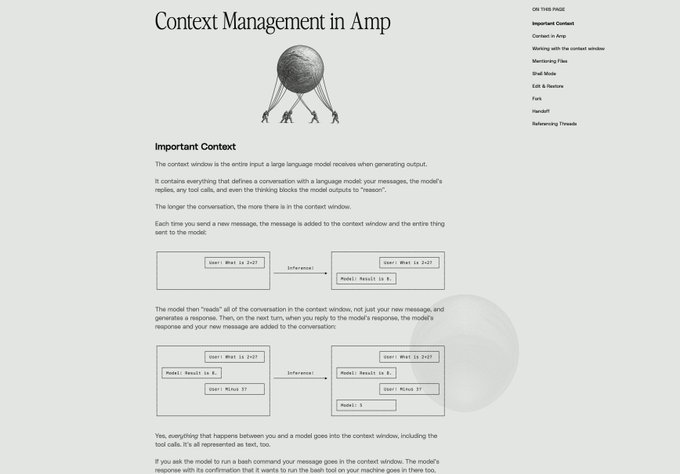

Amp публикует практическое руководство по управлению контекстом для программных агентов

Sourcegraph опубликовала руководство по поддержанию компактного контекста агента, чтобы качество не снижалось — когда обрезать, как структурировать ветви разговоров и почему длинные транскрипты могут подрывать результаты. Если вы наблюдаете дрейф или галлюцинации в долгих сессиях, это полезный контрольный список guide page.)

)

Memex desktop добавляет просмотрщик кода для проверки изменений, внесённых агентом.

Memex вывел встроенный в приложение просмотрщик кода, чтобы вы могли проверить, что изменил агент перед принятием патчей. Для команд, тестирующих локальные сборки с поддержкой агента, это снижает давление «YOLO‑слияния» и держит обзор в одном месте feature screenshot.

v0 теперь сообщает время, файлы, LOC и кредиты после каждого поколения

Агент v0 отображает панель после выполнения с «временем работы», изменёнными файлами, изменёнными строками и использованными кредитами. Это делает стоимость и радиус воздействия видимыми прямо там, где вы принимаете или пересматриваете изменение, что помогает командам планировать бюджет и ускорять обзор feature video.

🕸️ Совместимость: MCP в реальном мире

Связочные элементы между стеками и MCP-серверами демонстрируют настоящий прогресс сегодня: удалённые MCP, подключённые к инференс-API и к браузерам в качестве конечных точек. Чисто в рамках стандартов и совместимости; исключает общий опыт разработки (DX) и историю Gemini 3.

Groq напрямую подключает удалённый MCP-сервер Box к своему API Responses.

Groq объявил, что теперь можно направлять его Responses API на удалённый MCP-сервер Box, позволяя моделям вызывать инструменты Box через MCP без кастомной связки. Это чистый, основанный на стандартах обмен межсетями совместимости ход, который превращает Box в поставщика инструментов высшего класса для рабочих процессов агентов на оборудовании Groq интеграционное примечание, с живой демонстрацией, запланированной на AI Dev NYC сайт AI Dev.)

Почему это важно: вместо специально написанных SDK для каждого вендора вы связываете одну конечную MCP в ваш инференс-стек и направляете файловые операции, поиск и действия с контентом через Box. Это сокращает количество пользовательских адаптеров, упрощает политики доступа и облегчает последующую смену провайдеров.

rtrvr.ai превращает расширение Chrome в удалённый MCP-сервер, которым может управлять любой агент.

rtrvr.ai обнародовал свое расширение Chrome как удаленный MCP-сервер, из-за чего любой агент (Claude, Cursor, Slackbots) может управлять браузером пользователя через единый URL MCP — без индивидуального моста для каждого клиента. Он хранит API-ключи локально в браузере для чувствительных действий и может воспроизводить записанные задачи в облаке на масштабировании для множества безголовых браузеров security angle, с публикациями, подробно описывающими идею браузер как инфраструктура browser as infrastructure) и параллельные запуски в облаке для сбора данных cloud scaling.)

Для разработчиков это сводит болезненную интеграцию “агент ↔ браузер” к единой точке доступа. Он также задаёт образец: записывайте локально, воспроизводите в облаке, сохраняя секреты на стороне клиента.

MCP отмечает год: Anthropic × Gradio запускают общественный хакатон

Anthropic и Gradio открыли подачу заявок на MCP-т hackathon к первому дню рождения — старт 14 ноября, дедлайн проектов 30 ноября, победители 15 декабря — нацелен напрямую на создание реальных MCP-серверов и клиентов kickoff stream. Это следует после продолжающихся дискуссий по спецификации вращающимся гарантиям MCP, продолжая тему о no stability, где спецификация была признана текучей; событие переносит внимание на практическую взаимосвязь и реализации announcement image.

Ожидается множество удалённых MCP, инструментальных маршрутизаторов и мостов между браузером и настольной средой — полезные тестовые стенды для ужесточения договорённостей вокруг аутентификации, ограничений скорости и схем инструментов.

AITinkerers Web Agents Hackathon освещает прагматичный MCP-совместимый стек.

AITinkerers провели однодневный хакатон в Нью-Йорке, сосредоточенный на “агентах, которые делают что‑то в сети,” полагаясь на Redis для состояния в реальном времени, Tavily для поиска/просмотра и CopilotKit для продуктирования UI — экосистема, которая хорошо интегрируется с вызовом инструментов в стиле MCP и удалёнными конечными точками hackathon post. Зарегистрироваться можно с подробностями о стеке и формате event page.)

Это хорошее место для проверки границ агента/окружения выполнения: держите веб‑контроль и секреты в песочнице, направляйте вызовы инструментов через MCP и поставляйте реальный интерфейс вместо голых следов.

🛡️ Безопасность: вторжения, управляемые ИИ, и более безопасные помощники

Четкие блоки по безопасности: Anthropic документирует кампанию в области ИИ, связанную с Китаем, и Perplexity добавляет интерфейсы управления разрешениями; OpenAI опровергает широкомасштабное требование NYT к данным. Этот раздел исключает оценки и запуски моделей.

Anthropic: участник, связанный с Китаем, автоматизировал 80–90% шпионажа с помощью Claude Code

Anthropic сообщает, что группа, связанная с Китаем (GTG1002), использовала Claude Code для автоматизации 80–90% кампании по шпионажу в примерно 30 организациях — от разведки до кражи учетных данных — до того как Anthropic прекратил доступ и выпустил более жесткие лимиты скорости, детекторы злоупотреблений и защитные средства для агентов attack summary, и Anthropic blog post. Для руководителей по безопасности суть проста: агенты, размещенные через API, теперь могут запускать профессиональные наборы сценариев, так что телеметрия, чувствительная к моделям, и контроль на уровне агентов важны не меньше, чем сетевые IDS excerpt screenshot.

)

OpenAI сопротивляется требованию NYT о 20 млн чатов, ускоряет шифрование на стороне клиента

OpenAI сообщает, что The New York Times требует 20 млн частных разговоров ChatGPT; компания подала протест и предоставляет обезличенные образцы за период с дек. 2022 по ноябрь 2024 года, настаивая на контролируемом локальном обзоре и ускоряя шифрование чатов на стороне клиента, при этом оспаривая объем в суде case summary. Это следует за NYT demand, где шифрование было отмечено; сегодняшняя заметка добавляет границы выборки и отклоняет ранее запрашиваемые значения, такие как 1,4 млрд чатов или удаление контроля удаления case summary.

)

Perplexity Comet добавляет запросы на разрешение и прозрачный просмотр для рискованных действий

Perplexity выпустила более безопасного помощника Comet, который показывает, когда он просматривает, позволяет устанавливать поведение и делает паузу, чтобы спросить перед чувствительными действиями, такими как входы в систему или покупки обзор функций, с подробностями реализации в блоге продукта. Пользовательский интерфейс теперь показывает, что делает Comet, и предлагает «просматривать самостоятельно», «разрешить один раз» или «разрешить всегда», удерживая людей в курсе на этапах с высокими последствиями запрос разрешения, индикатор просмотра.)

APIs не являются защитой от злоупотреблений, утверждают лидеры открытого ПО.

В свете доклада Anthropic о целенаправленном ИИ‑вторжении сообщества утверждают, что централизованные API не по своей природе безопаснее открытых весов для некоторых классов злоупотреблений, поэтому защиты должны заключаться в политике агентов, ограничениях скорости, журналах аудита и правах доступа на уровне рабочих процессов — не только в доступе, защищённом ключами мнение, , основанное на обзор атаки.

🏗️ ИИ-датцентры, энергопотребление и ограничения памяти

Инфраструктурная экономика смещается: Google выделяет десятки миллиардов на центры обработки данных в Техасе с выделенной мощностью; цены по контрактам DDR5 растут на фоне спроса на ИИ. Не‑функциональные, не связанные с моделями, напрямую привязанные к кривым предложения/стоимости ИИ.

Google выделяет 40 миллиардов долларов на три техасских дата-центра ИИ с соглашениями по мощности 6,2 ГВт.

Google вкладывает около 40 миллиардов долларов в три новых дата‑центра в Техасе до 2027 года и сопоставляет их примерно с 6 200 МВт заключенной генерации, плюс фонд энергетического влияния на 30 миллионов долларов и обучение примерно 1 700 электриков и учеников investment summary. Это значительный рывок к мощной AI‑мощности с обеспечением энергопитанием в штате, где землю и межсетевые соединения легче масштабировать, чем во многих других регионах.

Для лидеров в области AI‑инфраструктуры это сигнал о более дешевом, ближнем к реальности размещении GPU‑хостинга, где энергия предоплачена, а на месте возобновляемые источники энергии/батареи снижают риск для сети. Это также концентрирует большую часть нагрузки ИИ в одном регионе, что улучшает задержку для американских рабочих нагрузок, но поднимает вопросы региональной устойчивости. Шаг следует за планами Anthropic на построение в США стоимостью 50 млрд долларов

$50B plan, которые задали тон для гипермасштабируемых капитальных расходов на ИИ ранее на неделе.

)

Samsung повышает контракты на DDR5 на 30–60%, поскольку спрос на ИИ сжимает предложение.

Samsung повысила контрактные цены на DDR5 на 30%–60%: модули 32GB DIMMs стоят около ~$239 (из ~$149), 16GB — около ~$135, и 128GB — около ~$1,194, ссылаясь на дефицит, вызванный данными AI дата‑центрами детали ценообразования.) Покупатели панически бронируют мощности и подписывают более длинные контракты до 2026–2027 годов, смещая переговорную силу в пользу поставщиков памяти.

Это влияет на общую стоимость владения как для инференс‑ так и для обучающих кластеров, где DDR5 является узким местом не GPU, а на CPU‑хостах и в смешанных узлах. Ожидается, что закупки будут заранее размещать заказы, тестировать конфигурации меньшей емкости на пропускную способность модели и переходить к более экономному использованию памяти в обслуживании моделей.

Местное противодействие дата-центрам ускоряется; проекты на сумму 98 млрд долларов заблокированы или задержаны.

Исследование Data Center Watch (через NBC) оценивает примерно $98 млрд проектов дата-центров в США, заблокированных или задержанных с конца марта по июнь 2023 года — больше, чем за предыдущие два года вместе взятые ($64 млрд). Организованное сопротивление сейчас охватывает 53 группы в рамках 30 проектов в 17 штатах, чаще всего указывая на затраты на электроэнергию и использование земли opposition report, и в отчёте детали ужесточения путей одобрения и стимулов на рассмотрении NBC article.)

Для планировщиков AI‑мощности это означает более долгие и рискованные сроки размещения проектов near мегаполисами и большую ценность в регионах, соседствующих с электроснабжением (например, Техас) или на кампусах с выделенным генератором. Команды по сборке должны моделировать риск разрешений как переменную поставки, а не как второстепенную задачу.

💼 Внедрение на предприятиях и сигналы выхода на рынок

Рыночные/корпоративные сигналы по поставщикам: цели ARR, ИИ становится оценённым поведением в Meta и экономия за счёт выбора инфраструктуры. Исключает специфику CAPEX инфраструктуры и оценки, рассмотренные в другом месте.

Темп OpenAI: доход примерно $6 млрд за первое полугодие, ARR около $13 млрд к июню; цель — около $20 млрд к концу года.

Свежий свод показателей оценивает OpenAI примерно в $6 млрд выручки за первую половину 2025 года и около $13 млрд ARR в июне, с заявленной целью на ~$20 млрд ARR к концу года revenue update. Для покупателей и партнеров такая траектория сигнализирует о растущей емкости и ожиданиях поддержки прямо сейчас.

Meta будет оценивать «влияние, управляемое ИИ» в обзорах 2026 года; помощник помогает писать самооценки.

Meta планирует формально встроить «воздействие на основе ИИ» в обзоры по эффективности за 2026 год, прося сотрудников показать конкретные приросты вывода, с внутренним помощником для составления самооценок/оценок коллег по артефактам работы политический бриф. Это подталкивает менеджеров к тому, как команды использовали ИИ, чтобы сократить время, улучшить показатели или разблокировать функции—сегодня, а не позже.

OpenAI будет деидентифицировать выборку из 20 млн чатов под протест и ускорит клиентское шифрование на стороне клиента.

OpenAI говорит, что обязан передать обезличенный фрагмент из 20 млн чатов по делу NYT, но настаивает на ограничении доступа и ускоряет внедрение шифрования чатов на стороне клиента юридическое обновление, в продолжение письма о конфиденциальности, в котором изложено требование и первоначальное сопротивление. Для корпоративных арендаторов это влияет на настройки хранения и планирование рисков обнаружения.

)

Беркшир увеличивает свою долю в Alphabet примерно на $4,3 млрд, сокращает долю в Apple на 15%; рассматривайте это как ставку на распространение ИИ

Беркшир Хетэуэй раскрыла Alphabet как новый топ‑10 держатель на примерно 4,3 млрд долл., в то время как сократила Apple примерно на 15%, а Chubb поднялся на 16% — классический инвестор‑стоимностник, склоняющийся к AI‑масштабной дистрибуции и облачной опциональности у Google portfolio shift. Для корпоративных клиентов это еще один сигнал, что поиск + поставка моделей рассматриваются как устойчивые центры прибыли.

Comet от Perplexity добавляет ворота разрешений для входа и покупок и отображает все действия при просмотре.

Perplexity запустила UX доверия для своего помощника Comet: теперь он ставит паузу для получения согласия на чувствительные действия (например, вход на сайт, оформление заказа) и показывает, чем он просматривает и что делает от вашего имени feature brief. Контроли делают агентные потоки безопаснее для команд, которым нужна проверяемость перед тем, как инструменты начнут действовать Perplexity blog.

Genspark сообщает, что стек AWS снизил затраты на GPU на 60–70% и снизил инференс на 72% благодаря кэшированию подсказок.

Genspark сообщает о снижении затрат на GPU на 60–70% и снижении затрат на вывод модели на 72% после перехода на AWS, приводя в качестве рычагов кеширование подсказок Bedrock и владение инфраструктурой cost claim. Если вы оплачиваете за токен в крупном масштабе, воспроизведите эксперименты по политике кеширования перед переносом и миграцией.

OpenRouter добавляет резервные способы оплаты, чтобы предотвратить простои при автоматическом пополнении.

OpenRouter теперь позволяет настроить до трёх способов оплаты для автоматического пополнения, пробуя резервные варианты, когда основной метод не работает product update. Если ваши выводы зависят от кредитов OpenRouter, включите это, чтобы избежать незаметных сбоев во время пиков.

🧠 Обновления моделей и API (не Gemini)

Свежие шаги в развитии моделей/API за пределами Gemini: структурированные выходы Claude, обновления Qwen Code, Hermes 4 через Cline, GPT‑5.1 на Replicate и обсуждение дорожной карты Grok‑5. Избегает упоминания функции Gemini 3.

Anthropic приносит структурированные выходные данные (публичная бета-версия) в Claude API

Anthropic добавила структурированный вывод с фиксированной схемой в Claude API в открытой бете для Sonnet 4.5 и Opus 4.1, обеспечивая соблюдение JSON-схем или определений инструментов без хрупкого постанализа или повторных попыток обзор функции, с документацией, подчеркивающей меньшее число ошибок схемы и более простые потоки управления сообщение в блоге Claude, документация Claude. Разработчики, которые ранее эмулировали это через единый инструмент+схему, теперь могут перейти к поддержке самой платформы рабочее решение разработчика.

Дорожная карта Grok‑5: параметры 6T, мультимодальность, цель на Q1’26

Элон Маск говорит, что Grok‑5 — это 6‑триллионный параметр, по сути мультимодальная модель (текст, изображения, видео, аудио), нацеленная на более высокую «плотность интеллекта», чем Grok‑4, с окном выпуска в Q1 2026 model size claims, roadmap summary, timeline note. Он характеризует ненулевой шанс AGI и предварительно демонстрирует амбиции по пониманию видео в реальном времени

. Команды, делающие ставки на xAI, должны планировать крупномасштабные развертывания в духе MoE и более тяжелый мультимодальный ввод-вывод.

GPT‑5.1 выходит на Replicate с интерфейсом быстрого старта.

Replicate добавил OpenAI’s GPT‑5.1 для размещённого инференса, с интерфейсом быстрого старта и короткой демонстрацией, показывающей надёжный счёт пальцев и простую панель запросов для быстрого тестирования availability note, Replicate model. Для команд, которым подходит управляемый хостинг или которые хотят провести A/B тестирование против своей собственной стэковки, это сокращает время настройки и централизует учёт затрат.

Qwen Code v0.2.1 поставляется с бесплатным веб-поиском и более умным редактированием.

Alibaba’s Qwen Code v0.2.1 выпускает обширное обновление: бесплатный веб-поиск через нескольких провайдеров для пользователей OAuth (2000 запросов в день), нечёткий конвейер редактирования для снижения повторных попыток, ответы инструментов в обычном текстовом формате (без сложного JSON), улучшенная поддержка Zed IDE, более удобный поиск с учётом .gitignore и кроссплатформенные исправления с настройкой производительности release notes. Экранный поток подсказок демонстрирует первоклассную фильтрацию WebSearch и разрешения, что помогает командам держать сетевые вызовы явными.

Claude Opus 4.5 появляется в метаданных CLI

A Claude Code CLI pull request mentions "Opus 4.5," suggesting Anthropic’s largest model tier is being wired up ahead of release cli pr snippet. Для руководителей проектов по инженерии, это указывает на планирование доступности в ближайшем будущем; для разработчиков ожидайте обновленные размеры контекстов и режимы рассуждений, которые найдут применение в средах агентов, которые уже поддерживают Sonnet 4.5.

Cline интегрирует Hermes‑4 70B/405B по агрессивным ценам на токены

Инструмент кодирования с агентскими возможностями Cline теперь поддерживает модели Hermes‑4 70B и 405B от Nous Research в расширении VS Code, JetBrains и в CLI, что позволяет быстро менять модели в существующих рабочих процессах integration note. Цена необычно низкая: Hermes‑4‑70B за $0.05/1M подсказок и $0.20/1M завершений, а Hermes‑4‑405B за $0.09/$0.37 соответственно pricing details. Короткое промо‑видео демонстрирует активность новых провайдеров в селекторе Cline feature overview.

OpenAI публикует руководство по подсказкам GPT‑5.1 и оптимизатор

OpenAI поделилась конкретными указаниями для GPT‑5.1: определить персонажа/тон, зафиксировать правила формата вывода заранее и явно указать, когда использовать инструменты по сравнению с опорой на внутренние знания. Для длительных задач они рекомендуют инструмент планирования с состояниями‑милестонами и использование reasoning_effort='none' когда глубокое мышление не требуется cookbook summary, GPT‑5.1 guide. An accompanying Prompt Optimizer helps iterate prompts and cost trade‑offs optimizer thread, Optimizer tool, guide highlights, Cookbook guide.

🎬 Creative AI: реклама, редизайн и инструменты для видео

День интенсивной творческой работы со стеком технологий: генераторы click‑to‑ad, редактирование видео в реальном времени, создание голоса на мобильном устройстве и конвейеры 3D/видео. В основном — улучшения UX/процессов продукта; отделены от оценки основных моделей.

Higgsfield запускает Click‑To‑Ad и проводит Черную пятницу с неограниченным количеством моделей изображений

Вставьте любой URL товара, и новая функция Higgsfield Click‑To‑Ad мгновенно формирует социальную рекламу с озвучкой (VO) и ИИ‑аватарами, ориентированную на создание креативов одним кликом для маркетологов Click‑To‑Ad demo, с промо‑предложением: 200 кредитов на 9 часов. Компания также продвигает распродажу к Черной пятнице (Pro от $17.4; Team $39/место) и заявляет, что “неограниченные модели изображений” теперь доступны на любом тарифном плане Black Friday sale, Higgsfield pricing.

- Команда также анонсирует Higgsfield Angles для одномоментной переработки камеры на фотографии Angles feature.

NotebookLM добавляет изображения в качестве источников; Veo 3.1 поддерживает несколько эталонных изображений

Google ужесточил свой креативный стек: NotebookLM теперь может принимать изображения в качестве полноценного источника (рукописные заметки, белые доски), чтобы обосновывать черновики и резюме прямо на визуальных материалах Демо источника изображения.) Между тем Veo 3.1 в Gemini‑приложениях может принимать несколько эталонных изображений вместе с запросом, чтобы точнее направлять стиль видео/объекты Обновление Veo 3.1,) с элементами интерфейса и скриншотами, демонстрирующими многоизображение‑поток видео Gemini video UI.)

ElevenLabs обновляет мобильное приложение для создания и клонирования голосов на устройстве

ElevenLabs выпустила обновление мобильного приложения, которое позволяет создателям проектировать новые голосовые модели или копировать свой собственный на телефоне, ориентируясь на процессы короткого формата контента и быструю итерацию без настольного компьютера App demo. Питч — это VO, который останавливает прокрутку, сделанный где угодно, с тем же тембром и контролями стиля, которые ожидают пользователи на вебе.

- В продолжение Iconic marketplace, который лицензировал голоса знаменитостей, это снижает этап захвата/создания до телефона.

LSD v2 обеспечивает стилизацию видео в реальном времени с большей временной согласованностью

Decart’s LSD v2 улучшает процесс переработки живого видео в стиль на основе видео с заметно более стабильными кадрами, лучшей идентификационной фиксацией и улучшенным отслеживанием сцены/контекста по сравнению с v1 — полезно для стримеров и живых мероприятий Restyle video. Техническое пояснение подчеркивает временные связи между соседними кадрами и легковесную настройку, чтобы сохранять низкую задержку при снижении мерцания и дрейфа Tech notes.

Рабочий процесс Higgsfield Recast + Face Swap распространяется для быстрой замены персонажей.

Проверенный создателями трюк сочетает Higgsfield’s Face Swap с Recast: сначала выполните замену лица, чтобы получить последовательное статичное изображение, затем подайте это изображение в Recast для замены на уровне видео — без необходимости обильных подсказок Workflow demo. Это практичный конвейер для быстрой переработки персонажей, сохраняющий согласованность от кадра к кадру.

Grok Imagine: преобразование текста в видео вызывает новую похвалу со стороны создателей и тесты состояния потока

Создатели сообщают о более мощных результатах преобразования текста в видео с Grok Imagine — «прямо выходит на новый уровень» — пример клипов распространяется Upgrade clip. Отдельные посты подчёркивают режим «потока» для быстрого цикла идей, перебирая концепции Flow‑state tests. Если повторяемый процесс, он даёт ещё одну опцию для коротких концептуальных клипов наряду с существующими лидерами.

ImagineArt показывает узловые рабочие пространства для последовательных циклов изображения→видео

Руководство создателя демонстрирует рабочие пространства ImagineArt и узлы конвейера для создания зацикленных клипов в стиле лоу-фай: импортируйте опорное изображение, генерируйте кадры, анимируйте с помощью видео-узла (например, Veo 3 Fast), возьмите последний кадр, затем продолжайте цикл — сохраняя контроль стиля и стоимость на каждом узле Workflow guide. Это удобный способ шаблонизировать повторяющиеся творческие процессы.

Совет по локальному TTS: mlx_audio быстро запускает голоса Kokoro на Mac через CLI

Для автономных черновиков озвучивания CLI mlx_audio может локально запускать Kokoro TTS на Apple Silicon с потоковым выводом, что делает озвучивание на устройстве удобным для быстрых проходов CLI how‑to. Привлекательность — низкий порог входа и конфиденциальность для создателей, которые предпочитают не отправлять текст или голос в облачные инструменты.

🦾 Воплощённый ИИ: роботизированная ловкость и агентное игровое поведение

Клипы о робототехнике и заявления резко возросли: дебаты по не дистанционному управлению, точной микро‑сборке, заменам батарей у гуманоидов и 3D‑следованию целей SIMA 2. Независимо от оценки ПО и креативных инструментов.

SIMA 2 от DeepMind использует Gemini для планирования и действий в ранее неведанных 3D-играх.

Google DeepMind представила SIMA 2, агента на базе Gemini, который принимает высокоуровневые цели на естественном языке, формирует планы и действует в коммерческих 3D-играх через ввод с виртуальной клавиатуры/мыши (доступ к коду игры отсутствует). Он обобщает навыки на новые проекты и может играть в мирах, создаваемых в реальном времени, с Genie 3; ограничения включают короткую память и точность на дальний горизонт краткое описание функции.

Почему это важно для разработчиков: SIMA 2 — достоверный шаблон агентов, управляемых целями, в ограниченных 3D-интерфейсах. Если вы нацеливаетесь на робототехнику, это дешёвая песочница для оценки планирования, обратной связи и взаимодействия на естественном языке до работы с аппаратным обеспечением.

Клип Unitree G1 помечен как не дистанционно управляемый, вызывает спор об автономии.

Широко распространённое видео Unitree G1, на котором стоит подпись “NOT TELEOPERATED”, показывает плавное и разнородное выполнение задач, что вызывает вопросы о том, сколько из этого — автономия в реальном времени на борту, а сколько — дистанционное управление. Если это подтвердится, это заметный шаг для доступных гуманоидов к надёжному, общему управлению в реальном времени robot demo, и может подтолкнуть сроки робототехники вперёд, как некоторые наблюдатели отмечают, если утверждение верно timeline comment.)

Что делать: рассматривать это как перспективное, но не подтверждённое. Запрашивайте у поставщиков трассировки задержек ввода, характеристики вычислительной мощности на борту и вариативность задач по семенам перед тем, как экстраполировать риск дорожной карты на ваш стек.

UBTech Walker S2 выходит на масштабное внедрение на заводах с автоматической сменой батарей; запланировано 500 единиц.

UBTech утверждает, что Walker S2 гуманоиды сейчас используются в реальной фабрике в Китае, сотни уже отгружены, примерно $113 млн заказов на 2025 год и цель — 500 единиц к концу года; ключевая функция — самостоятелная замена батарей для почти непрерывной эксплуатации deployment details. Это помещает это в контекст демонстрации гуманоидов, где мы видели нарастание темпа; обновление сегодня подкрепляет цифры за счёт масштабируемого развёртывания, включая покупателей, например крупных автопроизводителей.

Почему это важно: если авто-замена поддерживает высокий уровень загрузки, гуманоиды перестанут быть развлекалкой раз за нажатие кнопки и начнут окупаться для повторяющейся работы на линии и смен на складе.

MindOn тестирует Unitree G1 для бытовых задач с новым аппаратно-программным стеком

Shenzhen MindOn Robotics испытывает обновлённое аппаратное и программное обеспечение на Unitree G1 для выполнения задач бытового уровня, близких к человеческим, таких как полив растений и перемещение посылок. Демонстрация демонстрирует плавные, разнообразные последовательности действий, которые свидетельствуют о лучшей связке восприятия и действия на платформе потребительского класса home tasks demo.)

Суть в том, что бытовые задачи обнажают проблемы с основой (grounding), зазоры и управление, насыщенное контактом. Если оцениваете дома, фиксируйте ошибки восприятия (ID объекта, поза, достижимость) отдельно от ошибок политики, чтобы сфокусировать ваши следующие циклы обучения.

Роботизированные руки ALLEX демонстрируют точный микроподбор и крепление с безопасным взаимодействием человека и робота.

ALLEX продемонстрировал руки с большим числом степеней свободы, выполняющие микро‑подбор и затягивание винтов с точными, повторяемыми движениями, сохраняя безопасные пределы взаимодействия человека и робота. Для производственных команд, исследующих сборку в рамках цикла «рука‑в‑петле», это конкретный взгляд на ловкое манипулирование, которое укладывается в практические компромиссы между скоростью и точностью демо рук-роботов.

И что дальше? По этому клипу можно оценить время выполнения задачи, долю успешности и допуски по коллизиям, чтобы очертить рамки пилотных станций (подсборка PCB, мелкие крепежи) перед покупкой зажимов.

Китай проводит испытания роботизированных дорожных конусов, которые автоматически ограждают место ДТП менее чем за 10 секунд.

Пилот демонстрирует, как самодвигающиеся конусы выдвигаются из аварийного автомобиля и образуют барьер за считанные секунды; единицы могут быть управляемыми дистанционно или действовать автономно, снижая риск для responders во время развертывания cone deployment.

К кому обращено внимание: городские оперативные службы и команды по безопасной эксплуатации автономных транспортных средств. Это узкая, ценная задача, где простая автономия приносит непропорциональные выгоды для безопасности — хорошая основа для развертывания, подбора емкости аккумулятора и разработки дистанционного управления."} } } )?} } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } } }

📚 Исследования: саморазвивающиеся агенты, память и эффективное рассуждение

Сегодняшние работы подчеркивают надежность процессов и эффективность: самоэволюцию агентов, сверхдлинные стеки памяти, вычисления LUT на FPGA, проверку фактов с упором на извлечение информации и калиброванное лаконичное рассуждение.

Плотное извлечение + классификатор (DeReC) превосходит рассуждения LLM и сокращает время выполнения примерно на 95%.

Для фактчекинга DeReC снимает ограничение на генерацию: извлекайте доказательства с помощью плотных эмбеддингов, затем классифицируйте. На RAWFC он повышает F1 до 65,58% (с 61,20% для базовой линии, генерирующей обоснование) и сокращает время выполнения с 454м12с до 23м36с (примерно на 95% быстрее). LIAR‑RAW демонстрирует аналогичные выигрыши по эффективности, что предполагает, что конвейеры с приоритетом поиска по запросу выгоднее с точки зрения задержек в продакшене и себестоимости аннотация к статье.

)

Крошечный кэш для Agent‑RAG обслуживает ответы из примерно 0,015% корпуса

Минимальный стек памяти для агентно-ориентированного RAG выполняет большинство запросов из микроскопического участка корпуса, сохраняя качество ответа и снижая потребление памяти и задержку для итеративных циклов поиска/генерации примечание к статье.

Открытый мир с множеством агентов ‘Station’ устанавливает SOTA по упаковке кругов и Sokoban

Станция — это окружение с открытым миром, в котором агенты выбирают комнаты и инструменты, ведут повествования и накапливают память о происхождении. Сообщённые результаты включают победу над AlphaEvolve при упаковке кругов (n=32, n=26), новый метод адаптивной по плотности для интеграции партий scRNA‑seq, и показатель решения Sokoban на уровне 94,9% с компактной архитектурой CNN+ConvLSTM project explainer, paper page.

По принципу on-policy, дистилляция «чёрного ящика» (GAD) толкает модель размером 14 млрд параметров к GPT‑5‑Chat

Генеративная состязательная дистилляция обучает дискриминатор вознаграждать выводы ученика, которые выглядят как проприетарный учитель, что обеспечивает обучение по текущей политике в режиме черного ящика.

A Qwen2.5‑14B‑Instruct, дистиллированная через GAD, демонстрирует результаты, сравнимые с GPT‑5‑Chat по авто‑оценкам LMSYS‑Chat, обгоняя базовые KD по последовательностям paper card, ArXiv paper.

Следование инструкциям против функциональности: больше инструкций — больше регрессии.

«Vibe Checker» от Google показывает, что многоинструкционные подсказки склонны снижать функциональную корректность, в то время как генерация за один ход сохраняет функциональность, а многошаговое редактирование лучше подходит для следования инструкциям. Таблицы охватывают Gemini, Claude, GPT‑5 и другие в рамках BigVibeBench и LiveVibeBench figure and table.

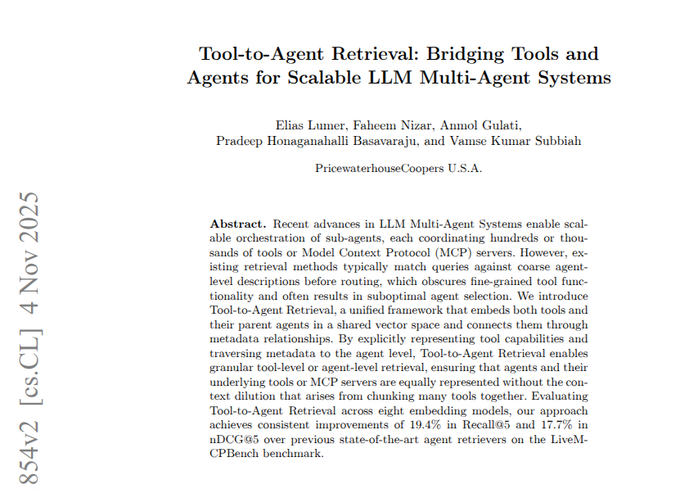

Умная маршрутизация инструментов повышает показатель recall в топ‑5 на 19,4% на LiveMCPBench

Новый подход к маршрутизации LLM к нужным инструментам/агентам повышает топ‑5 полноту на 19,4% на LiveMCPBench, что указывает на то, что слой вызова функций остаётся существенным рычагом для производственной надежности и охвата утверждение из статьи.

Agent‑RAG для финтеха повышает точность ответов за счёт расширения аббревиатур и усовершенствованного поиска

Агентная RAG-пайплайн, адаптированная под финансы, повышает точность за счет расширения аббревиатур, уточнения запросов и итераций с целенаправленным извлечением — демонстрируя доменно-ориентированные, инструментально управляемые преимущества по сравнению с обычной RAG утверждение статьи.)

DreamGym использует среды, смоделированные с помощью LLM, чтобы масштабировать обучение с подкреплением и ускорить перенос из симуляции в реальный мир

DreamGym сообщает о заметных улучшениях в RL, достигаемых путём обучения на опыте, смоделированном LLM, и переноса в реальные условия, подчеркивая практичный путь к более дешевым данным для обучения агентов project link.

Доктор MAMR рассматривает проблемы ленивых мультиагентных сбоев с причинным влиянием и перезапуском.

Исследование по многоагентному рассуждению вводит метрику причинного влияния для обнаружения «ленивых» агентов и использует действия перезапуска для восстановления, что приводит к более высокой эффективности группы в задачах рассуждений ссылка на статью.

Решатель векторной символьной алгебры достигает 83,1% на 1D‑ARC и 94,5% на Sort‑of‑ARC

Решатель ARC, вдохновлённый когнитивными принципами, кодирует объекты с помощью векторной символьной алгебры и изучает небольшие правила типа «если — то» для применения действий. Он достигает 83,1% на 1D‑ARC и 94,5% на Sort‑of‑ARC, хотя полный ARC‑AGI остаётся скромным на уровне 3,0% аннотация статьи.