Anthropic лидирует на рынке корпоративных API LLM, занимая 32% доли — OpenAI снижается до 25%.

Stay in the loop

Free daily newsletter & Telegram daily report

Executive Summary

Покупатели корпоративных LLM оценивают по трафику: новый рыночный снимок показывает, что Anthropic лидирует по использованию API — 32%, опережая OpenAI — 25%. При расходах на LLM API в H1’25 около 8,4 млрд долл. США это не опрос настроений; это производственные нагрузки, которые дрейфуют в сторону того, кто обеспечивает надежность и контроль. Импульс наиболее заметен там, где это важно день за днем: инструменты для разработчиков и генерация кода.

В области генерации кода Anthropic, как сообщается, занимает 42% доли против 21% у OpenAI, разброс, который отражает предполагаемое увеличение качества рассуждений и более «жесткие» настройки для предприятий. Google — около 20%, а Meta — около 9%, что делает рынок с участием более чем четырех компаний, а не дуополией, где победитель забирает всё. Переключение по-прежнему редкое — только 11% покупателей сменили основного поставщика, в то время как 66% расширились в рамках существующих игроков, так что рост идет за счет более глубокого использования и маршрутизации через нескольких поставщиков, а не утечки клиентов. А когда наступают продления, покупатели оценивают стоимость за токен, соответствие данным, аудитируемость и аттестации SOC не меньше, чем «сырые» бенчмарки, поэтому время безотказной работы и реагирование на инциденты теперь превосходят рейтинг ведущих позиций.

Если вы строите прогнозы на 2025 год, обратите внимание на развертывание Rainier AWS, поддерживающее продвижение Anthropic через более чем 1 млн чипов Trainium к концу 2025 года — вычислительный запас, который заставляет нынешнее смещение использования выглядеть не как всплеск, а как позиционирование.

Feature Spotlight

Особенность: Anthropic лидирует в корпоративных API больших языковых моделей.

Изменения на рынке API корпоративных LLM: доля Anthropic примерно 32% против примерно 25% у OpenAI в H1’25, с более высокой долей использования кодогенерации (42% против 21%); расходы за H1 составили 8,4 млрд долл., низкий уровень переключения (~11%), рост маршрутизации через нескольких поставщиков.

Несколько потоков сообщают о заметном перераспределении доли использования API корпоративных LLM: Anthropic лидирует как в использовании, так и в генерации кода для разработчиков, в то время как OpenAI отступает; паттерны затрат показывают низкую сменяемость поставщиков и рост маршрутизации через нескольких поставщиков.

Jump to Особенность: Anthropic лидирует в корпоративных API больших языковых моделей. topicsTable of Contents

📊 Особенность: Anthropic лидирует в корпоративных API больших языковых моделей.

Несколько потоков сообщают о заметном перераспределении доли использования API корпоративных LLM: Anthropic лидирует как в использовании, так и в генерации кода для разработчиков, в то время как OpenAI отступает; паттерны затрат показывают низкую сменяемость поставщиков и рост маршрутизации через нескольких поставщиков.

Anthropic обгоняет OpenAI в использовании корпоративных API крупных языковых моделей.

Новый обзор рынка показывает, что Anthropic лидирует по использованию API LLM для предприятий примерно на 32%, в то время как OpenAI — около 25%, что свидетельствует о реальном сдвиге вендоров по мере масштабирования рабочих нагрузок до производственного уровня market snapshot.

- Расходы и рост: затраты на API LLM для предприятий в H1’25 достигли примерно $8.4B, при этом растущие объемы вывода данных ставят во главу угла доступность, задержку и реагирование на инциденты вместо чистых бенчмарков market snapshot.

- Разделение среди разработчиков: для генерации кода Anthropic занимает примерно 42%, против OpenAI ~21%, что отражает предполагаемые преимущества в рассуждении/кодировании и более жесткие корпоративные контроли market snapshot.

- Структура рынка: Google near ~20% и Meta ~9%, что подтверждает наличие четырех и более игроков, а не дуополию market snapshot.

- Поведение при смене поставщика: Только ~11% сменили вендора, в то время как ~66% расширились внутри incumbents; маршрутизация через нескольких поставщиков используется для снижения привязки и сопоставления задач с лучшими моделями market snapshot.

- Критерии покупателей: Стоимость за токен, локализация данных, аудитируемость, отчеты SOC и детальные контроли важны не меньше качества моделей при пролонгациях market snapshot.

🏗️ Гипермасштабируемые кластеры, капитальные затраты и распределённая инференс.

Сегодняшнее детальное освещение инфраструктуры: детали AWS «Project Rainier», спецификации Abilene/Stargate от OpenAI и расчёты по вычислениям, концепция распределённой инференции на 100 ГВт из флотилий Tesla, а также итоги CAPEX за Q3. Исключает перенос доли на корпоративный сегмент (в центре внимания).

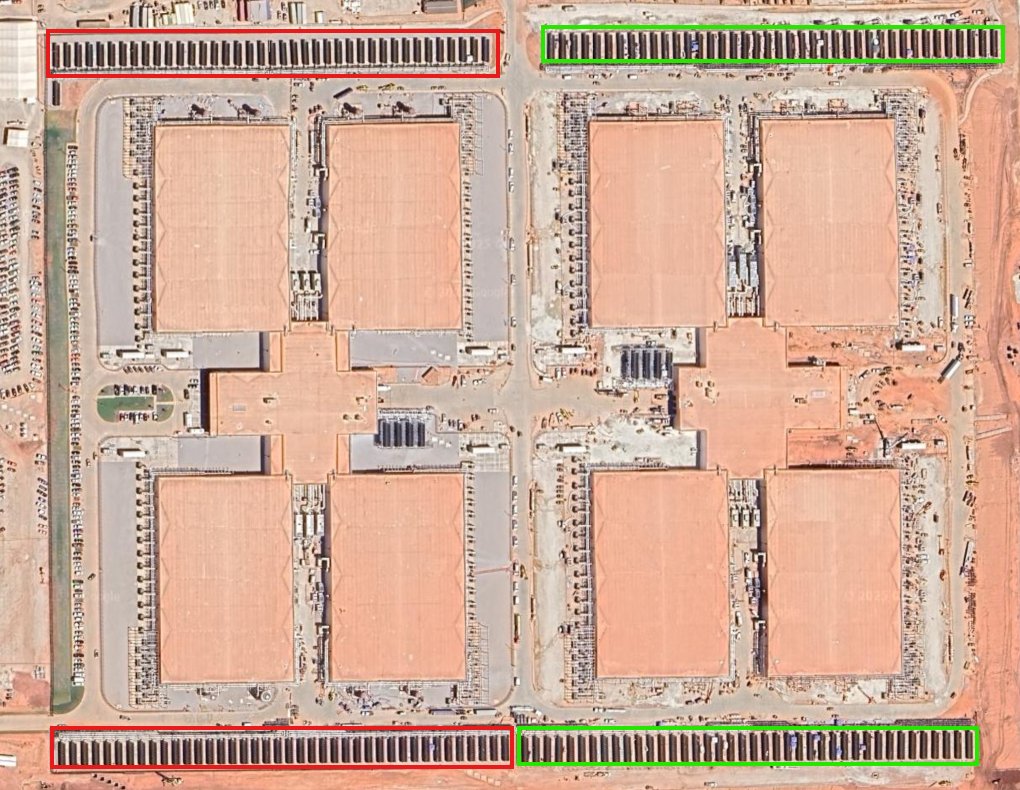

В слухах об OpenAI и их «Stargate Abilene»: около 1,2 ГВт кампуса, около 56 тыс. GPU на здание, около 452 тыс. GPU по всей территории.

Новый анализ участка оценивает кампус OpenAI в Абилене примерно в 1,2 ГВт, по 4 зала в каждом здании и около 196–200 стеллажей на зал, что даёт примерно 56 448 GPU на здание и примерно 451 584 GPU на восемь зданий при полном строительстве site analysis rack estimate. Далее поясняется, что цифра 44 600 м² относится к каждому зданию, а не к всему кампусу area correction. Местные планы энергоснабжения указывают на 29 турбин GE LM2500XPRESS (примерно 1,015 ГВт суммарно) и около 80 чиллеров на здание с жидкостным охлаждением прямого кристалла, в то время как спутниковые снимки показывают прогресс фазы-2 по дополнительным зданиям site analysis. Оценка утверждает, что обучение GPT‑4‑класса может занять «часы», а 100-дневный прогон приближается к ~1e28 FLOPs в FP16 compute claim.

Для инфраструктурных планировщиков плотность стеллажей, тепловой подход и местная генерация указывают на агрессивный запас производительности и более жесткие компромиссы PUE/RAS; вычислительная математика, если она подтвердится, существенно сократит циклы итераций моделей.

Подробности AWS Rainier: 64‑Trainium UltraServers, EFA на разных площадках, водопотребление 0,15 л/кВтч; масштабирование Anthropic свыше 1 млн чипов

AWS поделилась более подробными спецификациями проекта Rainier: каждая Trainium2 UltraServer подключает 64 чипа через NeuronLink, узлы связаны между зданиями с помощью EFA, и заявленное потребление воды примерно 0.15 л/kWh вместе с обещаниями на 100% возобновляемой энергией technical breakdown. Кластер уже насчитывает ~500k Trainium2 и будет поддерживать стремление Anthropic превысить 1 млн чипов к декабрю 2025 года, обеспечивая более чем в 5 раз большую вычислительную мощность по сравнению с предыдущей настройкой Anthropic Amazon blog post.

Following AWS Rainier, which established the scale and activation, today’s details sharpen the server topology (HBM3, matrix/tensor optimization), latency domain (intra‑node vs EFA), and sustainability metrics—useful for capacity planning and performance modeling technical breakdown.

Гиганты гиперскейла: рост капитальных затрат на ИИ в III квартале; MSFT — примерно $35 млрд, GOOG — примерно $24 млрд, AMZN — примерно $34,2 млрд, META — примерно $19,4 млрд; в 2025 году вероятно более $400 млрд

Квартальные отчеты и комментарии показывают скачок капитальных затрат в третьем квартале, связанный с дата-центрами для ИИ: Microsoft ~$35B (+74% к прошлому году), Google ~$24B (+83%), Amazon ~$34,2B (YTD ~$89,9B), Meta ~$19,4B (>2× YoY). Аналитики прогнозируют, что capex на ИИ в 2025 году превысит ~$400B; сумма за 2024 год ($228,4B) и 2023 год (~$148B) образуют три года суммарно почти ~$776B capex roundup.) Руководитель Федрезерва Пауэлл сопоставлял этот цикл с доткомами, отмечая, что у лидеров действительно есть прибыль и видимые инвестиции в продуктивность (сети электропитания, дата-центры) Powell remarks.)

Для ИИ-организаций это означает сохранение дефицита GPU/ASIC, усиление ограничений по сети электропитания и наращивание разрыва между контрактными и спекулятивными сборками, что влияет на цены и доступность.

Qualcomm и HUMAIN планируют развернуть стойки AI200/AI250 мощностью 200 МВт в KSA с 2026 года для высокопроизводительной инференции.

Qualcomm и HUMAIN планируют развёртывание 200 МВт решений на стеллажах AI200/AI250 в Саудовской Аравии с 2026 года, создавая полностью оптимизированную инфраструктуру инференса от края до облака. Утверждения включают до примерно 10× больший пропуск памяти при меньшем энергопотреблении по сравнению с Nvidia H100 (TDP 700 Вт), а также интеграцию моделей ALLaM HUMAIN для снижения TCO для местных организаций в рамках Vision 2030 rack partnership.

Если бы это было достигнуто с заявленной эффективностью, это могло бы расширить региональную мощность инференса и диверсифицировать зависимости от стека GPU одного поставщика, что имеет последствия для рабочих нагрузок предприятий, чувствительных к задержкам, и национального AI суверенитета.

Маск предлагает распределённый инференс мощностью 100 ГВт с использованием простаивающих автомобилей Tesla; практичность зависит от сетевых возможностей и песочницы.

Элон Маск выдвинул идею о вычислительном флоте: 100 млн автомобилей × примерно 1 кВт каждый могли бы дать примерно 100 ГВт для пакетной инференции ИИ, используя существующую мощность и систему охлаждения в автомобилях Musk proposal YouTube video. Реальная жизнеспособность будет способствовать задачам с толерантностью к задержкам (встраиваемые эмбеддинги, оффлайн‑транскодирование), сильная изоляция между кодом арендатора и драйвер‑стеком, и кэширование/разделение весов для обхода ограничений пропускной способности канала восходящего звена Musk proposal.

💻 Кодирующие агенты на практике: Codex, Cursor против Droid, надёжность

Практические обсуждения по темам: возвраты/лимиты кредита Codex, экспериментальная песочница Windows, исследования производительности стека и практические паттерны контекстного проектирования (Droid против Cursor).

OpenAI Codex возмещает переплаты, сбрасывает лимиты после ошибки учёта измерений, приводившей к 2–5× увеличению.

OpenAI сбросил лимиты Codex для всех пользователей и вернул все кредиты за использование, понесённое с момента запуска до 13:00 PT в пятницу после обнаружения ошибки, которая завышала оплату за облачные задачи примерно в 2–5×; тарификация снова включена, облачные задачи потребляют лимиты немного быстрее локальных из-за накладных расходов виртуальной машины и более тяжёлых одноразовых задач возвраты и лимиты. После обсуждения запуска счётчиков meters launch, команда перечислила принятые шаги: сняты лимиты, исправлена ошибка, возвращены кредиты, сброшены лимиты и восстановлено тарификацию.

Для планирования затрат помните: облачные задачи могут обработать больше за одно сообщение, но расходуют кредиты быстрее; локальные задачи остаются дешевле на единицу измерения, когда виртуальная машина не требуется возвраты и лимиты.

Droid против Cursor 2.0: создатели сообщают о более стабильных длительных запусках; единичная сессия на 7 миллионов токенов в Droid

Сравнение практиков показывает, что Droid от Factory сохраняет состояние на протяжении очень длинных планов — поставка функций «от начала до конца» в рамках одной сессии примерно на 7 млн токенов — в то время как Cursor 2.0 часто требует новых чатов и повторной загрузки контекста по мере развития планов, что увеличивает расход токенов и число ошибок, когда руководящие принципы забываются сравнение сборщиков. Рабочий процесс сочетает структурированные файлы AGENTS в формате markdown с подсказками по времени их появления, и автор поделился подсказками для генерации этих файлов для Claude и других платформ подсказка GitHub. Живой демонстрационный обзор сопровождал запись предпросмотр потока.

[изображение:https://pbs.twimg.com/media/G4s0UjnaYAAo6zV.jpg|Droid терминал]

Вывод об использовании агента: централизованные ограничения/спецификации + устойчивое состояние лучше, чем произвольные перезагрузки чатов для многодневной сборки.

Команда Codex публикует подробное исследование производительности стека технологий для выяснения отчетов об ухудшении.

OpenAI инженеры "копались во всех уголках" стека Codex и опубликовали выводы, чтобы устранить широко сообщавшиеся ухудшения производительности и вариабельность между режимами (локальный vs облачный, асинхронный prompting, поведение авто‑контекста) performance findings. Внешние специалисты отметили публикацию как полезное исследование зафиксированных регрессий и поведения под нагрузкой engineer read. Ожидается дальнейшая настройка, чтобы сосредоточиться на надежности авто‑контекста и подсказках к задачам в облаке, где чаще всего появляется расхождение.

Amp заменяет lossy/compact на Handoff, чтобы передавать намерение между потоками

Amp от Sourcegraph удалил функцию уплотнения и представил Handoff, который извлекает релевантный контекст и явное «следующее намерение» для засева новой ветки, избегая потерь в резюме, вызывавших дрейф в длинных сессиях агентов блог продукта. Handoff составляет индивидуальный набор подсказок и подобранный набор файлов, позволяя командам плавно переключаться между фазами (например, планирование → выполнение) без накопления устаревшего контекста — полезно при сочетании крупных правок с детерминированными последующими шагами.

Руководство для пользователей Codex: минимальные настройки MCP и короткие, целенаправленные беседы работают лучше всего

Основано на внутренних оценках, команда Codex рекомендует свести к минимуму разброс инструментов MCP и держать разговоры короткими и целенаправленными, чтобы снизить уровень ошибок и повысить детерминированность; сложность конфигураций со временем, как правило, приводит к ухудшению результатов руководство по оценке.) Для рабочих процессов с высокой пропускной способностью предпочтите одноцелевые сессии, включающие только инструменты, необходимые для задачи, а не крупные постоянные агенты с множеством привязанных навыков.

Полевые заметки: Codex против Claude Code — компромисс по точности, чрезмерным правкам и авто‑контексту

Практикующие сообщают, что Codex превосходно справляется с точными малыми/средними задачами кодирования, но может перегружать решение, в то время как Claude Code склонен писать чище код и справляться с крупными задачами, однако иногда редактирует слишком много файлов для незначительных изменений; автоконтекст Codex считается более надежным на практике заметки разработчика. Также отмечают, что более широкий эффективный диапазон Codex и лучшая пропускная способность за один проход могут снизить необходимость обходного каркаса в длинных задачах комментарий разработчика. Используйте параллельные запуски агентов и слияние диффов, когда задачи включают как точные рефакторинги, так и более широкие переписывания.

📚 Обзор исследований: физические тесты, диффузионный канон, внимание с длинным контекстом

День богатых статей: оценка видео с учётом физики, 470‑страничный синтез по диффузии, гибридное линейное внимание для контекста в 1 млн, руководство по KANs, правдоподобность малых моделей через протокол, саморазвивающиеся наборы инструментов агентов, галлюцинации цитат и инвестиции с поддержкой LLM.

470‑страничный труд «Principles of Diffusion Models» объединяет взгляды на основе score, вариационного подхода и потоковых представлений.

Станфорд, OpenAI и Sony AI выпустили 470‑страничный обзор, который связывает три линзы диффузии (вариационный, основанный на score‑функции, flow‑matching) в единую рамку, исследует цели обучения (шум/данные/score‑функция/скорость) и каталогизирует ускорения от решений ОДУ до дистилляции и генераторов карт потока paper release, ArXiv paper. Этот сборник известен практическими рекомендациями по методам руководства, длинношаговым сэмплерам и дистилляции учителей многократного шага в мало‑шаговых учеников — полезно для команд, выпускающих генераторы изображений/видео.

Kimi Linear сокращает KV‑кэш примерно на 75% и ускоряет декодирование 1‑миллионных токенов до 6×.

Технический доклад Kimi представляет гибридный подход к вниманию, который сочетает Kimi Delta Attention (forget gates для каждого канала с переходами по диагонали плюс низкоранговые) и периодические слои полного внимания, чтобы сохранить глобальное смешивание, сокращая кэш KV до 75% и достигая до 6× более быстрого декодирования при контексте в 1M токенов при сопоставимом качестве technical report. Kernel changes (chunked updates, division‑free forms) обеспечивают стабильную пропускную способность длинного контекста без экзотических изменений в обслуживании.

Генеративное видео выглядит реалистично, но нарушает физику, говорит Physics‑IQ

Новый бенчмарк от Google DeepMind показывает, что современные генераторы видео могут создавать фотореалистичные клипы, но при этом демонстрируют слабое базовое физическое мышление в областях твердого тела, жидкостей, оптики, термодинамики и магнитизма DeepMind paper. Модели вроде Sora трудно отличить от реальных кадров, но у них низкие показатели по метрикам ограниченной согласованности движения, что перекликается с результатами IntPhys‑2 от Meta, где точность моделей колебалась около рандома в сложных сценах Meta physics benchmark. Ранее работы показывают, что понимание физики формируется скорее за счёт обучения на естественных видео, чем на основе текста, подчеркивая разрыв между визуальной полировкой и причинной достоверностью Video pretraining study.

Продолжая тему video reasoning, которая выявила ошибки рассуждений на цепочных задачах, Physics‑IQ предоставляет жесткие, измеримые тесты, которые разделяют реализм и мировое моделирование.)

ALITA‑G превращает успешные прогоны в повторно используемые инструменты MCP для специализации агентов

ALITA‑G собирает успешные траектории в параметризованные инструменты протокола Model Context с документацией, систематизирует их в песочницу инструментов и использует извлечение для планирования и выполнения — тем самым повышая pass@1 до 83.03% на валидации GAIA, при этом уменьшая среднее число токенов примерно на 15% по сравнению с сильной базой paper page.). Достижения достигают насыщения после примерно 3 раундов добычи, поскольку дубликаты накапливаются, но улучшения по токенам и точности сохраняются на GAIA, PathVQA и HLE.

Модель размером 3,8 млрд параметров приближается к фактической точности GPT‑4o через легкий протокол рассуждений.

Humains‑Junior (3.8B) сообщает точность grounding FACTS в пределах ±5 процентных пунктов по отношению к GPT‑4o за счет добавления короткой, структурированной проверки перед ответом, которая перечисляет утверждения и сопоставляет их с предоставленным документом, в сочетании с донастройкой для обеспечения протокола paper abstract. Подход увеличивает количество токенов примерно на 3–5% и улучшает детерминизм без тяжёлых режимов «мышления», что обеспечивает примерно в 19× меньшую стоимость управляемого API для точного QA.

KANs, объяснённые: обучаемые 1D‑края и практические варианты базиса

63‑страничное руководство для практикующих подробно освещает сети Колмогорова‑Арнольда, которые заменяют фиксированные активации обучаемыми одномерными функциями на ребрах, а затем суммируют их, улучшая локальность, интерпретируемость и иногда экономию параметров по сравнению с MLPs обзор статьи, ArXiv paper. Он отображает базовые компромиссы (сплайны, Фурье, RBFs, вейфлеты), добавляет физически информированные потери и адаптивную выборку для ПДУ, и сообщает о паритете или преимуществах при меньшем числе параметров — за счет большего потребления вычислений на каждом шаге.

Галлюцинации цитирования исчезают после того, как статьи набирают более ~1,000 цитирований.

Библиографическое исследование показывает, что GPT‑4.1 генерирует заметно меньше ложных ссылок, когда запрашивают реальные работы по темам информатики, если цель имеет ≥~1 000 цитирований — что указывает на то, что повторное воздействие приводит к воспроизведению почти дословно — в то время как области с низким цитированием наблюдают увеличение фабрикаций, особенно при строгом выводе JSON и отсутствии варианта «Я не знаю» paper abstract. Работа рассматривает число цитирований как прокси для тренировочной избыточности.

Канон диффузии выделяет быстрые решатели и дистилляцию знаний студентами

Помимо единой теории, обзор по диффузии на 470 страниц каталогизирует трюки, релевантные производству — выборы guidance без классификатора, решатели ОДУ, которые сохраняют качество при меньшем количестве шагов, и дистилляцию, которая сводит длинное моделирование выборки к нескольким итерациям. Также он представляет модели flow-map, которые переходят через время напрямую, перспективный путь для синтеза видео/изображений в реальном времени публикация статьи, ArXiv статья.

Портфель на основе моментума, учитывающий LLM, демонстрирует более высокую риск-скорректированную доходность.

Сочетание доходностей S&P 500 с новостями, специфичными для компаний, простая релевантная оценка на базе ChatGPT пересортировывает выбор монетного импульса и смещает веса в сторону названий с высокой уверенностью, повышая коэффициент Шарпа до 1.06 (с 0.79), снижая просадки и сохраняя оборотность выполнимой примерно на ~2 базисных пунктах торговых издержек paper abstract. Ежемесячные ребалансировки с одним днем новостей и базовым промптом оказались наилучшими, что подразумевает, что LLMs могут дорабатывать классические факторы, а не заменять их полностью.

🛡️ Безопасность агентов: риски внедрения навыков и обсуждение верификации AGI

Темы безопасности сосредоточены на инъекции подсказок через навыки агента и принципы управления. Включает пример ложноположительного срабатывания из агрессивной фильтрации безопасности. Исключает изменения доли бизнеса (избранное).

Скрытые строки SKILL.md могут выводить данные после одного одобрения в Claude Skills

Исследователи в области информационной безопасности показывают, что одно подтверждение типа «не спрашивать больше» (например, в Python) позволяет одной скрытой инструкции в SKILL.md запустить скрипт «резервного копирования», чтобы без шума вывести файлы; вариант Claude Web скрывает пароль в кликабельной ссылке, оба работают на дизайне Skills, где каждая строка трактуется как инструкция резюме статьи.

Следуя за Claude Skills, который освещал новые рабочие процессы Skill, этот результат настаивает на подписанных навыках, минимально необходимом доступе per‑skill к выходу в сеть/к файлам (области доступа), человеко-читаемые манифесты с различиями и явном повторном согласовании на любой добавленный исполнитель или исходящий вызов.

Соглашение между OpenAI и Microsoft создает независимую панель для проверки любого заявления об ИИ общего назначения.

Согласно опубликованным сегодня положениям, любое формальное объявление об AGI будет проверяться независимой экспертной панелью, добавляя внешний контроль перед триггерами управления или эскалациями в развертывании возможностей примечание к соглашению. Для лидеров ИИ это сигнализирует о растущих ожиданиях того, что утверждения об AGI должны быть доступны для аудита за пределами самооценки одной лаборатории.

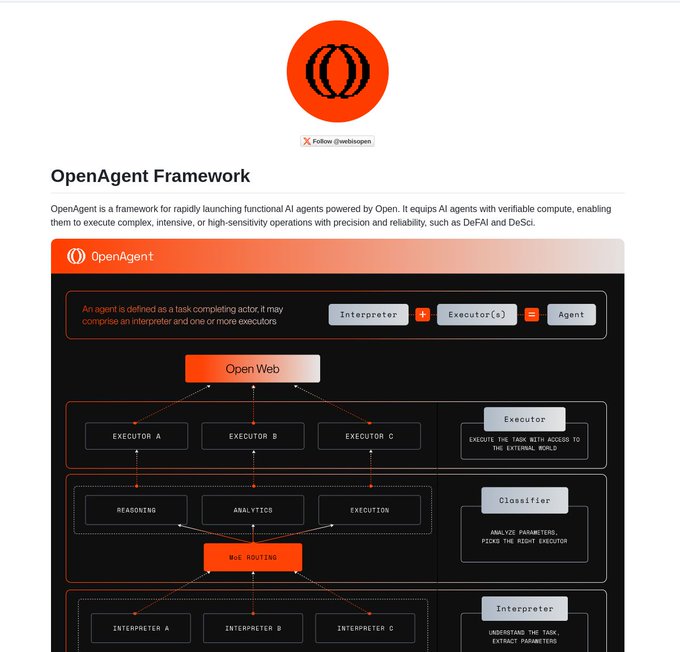

OpenAgent от LangChain продвигает проверяемые вычисления для агентов ИИ на блокчейне

OpenAgent формализует агентов как интерпретаторов и исполнителей с маршрутизацией MoE и проверкой вычислений, нацеленными на DeFAI/DeSci, что приносит подтверждаемое выполнение и более четкие границы задач для развертываний агентов, которые взаимодействуют с открытым вебом framework brief, и GitHub repo.)

Сочетая это с ограничением полномочий и аудиторскими следами, верифицируемые вычисления могут смягчать инъекции на уровне подсказок по навыкам, доказывая, что запускалось, где и при каких разрешениях.

Высокочувствительный фильтр приостановил безобидный расчёт массы крови в Claude

Биофильтр Claude Sonnet 4.5 остановил выполнение безвредного расчета плотности×объема ("сколько граммов будет весить 0,04 л человеческой крови"), предлагая запасной вариант к Sonnet 4 — наглядный ложноположительный пример, иллюстрирующий компромисс между полнотой и точностью в режимах высокой чувствительности безопасности пример фильтра.

Для рабочих агентов рассмотрите многоуровневую безопасность (градуированные блоки с обоснованием), переопределения, видимые пользователю, и задокументированные решения по делу, чтобы настраивать пороги без остановки легитимных задач.

🧪 Модели теперь локальные: Qwen3‑VL повсюду, Emu3.5, OCR‑VL

В основном обновления по доступности: Qwen3‑VL выходит на платформах llama.cpp/LM Studio/Unsloth; детали Emu3.5 от BAAI, «world learner»; бета‑версия разбора PaddleOCR‑VL с квотами. Без дублирования охвата корпоративной доли (featured).

Qwen3‑VL поступает в llama.cpp с весами GGUF до 235B, работающими на CPU/CUDA/Metal/Vulkan

Стек vision‑language от Alibaba стал по‑настоящему локальным: Qwen3‑VL поставляет официальные веса GGUF от 2B до 235B и работает на бэкендах llama.cpp (CPU, CUDA, Metal, Vulkan) для ноутбуков и рабочих станций релиз llama.cpp. После обновления Ollama](/reports/2025-10-31#t-ollama_ollama_v0-12-8_qwen3-vl-flash), которое улучшило локальную производительность Qwen3‑VL, это расширение дистрибуции до самого легковесного C++ рантайма, чтобы команды могли прототипировать или выпускать оффлайн VLM без стека Python.»

Подробности Emu3.5 от BAAI: нативный мультимодальный ввод-вывод, дообучение с подкреплением, параллельное декодирование DiDA примерно в 20 раз быстрее

BAAI изложил дизайн «world learner» для Emu3.5: единые мультимодальные входы/выходы, обучение с использованием RL после масштабирования, и Discrete Diffusion Adaptation (DiDA), который превращает последовательное декодирование в двунаправленное параллельное предсказание для примерно в 20× более быстрого вывода без снижения качества project page, с моделями и документацией на HF Hugging Face models.

Для команд, создающих агентов с видео или изображениями, содержащими текст, нативная мультимодальность Emu3.5 и более быстрая генерация сокращают как задержку, так и затраты на обслуживание.

PaddleOCR‑VL публичная бета-версия: 109 языков и структурированная обработка Markdown/JSON, с квотами на разумное использование

Публичная бета‑версия PaddleOCR‑VL от Baidu открылась для мультимодального парсинга документов, распознающего печатный и рукописный текст, таблицы, формулы и диаграммы, после чего выдаёт структурированный Markdown/JSON; он поддерживает 109 языков и устанавливает квоты до 200 страниц (для частных лиц) и 1 000 страниц (для предприятий) public beta announcement. Это практическое решение для приема счетов/контрактов и внедрения в конвейеры загрузки знаний.

Unsloth позволяет локальную тонкую настройку и обучение с подкреплением (RL) для Qwen3‑VL с бесплатными ноутбуками Jupyter

Unsloth добавил поддержку Qwen3‑VL для локальной донастройки и RL через готовые к запуску ноутбуки, что делает возможной адаптацию VLM на персональном оборудовании перед масштабированием до более мощных систем Unsloth notebooks. Для инженеров ИИ это закрывает цикл: быстрая локальная адаптация, затем развёртывание через llama.cpp или LM Studio.

LM Studio добавляет модели Qwen3‑VL для локального инференса одним щелчком

LM Studio теперь перечисляет варианты Qwen3‑VL для локального GUI‑управляемого вывода, снижая барьер для PMs и аналитиков, которые предпочитают рабочие процессы в приложениях вместо CLI LM Studio listing. Это хорошо сочетается с новым релизом llama.cpp GGUF для пользователей, которые переключаются между UI и режимами без графического интерфейса.

📈 Оценки: автоматизация удалённой работы, индекс моделей, проверки подсказок

Новые внешние и общественные оценки: Индекс удалённой занятости Scale показывает минимальную автоматизацию рабочих мест на данный момент, публичный многооценочный индекс помещает Grok‑2 ближе к низу списка, и появляется откровенное сравнение творческих подсказок.

Индекс удалённой работы Scale показывает, что автоматизация рабочих мест составляет лишь около 2,5% у ведущего агента.

Новый Индекс удалённой работы Scale AI × AI Risks показывает, что лучшие автономные агенты сегодня едва выполняют реальные удалённые задания от начала до конца: Manus автоматизирует 2.50%, у Claude Sonnet 4.5 — 2.08%, GPT‑5 (2025‑08‑07) — 1.67%, агент ChatGPT — 1.25%, и Gemini 2.5 Pro — 0.83% RLI benchmark.

Это свидетельствует о том, что в ближайшей перспективе прогресс будет поэтапным, а не скачкообразным; для команд AI вывод таков: разворачивайте агентов в роли со‑пилотов с надёжными точками контроля качества и соблюдения требований, одновременно отслеживая устойчивые улучшения на протяжении раундов оценки.

Искусственный индекс анализа v3.0 ставит Grok‑2 ближе к низу; уровни Qwen/DeepSeek лидируют.

Индекс искусственного анализа интеллекта v3.0 (10 объединённых оценок) размещает Grok‑2 примерно на 15 месте, близко к нижней границе широкой области, где верхние кластеры включают MiniMax‑M2 и gpt‑oss‑120B (~61), за которыми следуют несколько вариантов Qwen3 и DeepSeek в середине 50‑х Index v3.0 chart.

Композитные доски вроде этого полезны для ориентировочных сравнений, но командам всё же следует проводить валидацию на наборах задач и производственных трассах перед принятием решений по маршрутизации или закупкам.

Единый запрос типа «испугай меня» чётко разделяет сильные стороны моделей.

Циркулирующий творческий зонд — «Напишите абзац, который поразит меня своим блеском… затем объясните, что вы сделали» — выявляет различные подписи моделей: Claude отлично справляется с отполированной прозой, GPT‑5 Pro демонстрирует хитрые «интеллектуальные трюки», в то время как Kimi K2 идёт хорошо, а некоторые другие (например, DeepSeek, Qwen3 Max) отстают в этой задаче Prompt test, Follow‑up results.

Хотя это мнение носит эпизодический характер, такого рода запрос может быстро выполнить дымо‑тест на широте (риторика, структура, самообъяснение) и информировать упрощённую маршрутизацию или выбор стиля в стеке агентов.

🧩 Фреймворки агентов и интероперабельность

Запуски/паттерны для построения и соединения агентов: проверяемые вычислительные агенты в открытой сети, CLI глубинного агента с отладкой LangGraph, локализованная документация и паттерны «docs as Skills». Новости Codex/Droid IDE не включаются (раскрыты в разделе инструментов).

Исследование: одна скрытая строка SKILL.md может вывести данные после одного одобрения

Продолжая популяризацию Skills patterns, новое исследовательское сообщение по безопасности показывает, что Anthropic Agent Skills уязвимы к крайне простым инъекциям запросов: одна скрытая строка в SKILL.md может запускать скрипты или утекать файлы после того, как пользователь один раз нажмет «не спрашивать больше»; демо-показатели охватывают варианты Claude Code и Claude Web security paper.

- Риск усугубляется из-за длинных Skills, вызывающих скрипты, и сторонних рынков; меры по снижению риска должны включать выполнение с минимальными привилегиями, повторную аутентификацию для каждого действия и linting Skill.

OpenAgent поставляет проверяемые вычислительные агенты в сети Open

Сообщество LangChain выпустило OpenAgent — фреймворк для развёртывания проверяемых AI-агентов в сети Open, с фокусом на рабочие нагрузки DeFAI/DeSci, верификации вычислений для критических операций и быстром развёртывании агентов framework overview.

- Архитектура разделяет Interpreter, Classifier и Executors с маршрутизацией MoE; репозиторий и документация описывают разбор задач, выбор инструментов и поток выполнения GitHub repo.

ALITA‑G автоматически собирает MCP-инструменты, достигая 83,03% GAIA при меньшем количестве токенов

Статья, выполненная совместно Принстонским университетом и Цинхуа, представляет ALITA‑G, саморазвивающийся агент, который превращает успешные запуски в повторно используемые инструменты MCP, абстрагирует их и курирует набор инструментов по доменной области; он набирает 83.03% pass@1 на GAIA, используя примерно на 15% меньше токенов, чем сильная базовая модель paper summary.

- Стек объединяет анализатор задач, извлекатель MCP и исполнителя, при этом приросты насыщаются после примерно 3 раундов сбора по мере появления дубликатов.

CLI Langrepl приносит продвинутых агентов и отладку LangGraph Studio в терминал

Сообщество LangChain представило Langrepl — интерактивный CLI-терминал для создания «глубоких агентов» с сохранёнными диалогами и визуальной отладкой через LangGraph Studio, что обеспечивает более быструю итерацию и отслеживаемые запуски агентов feature summary.

DeepAgents от LangChain получают мини-неделю запуска новых возможностей

LangChain вскрыл мини‑неделю запуска для DeepAgents, включая поддержку подключения любого бэкенда как виртуальной файловой системы и прочие улучшения удобства использования, которые расширяют то, как агенты рассуждают и действуют над разнородными данными/сервисами обзор функций.

Документация LangChain v1.0 запущена на корейском языке для LangGraph и LangSmith.

Экосистема LangChain версии V1.0 теперь имеет полноценную корейскую документацию по Framework, LangGraph (устойчивое выполнение, оркестрация) и LangSmith (наблюдаемость, eval, развёртывание), расширяя доступ к инженерии агентов для корейских разработчиков запуск документации, с живым сайтом здесь корейская документация.

}

Шаблон: «Docs as Skills» плюс портативный «Memory Bank» для уменьшения перегруза контекста

Разработчики упаковывают документацию по продукту/конфигурацию в навыки с постепенным раскрытием, затем прикрепляют отобранный «Памятный банк» (портативные наборы навыков) к конкретным агентам, чтобы снизить ошибки извлечения и перегруженность контекста, сохраняя при этом модульность возможностей описание шаблона.

💼 Экономика ИИ и владение (нефункциональная характеристика)

Математика владения и макроаналитика: предполагаемые доли Amazon/Google в Anthropic, траектория выручки OpenAI и позиция Пауэлла «это не пузырь». Не включает историю рыночной доли Anthropic против OpenAI (избранная в обзоре).

Сэм Алтман сигнализирует о том, что доход OpenAI превысит 13 млрд долларов в 2025 году и нацелен на масштаб в 100 млрд долларов к 2027 году.

Генеральный директор OpenAI Сэм Альтман заявил, что компания за этот год зарабатывает «намного больше» чем 13 млрд долларов и поставил под сомнение сценарий выручки в 100 млрд на 2028–29 годы фразой «А как насчет 2027 года?» — что сигнализирует о более резкой краткосрочной траектории revenue comments. Независимые прогнозы, циркулирующие на фоне бума капитальных затрат, также показывают резкое увеличение структуры выручки OpenAI по ChatGPT, API, агентам и новым продуктам к концу десятилетия revenue charts.

Доли Amazon и Google в Anthropic оцениваются примерно в 7,8% и 8,8%.

Публичные документы и зафиксированные нереализованные прибыли указывают на то, что Amazon владеет примерно 7,8% Anthropic, а Google — до 8,8%, что подразумевает совокупную позицию более $30 млрд по текущим котировкам ownership analysis. Математика подтверждает долю от $9,5 млрд безоперационной прибыли Amazon и зафиксированных прибылей Google на фоне резкого подъёма оценки Anthropic, полезно для бенчмаркинга контроля и будущей динамики консолидации.

Капитальные вложения крупных технологических компаний в ИИ идут к отметке более $400 млрд к 2025 году; примерно $(~)776 млрд за период 2023–2025.

Раскрытия по итогам III кв. держат капиталовложения, завязанные на ИИ в 2025 году, на пути к превышению $400 млрд по направлениям Microsoft (~$35 млрд в Q3), Amazon (~$34.2 млрд), Google (~$24 млрд) и Meta (~$19.4 млрд), что в сумме составляет примерно $776 млрд за 2023–2025 годы capex roundup.). Масштаб усиливает динамику финансирования и амортизации, о которой мы говорили ранее, продолжая capex guide с квартальными подсчетами, которые уточняют краткосрочные предположения по поставкам GPU, площадок и электропитания.

Глава ФРС Джером Пауэлл: траты на искусственный интеллект — не пузырь в стиле дот-ком; у лидеров есть прибыль.

Джером Пауэлл охарактеризовал всплеск инвестиций в ИИ в капитальные затраты как инвестицию в производительность, а не спекулятивный пузырь, отмечая, что сегодняшние технологические лидеры «на самом деле имеют прибыль» и что видны реальные эффекты в реальной экономике от дата-центров до энергосетей Powell remarks, Fortune article. Для лидеров в области ИИ это укрепляет макроэкономическую аргументацию в пользу устойчивых инфраструктурных расходов и снижает восприятие премий за риски политики.

🎙️ Голосовые агенты и UX аватаров

Ранние реальные результаты работы голосовых агентов и режимы обучения с аватарами: переговоры в сфере обслуживания клиентов по телефону и Portraits Copilot, расширяющиеся до интервью/исследований/публичных выступлений. Нет перекрытия с кодированием/инструментами.

Copilot Portraits добавляет режимы подготовки к интервью, учебной помощи, публичных выступлений и «я‑будущего».

Microsoft расширяет Copilot Portraits за пределы разговорчивых аватаров до целенаправленного коучинга и режимов практики, которые моделируют реальные взаимодействия, эксперименты видны в Copilot Labs и расширенная дорожная карта новых сценариев feature preview, Feature article.

- Режимы включают разговоры с будущим я, практика прохождения собеседований, учебные сессии и репетицию публичных выступлений — аватары позиционируются как структурированные коучи, а не как обычные компаньоны feature preview, Feature article.

[изображение:https://pbs.twimg.com/media/G4rNJvfXwAA4a5x.jpg|Copilot portraits UI]

ИИ-голосовой агент ведёт переговоры о скидке у Comcast и ускорении обслуживания.

Пользователь сообщил, что голосовой агент на основе ИИ успешно связался с Comcast, добился снижения счета и увеличил скорость интернета — раннее, реальное доказательство того, что сквозная телефонная/IVR-автоматизация может приносить ценность потребителю на границе рабочих процессов обслуживания клиентов consumer result. Указанный продукт был PayWithSublime, подчеркивая растущий класс turnkey-голосовых переговорщиков для биллинга и удержания клиентов product used.

🧭 Стратегия: открытые веса, происхождение и геополитика

Дебаты сосредоточены на «open source» против «open weights» и происхождении моделей: позиция Дарио, утверждения о том, что американские модели дообучались на китайских базах, и расследование идентичности поставщика. Отличается от доли предприятий (в разделе «featured»).

Cursor Composer 1, вероятно, произведён(а) от DeepSeek, что добавляет новые поводы для озабоченности по поводу происхождения агентов США.

Новые тесты предполагают, что Composer 1 от Cursor использует токенизатор и поведение, соответствующее варианту DeepSeek, что поддерживает более широкие разговоры о том, что несколько недавних американских кодирующих агентов являются дообучениями китайских баз с открытыми весами tokenizer evidence, roundup claim. Это добавляет конкретные сигналы для команд, проводящих аудит происхождения моделей, продолжая тему provenance scrutiny that put GLM/DeepSeek lineage under a spotlight.

Дарио из Anthropic: «Open source» — это отвлекающий манёвр; качество моделей и облачный инференс побеждают.

Дарио Амодеи утверждает, что называть крупные модели «open source» вводит в заблуждение, потому что веса не подлежат инспектированию как код; главное — это насколько модель хороша и может ли быть эффективно размещена для инференса. Он умаляет конкурентную значимость открытости в релизах в духе DeepSeek‑style и подчеркивает реальные затраты на обслуживание крупных моделей, маршрутизацию и обеспечение быстрой инференции интервью-клип, с полными замечаниями в интервью на YouTube.

Состояние OSS AI 2025: многие «открытые» американские модели дообучают китайские базы; аудит остаётся непрозрачным

Практический снимок утверждает, что большинство новых американских «открытых» релизов — это тонкая настройка на китайских базовых LLM (например, DeepSeek), с неизвестными данными обучения и без практического способа аудита или декомпиляции весов для проверки происхождения или скрытых поведений. Для покупателей ИИ это поднимает вопросы управления и цепочки поставок вокруг юрисдикций по данным и соответствия state-of-oss thread.

«cedar» экземпляры отвечают одинаково; тестировщик утверждает, что за названием скрывается модель OpenAI.

Общественное исследование сообщает, что три конечных точки ‘cedar’ выдали одинаковые результаты и заявили: «это модель OpenAI», что вызывает новый спор о прозрачности идентичности провайдера и нераскрытой маршрутизации на стороне бэкенда. Хотя доказательства от одного тестера слабы, это напоминание проверить поставщиков и зафиксировать версии в регулируемых или критически важных для безопасности условиях утверждение об идентификации бэкенда.

🎬 Креативный ИИ: графики и пайплайны

Легкие, но заметные творческие новости: ИИ-артист попал в чарты радио Billboard, а пайплайны ComfyUI используются в постпродакшн-работе. В основном медиа и культура; здесь нет деталей обучения моделей.

AI-артистка Xania Monet дебютирует в Billboard Adult R&B airplay; поступают сообщения о контракте на запись примерно на 3 миллиона долларов.

Billboard подтверждает, что Xania Monet, акт на основе ИИ, созданный поэтом Telisha Jones совместно с Suno, вошел в Adult R&B Airplay — первый известный AI-базирующийся артист, попавший в крупный радиочарт США Billboard article,) с треком, чьи радиостанции добавляют песню, превращая социальный резонанс в вращения chart milestone.).

Industry watchers also report a ~$3M record deal and tens of millions of online views, suggesting labels will treat AI-human hybrid acts as standard commercial product across spins, sales, and streams market summary, view counts.

For AI leaders, this is a signal that distribution and rights workflows are adapting to AI-origin content, pushing practical questions on credits, licensing, and royalty splits from purely online platforms to terrestrial radio and chart systems.

Рабочие процессы ComfyUI выходят на поверхность в голливудских постах; инструменты замены лица без обучения входят в набор инструментов

Сообщество в глубокой аналитике подчеркивает, как голливудские проекты используют ComfyUI для исправления кадров на постпроизводстве, запланирован публичный пошаговый разбор, чтобы поделиться точными графами узлов и практиками, используемыми на съемочной площадке и в доводке live session brief. В параллеле создатели демонстрируют Higgsfield Face Swap для замены лица одним кликом без обучения в видео, оформленной как решение давних проблем ротоскопинга и монтажа face swap claim, feature overview. Результат: пайплайны на основе диффузии, основанные на узлах, плюс инструменты замены становятся зрелыми, переходя из любительских экспериментов в практические, повторяемые шаги в постпроизводстве.

В реальном времени «саундтрек к чему угодно»: Gemini vision + Lyria RT сочиняют музыку из живого видео

Проект HackTX соединяет Gemini 2.0 vision с Lyria Real‑Time для создания музыки вживую из общего экрана или видеопотока, превращая кадр‑уровень «vibes» в постоянно генерируемое аудио project highlight. Команда опубликовала исходную реализацию (Next.js, FastAPI, ffmpeg, websockets) и опубликовала демонстрационный раун, предлагая чертёж для выставления очков на мероприятиях, наложения трансляции или облегчённых пост‑пайплайнов YouTube demo, GitHub repo.

Для творческой инженерии это демонстрирует приемлемую задержку и контроль за генеративным ранжированием без офлайн‑рендеров, а также чистый путь к монетизации мультимодального вывода в веб‑числах.