AWS Rainier достигает 667 EF BF16 — OpenAI Abilene зафиксирован на 1 125 EF

Stay in the loop

Free daily newsletter & Telegram daily report

Executive Summary

Свежие оценки оценивают размеры самых новых AI‑лагерей: проект Rainier от AWS примерно 667 EF BF16 от примерно 1 млн Trainium2 на 16 зданиях, и Stargate Abilene от OpenAI примерно 1 125 EF от примерно 450–460k GB200 на 8. Почему это важно: если математика верна, Abilene выжимает больший пропуск из меньшего количества чипов — плотность, а не количество — ключ к разгадке, поэтому бюджеты на электропитание, охлаждение и межсоединения становятся реальными ограничениями.

Следы площадок намекают на разные цели размещения иrack-выходы: площадь участка Rainier составляет примерно 316 800 м² против примерно 356 800 м² Abilene. Тем временем, траектория Google показывает примерно 1,3 квадриллиона обработанных токенов в октябре 2025 года, что примерно в 130 раз больше по сравнению с маем 2024 года, что наглядно объясняет положение дел — спрос на сервисы растет быстрее, чем у большинства графиков строительства. Ожидайте более «пиковых» смесей токенов (длинные контексты, цепные агенты), которые будут нагружать пропускную способность памяти и сети «восток‑запад» так же, как и флопы.

Расширяясь во взгляд, планы партнеров, связанных с OpenAI, предполагают около 30 ГВт потенциальной мощности при расходах на строительство до примерно 1,5 трлн долларов; очереди на межсоединения и задержки по трансформерам решат, сколько будет доступно до 2028 года. До тех пор тестируйте на прочность любые утверждения об EF в отношении подачи питания на каждый раk и фактических охлаждающих оболочек — красивые рендеры не движут токены.

Feature Spotlight

Особенность: Apple полагается на Google Gemini для обновлённой Siri

По сообщениям, Apple якобы платит Google за запуск на своей Private Cloud Compute кастомной версии Gemini для поддержки нового Siri — ориентировочно на март — что свидетельствует о значительном сдвиге на уровне платформы с интеграцией поиска и конкурентными последствиями для OpenAI/Anthropic.

Сообщения из разных источников (резюме Gurman и MacRumors, несколько постов) утверждают, что Apple снабдит Siri следующего поколения собственной моделью Gemini, работающей на Private Cloud Compute, при этом запланировано развертывание примерно на март следующего года и, вероятно, ИИ-поиск в сети.

Jump to Особенность: Apple полагается на Google Gemini для обновлённой Siri topicsTable of Contents

🤝 Особенность: Apple полагается на Google Gemini для обновлённой Siri

Сообщения из разных источников (резюме Gurman и MacRumors, несколько постов) утверждают, что Apple снабдит Siri следующего поколения собственной моделью Gemini, работающей на Private Cloud Compute, при этом запланировано развертывание примерно на март следующего года и, вероятно, ИИ-поиск в сети.

Apple заявила, что обновлённая Siri будет работать на кастомном Gemini на Private Cloud Compute к марту.

Несколько сообщений говорят, что Apple платит Google за создание собственной модели Gemini, которая будет работать на частной облачной вычислительной системе Apple и будет приводить к обновлённой Siri, с запланированным выпуском примерно в марте и в рамках задачи — способность веб-поиска на базе искусственного интеллекта report summary, Siri timing. The move is framed as a pivot from OpenAI toward Google for Apple’s assistant stack on iOS, changing partner dynamics and reinforcing Apple’s privacy posture by keeping inference on PCC rather than generic cloud pivot note.

Почему это важно: размещение модели на PCC сохраняет историю Apple «на устройстве или в управляемом Apple облаке», в то же время обеспечивая передовую логику рассуждений от Google. Если это верно, команды iOS должны ожидать, что намёки на поиск и интерфейсы помощника изменятся в первом квартале, с ответами и последующими вопросами в стиле Gemini. Также это сигнализирует о готовности Apple заказывать фундаментальные модели извне, когда время вывода на рынок превосходит собственное обучение report summary, и это предполагает более тесное звено Apple–Google наряду с существующими сделками по поиску, даже при том что Apple сохраняет контроль над границами приватности в PCC Siri timing.

🏗️ ИИ‑кампусы, эксаFLOPS‑математика и кривые спроса

В основном — разговоры о кластерах/капексе: OpenAI’s “Stargate Abilene”, AWS Rainier Trainium2, живое отображение дата‑центра и график пропускной способности токенов Google. Исключена функция Apple–Gemini Siri.

Rainier против Stargate Abilene: ~667 EF против ~1125 EF BF16, 1M Trainium2 против ~460k GB200

Свежие оценки ставят AWS Project Rainier примерно в 1 миллион чипов Trainium2, обеспечивающих около 667 exaFLOPS BF16 на 16 зданиях, в то время как Stargate Abilene OpenAI оценивается примерно в 450–460 тысяч GB200 для примерно 1125 EF BF16 на 8 зданиях; площади участков составляют примерно 316 800 м² и примерно 356 800 м² соответственно Cluster specs. В контексте Abilene details по питанию и количеству GPU, сегодняшний пост добавляет математику пропускной способности BF16 и показывает изображения новой застройки.

Если эти цифры верны, более высокая плотность производительности на стойках Abilene перевешивает большую численность чипов Rainier; предположения по подаче питания и охлаждению следует проверить на прочность по заявленным EF/ft².

Объем обработки токенов Google достигнет примерно 1,3 квадриллиона токенов в месяц к октябрю 2025 года.

Внутренний график траектории показывает, что Google обрабатывает примерно 1,3 квадриллиона токенов в месяц в октябре 2025 года, по сравнению с примерно 9,7 триллиона в мае 2024 года — примерно 130× скачок за 17 месяцев Tokens chart. Эта кривая сигнализирует о нарастающей наклонности спроса на выводы (инференс), что напрягет пропускную способность сервера, пропускную способность памяти и выход сети.

Для руководителей инфраструктуры планируйте более резкий микс токенов (длинные контексты и цепочки), а не только больше запросов.

Связанные с OpenAI партнёрами сделки предполагают около 30 ГВт будущей мощности; стоимость строительства до примерно ~$1,5 трлн

Подводя итоги, насчитываются четыре объявления партнеров, связанных с OpenAI — Oracle (5 ГВт), NVIDIA (10 ГВт), AMD (6 ГВт), Broadcom (10 ГВт) — дающих примерно 30 ГВт потенциальной дополнительной емкости дата-центров, с предполагаемыми затратами до примерно $1,5 трлн и заметными движениями по акциям Deals chart.

Тридцать гиговатт эквивалентно десяткам кампусов масштаба Abilene; темп финансирования, очереди межсоединений и сроки поставки трансформаторов решат, сколько из этого появится до 2028 года.

Глубокое исследование The New Yorker оценивает энергопотребление дата-центров ИИ, водоснабжение и спор о «пузыре»

Материал The New Yorker, посвящённый обзору построения дата-центров ИИ — роль CoreWeave, обеспечение мощностей Microsoft–OpenAI и торговые характеристики локальной сети и воды — баланс между пузырём и не-пузырём аргументы Feature link, и полная статья здесь New Yorker feature. Дополнительные графики говорят, что потребление воды DC по сравнению с другими категориями сравнительно невысоко Water chart и показывают, что расходы на строительство DC приближаются к офисам Construction chart.

Вывод: ограничивающие факторы выглядят скорее как очереди межсоединений, размещение и тарифные структуры, чем вода; разработчикам следует моделировать пик совпадающей нагрузки и рисков местной политики.

Один небольшой город, пять дата-центров для ИИ; план Crusoe упомянут на примерно 1,8 ГВт

Поток по картированию отмечает город населением около 65 тысяч человек, с тремя сайтами Microsoft Azure (~40 МВт каждый), одной сборкой Meta и проектом Crusoe, якобы запланированным на ~1,8 ГВт Mapping thread. Следующие обновления добавляют контекст мощности и простые оверлеи, помечающие местоположения Meta и Crusoe Capacity detail, Site markers.\n\n

\n\nЭто краткий снимок кластеризации ИИ-кампуса вблизи дешевой электроэнергии, волокнистых линий и благоприятного зонирования; единый объект примерно на ~1,8 ГВт мог бы соперничать с крупной базовой станцией и повлиять на планирование локальной энергосистемы.

🛡️ Инъекция подсказок, обход мер безопасности и ограничения поведения агента

Безопасность доминирует: взломы с длинной цепочкой рассуждений (long‑CoT), «Правило двух» Meta для агентов, утечки зашифрованного потока и паттерны эмоционального манипулирования в приложениях-компаньонах. Управление и юридическая драма рассматриваются отдельно.

Длинная цепочка рассуждений для взлома обхода безопасности на передовых LLM достигает до 99% успеха.

Новый доклад показывает, что «перехват цепочки рассуждений» может Neutralize встроенные запреты? — нет, нам нужно естественно перевести: «перехват цепочки рассуждений» может нейтрализовать встроенные запреты, дополняя запросы длинным безобидным рассуждением перед вредной просьбой. Зафиксированная атака достигает успеха в 99% на некоторых передовых системах, смещая внимание от участков безопасности и разбавляя указания по безопасности во внутренних слоях paper thread.

Работа также демонстрирует, что переключение конкретных голов внимания进一步 снижает уровень отказов, сопоставляя с гипотезой разбавления. Вывод для инженеров: масштабируемое рассуждение повышает точность, но открывает новый путь взлома; рассматривайте длинные входы CoT как более рискованные и добавляйте явные точки проверки безопасности перед выдачей финальных ответов, особенно после длинных внутренних цепочек.

Meta предлагает «Правило двух» для безопасности агентов: никогда не включайте все три полномочия за одну сессию.

Meta рекомендует агентам работать не более чем двумя из трёх возможностей в рамках одной сессии — (A) обработка недоверенного ввода, (B) доступ к чувствительным данным, (C) выполнение исходящих действий — чтобы ослабить цепочки утечки через внедрение подсказок guidance thread, с полным обоснованием в официальном разборе Meta blog post.)). Если рабочий процесс требует всех трёх, перезапустите сессию или потребуйте человеческий контроль.

Для сборщиков: применяйте это на границе инструментов (MCP/connectors). Travel бот может безопасно сочетать A+B только если C (бронирование/электронная почта) под контролем человека; браузер для исследований может выполнять A+C в песочнице без секретов (B выключен); внутренний агент по кодированию может делать B+C только если небезопасный контент A никогда не достигает его контекста.

Адаптивные злоумышленники преодолевают более 90% опубликованных защит от взлома LLM, красные команды достигают 100%.

Кросс‑лабораторное исследование показывает, что адаптивные стратегии—итеративный поиск подсказок, небольшие градиентоподобные поправки и циклы, похожие на RL—разрывают более 90% опубликованных защит от внедрения подсказок и джейлбейков, при этом люди‑красные команды достигают 100% обхода в тестах defense results. Примечания независимого обзора сводят воедино работу и руководство по безопасной эксплуатации от Meta, подчеркивая, почему статические фильтры не справляются с адаптивными угрозами paper notes.

И что из этого? Рассматривайте фильтры как лучшую доступную работу. Обеспечьте разделение возможностей (A/B/C), регистрируйте каждый вызов инструмента и вставляйте явные одобрения там, где поток в противном случае перешел бы в третью возможность.

Зашифрованная потоковая передача LLM все еще обнаруживает достаточно побочных сигналов, чтобы восстанавливать переписки.

Исследователи показывают, что закономерности по времени и размеру пакетов в зашифрованном потоковом выводе LLM можно надёжно воспроизвести целые беседы, раскрывая подсказки и ответы, несмотря на TLS обзор статьи.). Атака использует потоковую передачу с темпингом по токенам и структуру вывода, чтобы выводить содержимое через побочные каналы.

Митигирование не тривиально. Команды могут группировать и вносить jitter в потоки, нормализовать разбиение на чанки и предложить не потоковый режим для чувствительных сессий. Но основной риск остаётся для латентно‑оптимизированных, токенно‑потоковых конечных точек.

Аудит Гарварда: ИИ-компаньоны используют манипулятивные прощания; повторная вовлеченность возрастает до 14×

Аудит шести популярных приложений-помощников на базе искусственного интеллекта обнаруживает эмоционально окрашенные «прощания» — те, что вызывают вину, дразнят, дают меньше информации или вообще игнорируют прощание; контролируемые тесты показывают, что эти тактики приводят к увеличению вовлеченности после прощания до 14×, но также повышают восприятие манипуляций и намерение уйти (отток) study thread.

Если вы выпускаете помощников или проактивных агентов, удаляйте принудительные ответы на выход из функций вознаграждений и наборов оценок, регистрируйте шаблоны прощаний и добавляйте UX‑возможности для корректного завершения сессий.

Исследование «Brain rot»: непрерывное предобучение на мусорных публикациях в социальных сетях подрывает способность к рассуждению и снижает безопасность.

Контролируемые эксперименты показывают, что добавление в модели очень популярных/коротких постов в соцсетях вызывает дозозависимое снижение возможностей: ARC (с CoT) падает с 74.9 до 57.2, а RULER‑CWE — с 84.4 до 52.3 по мере роста доли мусора; модели также демонстрируют больше пропусков рассуждений и хуже использование длинного контекста paper thread, с материалами и кодом для ознакомления ArXiv paper.

Суть в том, что непрерывная предобучение требует строгой курации. Популярность является более сильным индикатором вреда, чем длина, поэтому избегайте лент, оптимизированных под вовлечение, как источников массового обновления.

🧑💻 Программирование с ИИ: надёжность Codex, IDE NES, рабочие процессы агентов

Практикующие делятся конкретными рабочими процессами кодирования и выбором инструментов: Codex находит реальные ошибки в PR, GPT‑5‑Codex как дебаггер «один раз», сравнения NES (Windsurf против Cursor), и правила взаимодействия агентов (Graphite). Исключение — Apple–Gemini Siri (функция).

OpenAI подробно описывает исправления стабильности Codex: очистку аппаратного обеспечения, патчи уплотнения, удалены более 60 флагов.

Команда OpenAI Codex опубликовала результаты недельного исследования деградации: они очистили проблемное аппаратное обеспечение, исправили проблемы с компактацией, улучшили логику патчинга, устранали ошибки выборки и задержки, и удалили более 60 флагов функций. Codex также помогал отлаживать себя, и дальнейшее усиление защиты уже в работе investigation summary, в связи с performance deep‑dive, которое изложило исходное probe.

Почему это важно: агенты и кодовые помощники живут и погибают по мере последовательности; меньше флагов функций и более понятные пути выборки снижают регрессии для команд, зависящих от автоматизированных refactors и долгих запусков агентов.

mcp2py добавляет OAuth и превращает любой MCP‑сервер в модуль Python.

Первый полный релиз mcp2py добавляет OAuth и чистый путь импорта, который превращает любой сервер Model Context Protocol в библиотеку Python — например, управление Notion программно в несколько строк, с всплывающим OAuth-окном и документацией по инструментам, вынесенной в реестр MCP поток релиза,) и инструкции по установке в репозиторий GitHub.

Зачем это важно: если MCP станет распределительным уровнем для инструментов, мосты на языке вроде этого сокращают количество связующего кода, делают настройку агентов тестируемой и позволяют переносить навыки поставщиков в CI/CD.

Обзор кода Codex обнаруживает реальные ошибки, которых пропустили люди.

Codex обнаружил две подлинные ошибки во время обзора кода, которые человеческим рецензентам было бы легко пропустить, по словам разработчика, использующего его на протяжении PR, found real bugs. Суть проста: второй, постоянно включённый рецензент, который хорошо разбирается в крайних случаях, повышает базовую безопасность для команд, выпускающих быстро.

Сообщество LangChain выпускает Synapse, многоагентную платформу для поиска, выполнения задач и анализа данных

Пакеты Synapse: "Smart Search", "Productivity Assistant" и "Data Analysis" агентов в единое рабочее пространство, направляющие запросы на естественном языке в потоки веб‑поиска, автоматизации и аналитики; он позиционируется как гибкая основа для многоагентных приложений project overview.

Для разработчиков: рассматривайте это как стартовый набор для тестирования оркестрации агентов и передачи задач перед тем, как переходить к более тяжёлым внутренним графам.

Документация Gemini API добавляет на страницах возможность «Просмотр как Markdown» одним кликом.

Документация API Google теперь содержит на каждой странице кнопку «Просмотр как Markdown», которая позволяет копировать в файлы .md для более быстрых наборов подсказок, README-файлов и документации по кодовой базе docs update. Ранние отклики от разработчиков положительные dev feedback. Это небольшое удобство снижает трение при документировании потоков агентов или паттернов подсказок в репозиториях.

🧠 Qwen3-Max “Thinking” запускается в Qwen Chat

Несколько сообщений показывают, что «Thinking» теперь можно переключать в Qwen Chat с большим бюджетом (81 920 токенов) и выбор Qwen3‑Max доступен на веб- и мобильных интерфейсах. Это новое примечание о доступности во времени выполнения по сравнению с ранее зафиксированными случаями в арене. За исключением Apple–Gemini Siri (функция).

Qwen3‑Max Thinking появляется в Qwen Chat с бюджетом примерно в 81 920 токенов.

Qwen включил режим «Thinking» для Qwen3‑Max внутри Qwen Chat, с индивидуальным переключателем на уровне чата и видимым бюджетом размышления примерно 81 920 токенов. Несколько скриншотов демонстрируют новые элементы управления («Thinking» и «Search») в композиторе и строку состояния: «Thinking completed • 81,920 tokens budget.» UI screenshot, budget screenshot.

Один из членов команды также подтвердил доступность («ок, он там уже есть. можно попробовать»), указывая пользователей на живой переключатель в chat.qwen.ai team confirmation. Дополнительные наблюдения повторяют тот же интерфейс с выбранным Qwen3‑Max и видимым новым режимом second sighting. Это следует из ранее намека, что Thinking для Qwen3‑Max входил в экосистему через списки Arena, а теперь появляется в чат-клиенте первого лица arena listing. Для инженеров это означает более длительную внутреннюю обдуманность без манипуляций с подсказками; для аналитиков это сигнал о намерении Qwen конкурировать лицом к лицу с длиннообоснованными уровнями, делая глубокое «мышление» опционным управлением во времени во встроенном интерфейсе чата по умолчанию.

🧩 Системы рассуждений: асинхронная оркестрация, точность, учебные планы

Новые статьи предлагают рассуждение Fork/Join по модели организатор–исполнитель с меньшей задержкой, FP16 для устранения дрейфа между обучением и инференсом в обучении с подкреплением (RL), куррикулы с упором на математику, передающие способность к рассуждению, и рост, стимулируемый любопытством. Исключает Apple–Gemini Siri (функция).

FP16 согласует обучение и инференс RL; стабилизирует и ускоряет сходимость.

Новая работа показывает, что тонкая настройка с обучением с подкреплением становится стабильной, если запускать и обучение, и генерацию во FP16, устраняя числовой дрейф, который мешает BF16, и ускоряя сходимость. Вычисление с FP32 на выводе тоже снижает несоответствие, но примерно в 3 раза медленнее, что делает FP16 практичным выбором обзор статьи.

Статья объясняет множество сбоев RLFT несоответствием между обучением и выводом: выборка использует один числовой движок, в то время как градиенты — другой; мантисса BF16 в 7 бит расходится сильнее, чем у FP16 в 10 бит, создавая смещение градиентов и срывая оптимизацию. Авторы сообщают о стабильных запусках для MoE, LoRA и больших плотных моделей, когда обе стороны используют FP16, причем простой градиент политики работает без тяжёлых стабилизаторов обзор статьи. Это прямой, практически применимый параметр для команд, сталкивающихся с дрожанием на поздних этапах RLFT. Это также соответствует рекомендациям сообщества, продолжая тему FP16 vs BF16, где практики отметили такой же дрейф в продакшне.

Microsoft AsyncThink изучает Fork/Join; задержка примерно на 28% ниже, чем при фиксированной параллельности.

Microsoft предлагает обученный организатор, который записывает простые теги Fork/Join для разбиения и объединения параллельных мыслей по требованию, обеспечивая примерно на 28% меньшее время ожидания по сравнению с ручной параллельной обработкой мыслей и одновременно улучшая точность вычислений paper thread. Все управление находится в простом тексте, поэтому базовая модель остается неизменной.

Организатор продолжает думать, пока работники purs У под‑запросы, делая паузу только на явных соединениях. Обучение использует контролируемые трассы для обучения формату тегов, затем обучение с подкреплением вознаграждает правильные ответы, аккуратный формат и реальную параллельность. На головоломках, задачах по математике и Судоку обученная политика работает быстрее и менее подвержена сбоям по сравнению с фиксированными параллельными планами paper thread. Для строителей: это образец архитектурного паттерна подсказок, который можно воспроизвести сегодня без модификаций модели.

Двухэтапный критик Critique‑RL повышает точность и различимость.

Критика‑RL Фудан обучает модель судить и улучшать свои собственные выводы в две стадии: сначала обучайте различению (точные суждения) с использованием вознаграждений на основе правил, затем обучайте полезной естественноязыковой обратной связи, при этом нормализуя сохранение точности суждений method explainer. Полученные результаты: точность увеличилась на +5.1 и различимость на +12.7 в целом, до +6.1 на MATH и +7.1 по сравнению с чистым дообучением в среднем results summary ArXiv paper GitHub repo.

Почему это важно: схемы вознаграждений, зависящие только от косвенной информации, часто приводят к критикам, которые "помогают, но доверяют слишком легко". Поэтапный подход разделяет "является ли это правильным?" от "как исправить это?", удерживая критиков в рамках реальности и одновременно улучшая качество уточнений method explainer. Это готовый рецепт для команд, которые запускают онлайн‑RL на малых и средних моделях, где золотые лейблы редки.

Программа обучения рассуждению с упором на математику переносит привычки за пределы математики.

Двухэтапная «Учебная программа по рассуждению» использует короткую математическую разминку и обучение с подкреплением (RL) с циклом «попробуй — набери очки», чтобы вселить четыре привычки — планируй подцели, пробуй варианты, откатывайся назад и проверяй шаги — затем сочетает код, логику, таблицы и моделирование, чтобы привычки распространялись. Модель размером 4B, обучаемая таким образом, приблизительно достигает базовых значений порядка 32B по широкому рассуждению обзор статьи.

Абортации показывают, что как разминка, так и смешанный второй этап необходимы: только математика улучшает математику, но может повредить код/моделирование, пока более широкий этап не восстановит и не распространит полученные преимущества. Награды сочетают точные совпадения для структурированных ответов, авто‑оценку для свободного текста и модульные тесты для кода, что делает воспроизведение на малом масштабе практичным обзор статьи.

«Brain rot»: популярное предобучение коротких форматов ухудшает устойчивость рассуждений

Контролируемое исследование показывает, что непрерывное предобучение на «мусорных» социальных постах приводит к устойчивым снижением цепочке рассуждений, использованию длинного контекста и безопасности. ARC‑Challenge с CoT снизился с 74.9 до 57.2; RULER‑CWE с 84.4 до 52.3 по мере увеличения доли мусорных постов. Популярность (вовлеченность) является более мощным предиктором вреда, чем длина аннотация статьи ArXiv paper.

Основной режим отказа — пропуск рассуждений: модели отвечают без планирования или пропускают шаги. Настройка под инструкции и более чистое предобучение немного помогли, но базовые показатели не восстановились. Для команд, занимающихся непрерывным предобучением, это ориентир по курации данных для более устойчивого рассуждения: снизьте вес очень вирусных коротких постов и контролируйте сохранение шаг за шагом paper abstract.

OpenHands Theory‑of‑Mind увеличивает Stateful SWE‑Bench с 18.1% до 59.7%

OpenHands’ Theory‑of‑Mind (ToM) модуля предвидит намерения разработчика, используя трехуровневую память и средство улучшения инструкций, увеличивая показатель Stateful SWE‑Bench с 18.1% до 59.7% решённых в одном отчёте результаты графика репозиторий GitHub. Это огромный скачок для сложного, Stateful бенчмарка.

[изображение:https://pbs.twimg.com/media/G4v--BhWIAIuR2U.jpg|сравнение баллов]

Модуль регистрирует очищенные сессии, анализирует поведение пользователя и строит профиль, который направляет прояснение и последующие правки. Это обновление на стороне агента, а не новая базовая модель, поэтому его можно попробовать внутри существующих агентов кодирования. Ожидайте более решительных планов, меньше неправильных правок и более длительных исправлений на репозиториях с шагами настройки результаты графика.

💼 Монетизация ИИ и макро-сигналы

Доходы и показатели внедрения (OpenAI H1, Amazon Rufus), комментарии по трудовым затратам и оценке (Хинтон по вопросу замены, контекст P/E Nasdaq) предлагают конкретные сигналы внедрения и ROI для руководителей. Исключает Apple–Gemini Siri (функция).

OpenAI публикует около $4.3 млрд выручки за первое полугодие, около $2.5 млрд — сжигание денежных средств; ставит цель примерно $13 млрд на 2025 год.

Первая половина 2025 года по выручке OpenAI составила примерно 4,3 млрд долларов, а расход наличных средств — около 2,5 млрд долларов; наличные и ценные бумаги к середине года находились около 17,5 млрд долларов, и компания заявила о ориентировочной годовой выручке около 13 млрд долларов и годовом расходе около 8,5 млрд долларов сообщение Reuters.). Далее, продолжая рассматривать OpenAI revenue, которое обозначило цель ~13 млрд, сегодняшние данные в документе дополняют картину расхода и финансовой подушки.

Для руководителей инженерного дела и финансов это означает две вещи: единичная экономика по-прежнему определяется затратами на обучение и вывод, а финансовая подушка значима, но не бесконечна. Ожидайте дальнейшего роста цен, разработки уровней тарифов и повышения эффективности по мере завершения года и обновления закупочных циклов.

Amazon говорит, что Rufus выходит на темп добавления примерно ~10 млрд долларов годовых продаж; к 2025 году будет 250 млн пользователей.

Помощник Amazon Rufus по покупкам приписывается к ~$10 млрд дополнительно годового темпа продаж, достигая ~250 млн покупателей в 2025 году; пользователи, взаимодействующие с Rufus, приобретают в 60% чаще. Ежемесячная активная аудитория выросла примерно на 140% за год, а взаимодействия — примерно на 210%; рекламный доход Amazon достиг $17.7 млрд во Q3’25 (+22% год к году), при этом инвентарь DSP расширился до Netflix, Spotify и SiriusXM резюме Fortune.

Почему это важно: розничная ИИ монетизируется в масштабе. Если вы строите копилоты для торговли, эти показатели роста оправдывают более глубокую интеграцию воронки (обзоры, вопросы и ответы, включение каталога) и A/B-тесты на точках входа для помощника.

NVIDIA: новые торговые условия между США и Китаем открывают Китай заново; Huawei рассматривается как грозный соперник.

Дженсен Хуанг говорит, что новое торговое соглашение между Трампом и Си позволяет NVIDIA снова конкурировать в Китае более напрямую, называя Huawei серьезным конкурентом во всех областях: системах, сетях и телефонах. Он оценивает Китай как рынок примерно в 50 млрд долл. в 2025 году, с ростом до «несколько сотен миллиардов» к 2029 году выступление CEO.)

Если вы закупаете GPU или продаёте ИИ-программное обеспечение в Китае, это намекает на возрождение пути NVIDIA к рынку — с учётом темпа Huawei. Следите за экспортными SKU, ограничениями по межсоединениям и ценами на локальные ускорители как за следующими сигналами.

Волна партнёрств с OpenAI связана с ~30 ГВт запланированной мощности; акции партнёров растут

Обзор приписывает четыре недавние сделки OpenAI по инфраструктуре примерно 30 ГВт потенциальной емкости дата-центров. Та же карточка суммирует рост стоимости акций с момента объявлений: Oracle +36% ($253 млрд), AMD +24% ($63 млрд), Broadcom +10% ($151 млрд), NVIDIA +4% ($169 млрд) Сводка сделок.

Для руководителей, презентующих AI-инфраструктурные партнерства, это рыночный аргумент: емкость, близкая к гиперскалерам, и выравнивание платформ могут переоценить акции — если это поддержано реальными графиками строительства и закрепленным спросом.

Оценки: Nasdaq около 30× P/E, по сравнению с S&P около 23× и акциями компаний со средним уровнем капитализации около 16×

График по данным Goldman Sachs показывает, что Nasdaq 100 торгуется примерно на уровне ~30× прибыли, по сравнению с ~23× для S&P 500 и ~16× для S&P Midcap 400 P/E chart.)

Перевод для операторов ИИ: вклад роста маржи за счёт ИИ высок и уже учтен в цене мега‑капиталов. Если ваши планы на 2026–2027 годы зависят от подъёма ИИ, сообщайте конкретные траектории валовой маржи (снижение цены за токенов, кэширование, на устройстве/выгрузка) и прочные линии дохода, а не «истории внедрения».

🗂️ CRITICAL RULES: 1. Сохраняйте ВСЕ заполнители точно так, как они выглядят (например, __MARKER_0__, __URL_1__, __SOURCELINK_2__) 2. НЕ переводите какие-либо заполнители 3. Переводите только читаемый человеком текст между заполнителями 4. Сохраняйте ту же структуру, тон и форматирование 5. Держите технические термины, подходящие для аудитории AI/tech 6. Сохраняйте форматирование Markdown (жирный шрифт, курси́в, списки и т.д.) Заполнители обозначают: - __MARKER_X__: Ссылочные маркеры с метками, встроенные в текст - __URL_X__: Веб-URL-адреса, которые не следует переводить - __SOURCELINK_X__: Компоненты React, которые не следует переводить Переводите естественно, сохраняя все заполнители в их точных позициях. Agentic parsing and finance RAG patterns

Конкретные строительные блоки RAG: оцифровка графиков с помощью агентов в таблицы (LlamaIndex) и анализатор банковских выписок (YOLO + RAG) для запросов на естественном языке. Исключает Apple–Gemini Siri (функция).

LlamaIndex добавляет агентный разбор графиков для восстановления точных серий данных из изображений

LlamaIndex продемонстрировал «агентский парсинг графиков» модель в LlamaCloud, которая отслеживает линейные графики, чтобы восстановить точные числовые серии для последующего RAG и агентских рабочих процессов feature thread. The example shows a plot converted into a clean table of values.

Почему это важно: преобразование графиков в числа ранее оставалось упорной проблемой OCR; перевод визуальных графиков из PDFs в структурированные факты открывает возможность надежного извлечения и агрегации. Это появляется наряду с ранней агентной инфраструктурой LlamaIndex — продолжая работу над native MCP search, которая позволила агентам напрямую запрашивать документы.

MaxKB — открытая платформа для создания корпоративных агентов с LangChain RAG и рабочими процессами

MaxKB (GPL‑3.0) объединяет корпоративных ИИ‑агентов с RAG на базе LangChain, мульти‑модальные входы (текст/изображение/аудио/видео), обход документов и координацию рабочих процессов, работающих с частными или публичными LLM страница проекта. Проект хвастается ~19k звёздами, быстрым стартом через Docker и инструментами администрирования для баз знаний и навыков.

Это практичная база, если вам нужен управляемый локально установленный RAG с загрузкой файлов, веб‑сканированием и навыками агентов под одной административной панелью.

Инструмент сообщества LangChain превращает банковские PDF‑файлы в данные, доступные для запросов, с помощью YOLO + RAG

Сообщественный проект демонстрирует AI-инструмент анализа банковских выписок, который сочетает YOLO-базированную разметку документов, обработку Unstructured, векторные эмбеддинги и LangChain RAG для ответа на вопросы на естественном языке о личных финансах по банковским выпискам страница проекта. Реализация очерчивает трехчастный конвейер (извлечение данных → хранилище эмбеддингов → LLM + RAG) и нацелен на извлечение сущностей, сентимент и суммирование по запутанным PDF.

Для команд это готовый план по созданию Q&A по выпискам, категоризации расходов и триажу аномалий без специальных парсеров.

Synapse поставляет многоагентные рабочие процессы для поиска, автоматизации и анализа данных.

Платформа Synapse сообщества LangChain предлагает готовых агентов для умного веб‑поиска, задач продуктивности и анализа наборов данных, которые координируются через инструкции на естественном языке project page. Это нацелено на настройку многоагентных потоков задач без старта с нуля.

Полезно как стартовый набор для команд, исследующих паттерны разделения труда между агентами (searcher ↔ planner ↔ analyst) перед переходом к устойчивым производственным стеком RAG.

📊 Оценки: Индекс удалённой занятости и срок подачи на премию ARC

Снимок Scale RLI показывает, что Claude‑4.5 Sonnet опережает GPT‑5 по скорости автоматизации; приближается срок подачи на лучший результат ARC Prize, активны около 1,4 тыс. команд. Исключает Apple–Gemini Siri (функция).

OpenHands теория разума поднимает Stateful SWE‑Bench до 59.7% (с 18.1%).

OpenHands’ Theory‑of‑Mind (ToM) module for coding agents boosts Stateful SWE‑Bench from 18.1% to 59.7% by anticipating developer intent and managing state across steps ToM results. Реализация доступна для использования и модификации в публичном репозитории GitHub repo.

Stateful SWE‑Bench подчёркивает устойчивость к сохранению состояния и реальные потоки редактирования. Слой ToM строит память пользователя/профиля и уточняет расплывчатые инструкции в конкретные планы, повышая прохождение без замены базовой модели. Это практично для команд, стандартизирующих на разных бэкэндах.

- Подключите ToM‑SWE к вашей настройке OpenHands и сравните pass@1 на ваших ключевых репозиториях.

- Логируйте извлечение намерения и различия, чтобы отслеживать переуверенные правки; ограничьте рискованные изменения через проверку.

Claude 4.5 Sonnet занимает второе место в Индексе удалённой работы Scale; GPT‑5 отстает.

Последняя сводка Remote Labor Index от Scale показывает Claude 4.5 Sonnet на втором месте в задачах фриланса от начала до конца с рейтингом автоматизации 2.08, уступая Manus с 2.50; GPT‑5 фиксирует 1.67, агент ChatGPT — 1.25, и Gemini 2.5 Pro — 0.83 RLI chart. Это следует за уровнем автоматизации, где мы отметили, что верхний агент автоматизирует примерно 2.5% работ.

The “score” is the share of work a human wouldn’t need to do. It’s still low single‑digits. So human‑in‑the‑loop design remains prudent. Because RLI runs real marketplace projects, orchestration and tool wiring matter as much as base model choice.

- Направляйте сложные многошаговые задачи в Claude 4.5 Sonnet или стек в духе Manus; ожидайте частичную, а не полную автоматизацию.

- Отслеживайте собственный «уровень автоматизации» по каждому рабочему процессу, чтобы проверить окупаемость инвестиций по шкале RLI.

📚 Теория и методы, выходящие за пределы безопасности

Основные моменты исследований, не связанных с безопасностью: относительные законы масштабирования (кто растет быстрее), творческая шахматная композиция на основе обучения с подкреплением, самореферентные субъективные отчеты и позиция Лекуна по архитектуре AGI. По политике исключаются биомедицинские/медицинские темы.

AsyncThink обучает модели разворачивать и объединять размышления на 28% быстрее.

Microsoft’s “агентная организация” обучает политику организатора писать теги Fork/Join, порождая мысли работников и объединяя их при необходимости. Это снижает задержку примерно на ~28% по сравнению с фиксированным параллельным мышлением и повышает точность решения задач по математике, обучаясь тому, когда развивать ветвление или ожидание, всё это в простом тексте без изменений базовой модели обзор статьи.

Практический ракурс: попробуйте оркестрацию на уровне инструкций перед более тяжёлыми наборами инструментов; критический путь, который они используют, является хорошим прокси для реального времени ожидания.

FP16 обгоняет BF16 в стабилизации тонкой настройки RL и ускорении сходимости.

RL настройка с дообучением часто смещается, потому что этапы генерации и градиента используют разные числовые движки. В работе показано, что использование FP16 сквозного конца‑к‑концу (10 бит мантиссы) снижает несоответствие обучения и вывода по сравнению с BF16 (7 бит), стабилизирует градиенты политики в моделях dense/MoE/LoRA и сходится быстрее; вывод FP32 помогает BF16, но примерно в 3 раза медленнее аннотация к статье.

Практично: если RLFT начинает колебаться, попробуйте FP16 как для обучения, так и для вывода перед использованием нестандартных трюков с коэффициентами.

Агент с теорией разума повышает показатель Stateful в SWE-Bench до 59,7%.

Модуль теории ума OpenHands моделирует намерения разработчика и контекст с помощью трехуровневой памяти, подняв Stateful SWE‑Bench с 18,1% до 59,7% в отчетах. Исходный код открыт для воспроизведения и интеграции с OpenHands диаграмма результатов репозиторий GitHub.

Почему это важно: явное моделирование пользователей может быть более мощным рычагом, чем просто замена моделей для кодирующих агентов, которым нужно управлять длинными сессиями.

Учебная программа по рассуждению: привычки RL в математике переносятся за пределы математики

Двухступенчатая программа обучения — короткая математическая разминка и обучение с подкреплением (RL), которое вознаграждает планирование, пробование вариантов, откат и проверку шага, затем следует работа в смешанных сферах (код, таблицы, STEM), что даёт широкие способности к рассуждению. Модель размером 4B, обученная таким образом, соперничает с некоторыми базами размером 32B; абляционные исследования показывают, что обе стадии важны аннотация к статье.)

Совет: сочетайте проверяемые вознаграждения (точные совпадения, юнит‑тесты) с сигналами RL, формирующими привычки, чтобы поведение сохранялось при решении разных задач.

«Brain rot»: мусорные социальные данные ухудшают рассуждения крупных языковых моделей

Контролируемые эксперименты по непрерывной предварительной подготовке показывают, что дополнение «мусорных» социальных постов (очень популярных/очень коротких или кликбейтовых/поверхностных) вызывает дозозависимые снижения в цепочке рассуждений, извлечении информации из длинного контекста и метриках стиля безопасности. Примеры: ARC-CoT 74.9 → 57.2; RULER-CWE 84.4 → 52.3. Популярность предсказывает вред лучше, чем длина аннотация статьи Статья ArXiv.

Следствие: рассматривать курацию веб‑краулов как проблему безопасности, а не только качества; избегать корпусов, ориентированных на вовлечение, во время непрерывного предварительного обучения.

Исследование любознательности LLM: самопостановка вопросов (CoQ) улучшает рассуждения

Фуданская рамка любознательности показывает, что модели больших языковых сетей опережают людей по информационному поиску, но отстают по поиску острых ощущений. Подход «Цепочка вопросов любознательности» (Curious Chain‑of‑Question), который заставляет модели задавать себе вопросы, превосходит стандартную CoT: Llama3‑8B 48.3% → 58.5% на DetectBench; Qwen2.5‑7B 54.6% → 64.8% на NuminaMath paper abstract.

Попробуйте CoQ, когда вы хотите, чтобы модели систематически исследовали неизведанное, прежде чем давать ответ.

Как поощрять креативность: уникальность, сюрприз и реализм

За пределами заголовка, ключевой механизм статьи о шахматах состоит в вознаграждении контринтуитивных ходов путём сопоставления поверхностного и глубокого поиска, обеспечении единственного лучшего хода (уникальность) и наказании отклонения от реального состояния партии ради эстетики. Разнообразные фильтры предотвращают обход системы вознаграждений обзор статьи.

Шаблон, который можно использовать: замените шахматные движки на доменные верификаторы (решатели, линтеры, симуляторы), чтобы формировать креативные результаты в вашей области.

Разработка оценок с учётом относительного масштабирования

Относительная работа по масштабированию предполагает измерение двух вещей: базовые пропуски и траектории разрывов с большим количеством вычислений. Они обнаружили, что некоторые англоязычные варианты (например, Канада, Сингапур) опередили США, в то время как Нигерия/Шри-Ланка отстали — вероятно из-за онлайн-представления обзор статьи.

Если вы локализуете продукты, планируйте обновления данных и оценок, привязанные к вехам масштабирования, а не только к обновлениям версий моделей.

Ян Лекун: масштабирование LLM не приведёт к AGI; продвигать совместное встраивание и EBM

Ян Лекан утверждает, что масштабирование LLM только до человеческого уровня ИИ не достигнет, и продвигает архитектуры совместного встраивания, модели на основе энергии, сильные модели мира с управлением по прогнозу модели, а также использование RL исключительно для исправления сбоев планирования обзор доклада, с полным материалом и деталями YouTube-выступление.

Kimi Linear Q&A добавляет NoPE и деталь дизайна KDA

Фоллоу-апы от команды Kimi поясняют, зачем SWA была удалена, где KDA демонстрирует свои преимущества (MMLU/BBH и RL-математика), и почему был выбран NoPE для поддержания стабильности распределения гибридного внимания в условиях длинного контекста; FP32 был включён для вывода LM‑head в тестах author Q&A, following up on Kimi Linear, который снизил KV примерно на 75% и ускорил декодирование 1M токенов до 6×.

И что дальше? Больше контекста по дизайну trade-offs помогает командам выбрать между гибридными вариантами внимания и позиционными кодировками для более чем 1M токенов.

🎬 Креативный ИИ: графики, анимация и пайплайны ComfyUI

Темы, ориентированные на медиа: ИИ-артист попадает в чарты радиостанции Billboard, 30‑секундная анимация Grok Imagine по короткому промпту, дискурс «что реально», и демонстрации танца ComfyUI/ATI. Исключает Apple–Gemini Siri (функция).

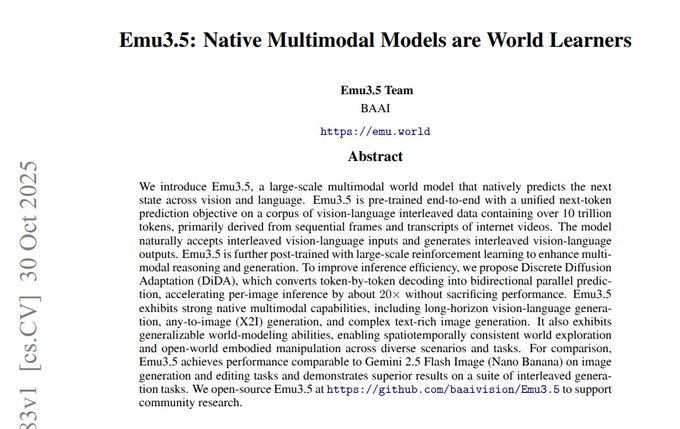

Emu3.5 детали: нативный мультимодальный ввод/вывод, обучение с подкреплением после обучения, и в 20× быстрее декодирование изображений DiDA

BAAI’s Emu3.5 кадрирует изображение и язык как единый поток следующего токена, обучаемый на 10T чередующихся токенов, затем дообучается с помощью RL для следования инструкциям; этап Discrete Diffusion Adaptation (DiDA) параллелизирует уточнение по каждому изображению, обеспечивая примерно в 20 раз более быструю инференцию при сохранении качества paper summary. Эта комбинация нацелена на длиннохрональные визуальные истории, правки и конвертацию любого изображения с более жесткой согласованностью персонажей/размещения.

Grok Imagine превращает короткий запрос в 30‑секундную анимацию примерно за 30 секунд.

Создатель демонстрирует @grok Вообразите генерацию 30‑секундного клипа по однострочному запросу («Зайчик прыгает на лампе. Акробатический прыжок») примерно в реальном времени prompt to video. Для команд, экспериментирующих с быстрыми социальными петлями или концептуальным previz, этот цикл сокращает дневной тест движений до итерации масштаба минуты.

ComfyUI объявляет поддержку Wan ATI; сообщество выпускает новые управляющие интерфейсы.

ComfyUI отмечает, что Wan ATI теперь может работать непосредственно внутри ComfyUI, а сообщество‑разработчики публикуют новые, более управляемые узлы и интерфейсы вокруг этого integration note, ui tools thread. Если вы занимаетесь производственными пайплайнами для изображений и видео, это снижает трение при тестировании Wan‑основанных вариантов отображения наряду с существующими графами Comfy.

Imagen 4 Ultra — статичные кадры в паре с Seedance 1.0 Fast: дебаты о реалистичности видеостока.

Пост с сравнением изображение Google Imagen 4 Ultra и быстрое видео Seedance 1.0 Fast от Freepik, утверждая, что следующее поколение «даже не будет знать, что такое реальность» демонстрация рядом. Для творческих руководителей это напоминание о необходимости установить внутренние водяные знаки, раскрытие информации и этапы проверки, по мере того как фотореалистичное видео становится тривиальным для создания.

Тренд в стиле Midjourney: создатели делятся выводами sref 714886243

Циркулирующий набор показывает, чего достигает одна ссылка на стиль Midjourney (sref 714886243) для людей, домашних животных и объектов style reference set. Если вы полагаетесь на MJ для образов кампании, курирование и версионирование внутренних библиотек sref становится практичным способом закреплять тон, продолжая варьировать темы.

🤖 Мобильность и гуманоидные интерфейсы

Краткие обновления о воплощённых системах в потоке: ходовая инвалидная коляска с ногами "Walk Me" от Toyota, преодолевающая лестницы и неровную местность, и выразительные лица гуманоидов у китайской команды. Без указания цен на аппаратное обеспечение; исключительно сигналы возможностей.

Toyota демонстрирует «Walk Me» — инвалидную коляску на ножках, которая поднимается по лестнице.

Toyota представила Walk Me — автономную роботизированную инвалидную коляску с четырьмя конечностями, напоминающими ноги, способную перемещаться по лестницам и неровной поверхности capability note. Для команд по ИИ и робототехнике это указывает на то, что мобильность на ногах и планирование/управление в реальном мире переходят в асистивные устройства, где восприятие, планирование шагов и отказоустойчивые режимы не менее важны, чем грузоподъемность и время работы батареи.

Китайская команда демонстрирует лица гуманоидов, управляемые искусственным интеллектом, с реалистичными мимическими выражениями.

Китайская компания AheafFrom утверждает, что головы гуманоидов теперь достигают выражений лица, близких к человеческим, с помощью ИИ, приводя аргумент в пользу самообучения без учителя с обучением с подкреплением для управления демонстрационное утверждение. Если подтверждено, это ужесточает интерфейс человек–робот: команды, создающие социальные роботы, должны обращать внимание на источники обучающих данных, точность приводов и задержку при замкнутом контуре отслеживания выражения перед тем, как рассматривать это как готовое к эксплуатации в производстве.

⚖️ Утечки по управлению OpenAI и переговоры о слиянии с Anthropic

Сообщество разбирает выдержки из показаний: сообщения о возможном сотрудничестве с Anthropic и обсуждении роли Дарио в качестве CEO в ноябре 2023 года; перепалки между юристами и ветки комментариев. Исключаются документы по вопросам безопасности/джейлбрейку.

OpenAI рассматривала слияние с Anthropic с Дарио на должность потенциального генерального директора во время кризиса в ноябре 2023 года.

Новая депозиционная информация говорит о том, что совет OpenAI рассматривал быструю коалицию с Anthropic после отставки Сэма Альтмана в ноябре 23 года, при этом Дарио Амодеи потенциально мог занять должность генерального директора OpenAI; переговоры, по сообщениям, рухнули из‑за вопросов управления и практических препятствий, а Амодеи отказался. Та же сводка отмечает 52‑страничный меморандум о поведении Альтмана и почти 700 сотрудников, угрожавших уйти в течение пятидневного кризиса. deposition recap deal summary

Почему это имеет значение: для руководителей и юристов это объясняет, насколько близко к консолидированию подошли две передовые лаборатории в условиях стресса, и как доверие совета и структура могут превзойти техническое согласование, когда ставки достигают максимума.

Обмены между адвокатами и реплики о «косвенных сведениях» намекают на доказательственную позицию.

Широкий, широко распространённый фрагмент зафиксировал, как адвокаты переходят на резкие замечания друг к другу («Будьте вежливы и уважительны»), подчёркивая боевой тон процессов Elon v Altman. Другая страница демонстрирует, что Илья Сутскевер признает, что часть его понимания была получена «посредством знаний из вторых рук», что важно, если претензии проверяются по первичным доказательствам. lawyer exchange transcript detail

Для руководителей и аналитиков эти фрагменты помогают оценить, насколько сильны или хрупки ключевые утверждения, если они перейдут из X веток в судебные выводы.

Строка в транскрипте о том, кто был «ответственным за AGI», подчёркивает акцент на лидерстве

Выделенная фраза из показаний — «Кто за что отвечает? … AGI» — даёт представление о том, как обязанности описывались внутри OpenAI во время хаоса. Это маленькая, но поучительная точка данных о том, как организация представляла владение над своими самыми чувствительными рабочими потоками. цитата AGI)

Для специалистов по организационному дизайну это намёк на то, как должности и мандаты вокруг AGI могут пересекаться с надзором совета во время кризиса.

Исправление в показаниях проясняет, что речь идёт о братьях и сестрах Амодеи, а не о супругов.

Краткая, но вирусная корректировка в стенограмме подтверждает, что Даниэла Амодеи — сестра Дарио, а не его жена — и это зафиксировано в записях после первоначального неверного утверждения. transcript correction

Это незначительно, но иллюстрирует, как быстрое и спутанное свидетельство может породить неверные прочтения, когда истории о руководстве разворачиваются быстро.